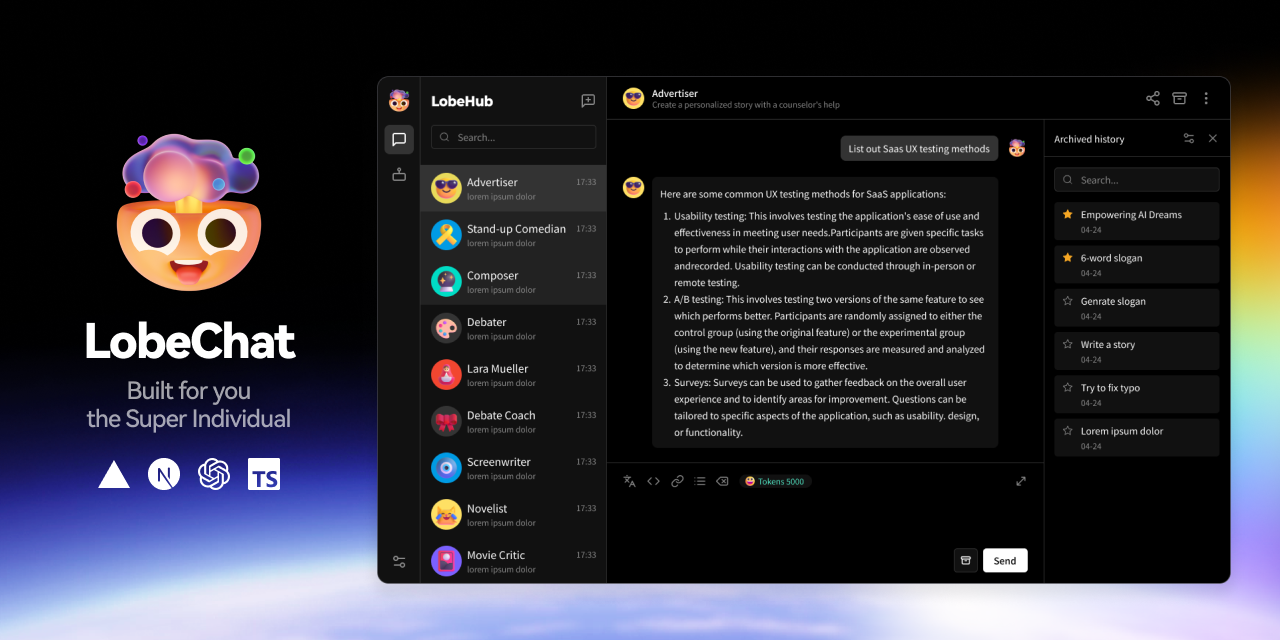

LobeChat:开源 AI 聊天框架,打造你的专属智能助手

如果你想快速搭建一个功能强大、界面现代化的 AI 聊天应用,或者对开源的 ChatGPT 替代品感兴趣,那么 LobeChat(https://github.com/lobehub/lobe-chat)绝对值得一试!这是一个由 LobeHub 团队开发的高性能开源聊天框架,支持多种 AI 模型、插件系统和多模态功能,号称“个人生产力工具,超越 ChatGPT 和 Ollama 的体验”。下面,我们以轻松易懂的风格,带你了解 LobeChat 的功能、技术架构、核心逻辑、技术栈、上手难度,以及它与其他项目的对比,适合有一定编程基础但没接触过这个项目的人。

一、LobeChat 是什么?能干啥?

LobeChat 是一个开源的 AI 聊天框架,目标是让开发者轻松构建现代化的聊天机器人,同时为普通用户提供直观的生产力工具。它不仅支持与主流大语言模型(LLM)交互,还集成了多模态功能(比如语音、图像)和强大的插件系统,可以一键部署私有的 AI 应用。

核心功能

LobeChat 的功能非常丰富,涵盖了现代 AI 应用所需的方方面面:

- 多模型支持:兼容 OpenAI(GPT 系列)、Claude 3、Gemini、Ollama、DeepSeek、Qwen 等多种 AI 模型,切换方便。

- 知识库与 RAG:支持文件上传(文档、图片、音视频等)和知识库管理,通过检索增强生成(RAG)提升回答准确性。

- 多模态交互:支持文本转语音(TTS)、语音转文本(STT)、图像生成(通过插件调用 DALL·E、Stable Diffusion 等)。

- 插件系统:提供函数调用(Function Calling)和丰富的插件市场,比如天气查询、网页爬取、股票分析、YouTube 视频总结等。

- 可视化推理:创新的“思维链”(Chain of Thought, CoT)可视化功能,展示 AI 的推理过程,透明且直观。

- 分支对话:支持像真实对话一样的多方向分支,方便探索不同回答路径。

- 一键部署:支持云端(LobeChat Cloud)或自托管(Docker、Vercel),部署简单,免费私有化。

应用场景

LobeChat 的灵活性让它适用于多种场景:

- 个人生产力:用 AI 整理笔记、生成内容、回答问题,提升效率。

- 开发原型:快速构建聊天机器人原型,集成到 Web 或移动应用。

- 企业解决方案:开发智能客服、知识库助手或内部工具,支持私有化部署。

- 教育与研究:通过 CoT 可视化研究 AI 推理,或用知识库管理学习资料。

- 创意开发:结合插件和多模态功能,打造 AI 驱动的艺术创作、音乐生成或视频分析工具。

一句话总结:LobeChat 是一个“AI 聊天瑞士军刀”,功能全面,适合从个人娱乐到企业开发的各种需求!

二、技术架构:LobeChat 是怎么搭起来的?

LobeChat 的架构设计现代化且模块化,基于 Next.js 和 TypeScript 构建,前后端分离,支持高并发和扩展性。它的核心架构可以概括为:

客户端(浏览器/移动端)

↓

[前端:Next.js + React + Lobe UI]

↓

[后端:Edge Functions + Vercel]

↓

[数据库:Upstash Redis] [向量存储:Qdrant] [模型:OpenAI/Claude/Ollama等] [插件:Gateway]核心组件

- 前端:

- Next.js:提供服务端渲染(SSR)和静态生成(SSG),保证性能和 SEO。

- Lobe UI:LobeHub 自研的 UI 组件库,基于 Ant Design,界面美观且可定制。

- React Hooks:管理状态和交互,比如对话、插件调用、语音功能。

- 后端:

- Edge Functions:部署在 Vercel 上,处理插件调用、API 代理等轻量逻辑。

- Plugins Gateway:独立的插件后端服务,管理函数调用和动态加载。

- 数据存储:

- Upstash Redis:存储会话数据和用户设置,低延迟高可用。

- Qdrant:向量数据库,用于知识库的嵌入(Embeddings)和 RAG。

- AI 模型:通过 API 集成 OpenAI、Claude、Ollama 等,支持本地模型(Ollama)部署。

- 插件系统:基于 JSON 描述文件(manifest.json),动态加载插件,支持前端渲染和后端逻辑。

设计亮点

- 模块化:前端、后端、插件分离,易于扩展和维护。

- 多模态:通过 TTS/STT 和图像处理模块,实现语音和视觉交互。

- 开源生态:依托 LobeHub 的其他项目(如 Lobe TTS、Lobe UI),形成完整工具链。

- 自托管友好:单 Docker 容器即可运行,适合私有化需求。

三、核心模块的实现逻辑

为了让你更直观地了解 LobeChat 的强大,我们拆解几个核心模块的实现逻辑:

1. 多模型交互

LobeChat 通过统一的 API 层调用不同模型。前端代码示例(简化):

typescript

import { ChatModel } from '@lobehub/chat';

const model = new ChatModel({

provider: 'openai',

apiKey: 'your-api-key',

model: 'gpt-4o'

});

const response = await model.generate({

messages: [{ role: 'user', content: 'Hello, how are you?' }]

});

console.log(response.choices[0].message.content);逻辑:

- 前端通过配置选择模型(OpenAI、Claude 等)。

- 请求通过 Edge Functions 转发到模型 API,带上认证信息。

- 后端处理响应,解析 JSON 并返回前端渲染。

2. 知识库与 RAG

知识库支持上传文件并生成向量嵌入,用于 RAG 增强回答。流程如下:

- 用户上传文件(PDF、TXT 等)。

- 文件内容通过嵌入模型(比如 text-embedding-ada-002)转为向量,存储到 Qdrant。

- 用户提问时,系统检索相关向量,注入上下文后调用 LLM 生成回答。

前端代码(伪代码):

typescript

const knowledgeBase = await uploadFile('document.pdf');

const response = await chatWithRAG({

query: 'Summarize the document',

knowledgeBaseId: knowledgeBase.id

});逻辑:Qdrant 提供高效的向量搜索,结合 LLM 的上下文生成能力,提升回答精准度。

3. 插件系统

插件通过 manifest.json 定义功能,比如天气插件:

json

{

"identifier": "weather-plugin",

"title": "Weather Forecast",

"description": "Get real-time weather data",

"api": [

{

"name": "getWeather",

"url": "https://api.weather.com/forecast",

"method": "GET"

}

]

}前端调用插件(伪代码):

typescript

const plugin = await loadPlugin('weather-plugin');

const result = await plugin.call('getWeather', { city: 'Shanghai' });逻辑:

- 插件描述文件动态加载到前端,显示为可交互组件。

- 用户触发插件后,请求通过 Plugins Gateway 转发到外部 API。

- 结果返回前端,支持自定义渲染(比如显示天气卡片)。

4. 思维链(CoT)可视化

CoT 功能将 AI 的推理过程分解为步骤,展示为流程图。实现逻辑:

- LLM 在生成回答时,输出中间推理步骤(通过特殊 Prompt 控制)。

- 前端解析步骤,渲染为 React 组件(如树状图)。

- 用户可交互查看每一步的逻辑。

四、使用的技术栈

LobeChat 的技术栈现代化,适合前后端开发者:

- 前端:

- Next.js:服务端渲染和路由。

- React/TypeScript:组件化和类型安全。

- Lobe UI/Ant Design:UI 组件,兼容暗色/亮色主题。

- Redux:状态管理(对话、设置等)。

- 后端:

- Node.js:Edge Functions 的运行时。

- Vercel:部署平台,支持 Serverless。

- Plugins Gateway:独立的插件服务,基于 TypeScript。

- 数据存储:

- Upstash Redis:会话和缓存。

- Qdrant:向量存储,知识库支持。

- AI 集成:

- OpenAI/Claude/Gemini SDK:模型调用。

- Ollama:本地模型支持。

- 其他:

- Docker:自托管部署。

- WebSocket:实时对话。

- TTS/STT:语音功能(基于 Lobe TTS 库)。

对用户来说,前端开发只需懂 React 和 API 调用,自托管需要基础的 Docker 知识。

五、上手难度:新手友好吗?

学习曲线

LobeChat 对不同背景的用户友好程度不一:

- 普通用户:直接用 LobeChat Cloud 或预部署实例,零编程基础也能上手,界面直观,10 分钟学会聊天和插件使用。

- 前端开发者:用 Next.js 修改界面或开发插件,需要熟悉 React 和 TypeScript,1-2 天能上手。

- 全栈开发者:自托管或开发复杂插件,需要懂 Docker、Node.js 和 API 集成,3-5 天可深入。

- AI 专家:定制 RAG 或 CoT 逻辑,可能需要了解向量数据库和 Prompt 工程,1-2 周完全掌握。

搭建步骤

以自托管为例,部署 LobeChat 很简单:

- 安装 Docker。

- 运行命令:

bash

docker run -d -p 3210:3210 lobehub/lobe-chat - 访问

http://localhost:3210,配置模型 API 密钥(比如 OpenAI)。

云端更简单,注册 LobeChat Cloud(https://lobechat.com),免费试用 50 万积分。

开发环境搭建:

- 克隆仓库:

bash

git clone https://github.com/lobehub/lobe-chat.git cd lobe-chat - 安装依赖:

bash

yarn install - 启动开发服务器:

bash

yarn dev - 访问

http://localhost:3010。

文档和社区

- 文档:LobeChat 官方文档(https://lobehub.com/docs)内容丰富,涵盖使用、开发和插件指南。

- 社区:活跃的 Discord(https://discord.gg/lobehub)和 GitHub Discussions,58.7k+ Star 证明其热度。

- X 反馈:用户称赞其“UI 优雅”“插件生态强大”,是开发 AI 应用的绝佳选择。

总结:对用户来说,LobeChat 几乎零门槛;对开发者来说,前端开发简单,自托管和插件开发稍有挑战,但文档和社区支持降低难度。

六、与其他项目的对比

为了更清晰地了解 LobeChat 的定位,我们对比几个类似项目:

1. LobeChat vs Supabase

- 定位不同:

- Supabase:后端即服务(BaaS),提供数据库、认证、存储,适合为 AI 应用提供后端支持。

- LobeChat:AI 聊天框架,聚焦前端交互和模型集成。

- 互补性:可以用 Supabase 存储 LobeChat 的知识库数据或用户会话。

- 选择建议:需要后端基础设施选 Supabase;想快速开发 AI 聊天界面选 LobeChat。

2. LobeChat vs n8n

- 定位不同:

- n8n:工作流自动化工具,适合连接 AI API 和其他服务。

- LobeChat:专注于聊天界面和多模态交互。

- 功能:n8n 适合自动化任务(比如定时调用 AI);LobeChat 提供完整的用户交互体验。

- 选择建议:需要自动化流程选 n8n;需要现代化的 AI 聊天 UI 选 LobeChat,两者可结合使用。

3. LobeChat vs Microsoft Generative AI for Beginners

- 定位不同:

- Generative AI for Beginners:教育课程,教生成式 AI 开发。

- LobeChat:现成的 AI 聊天框架,直接用于生产。

- 功能:课程教你如何从头开发;LobeChat 提供开箱即用的解决方案。

- 选择建议:想学习 AI 开发选课程;想快速部署 AI 应用选 LobeChat。

4. LobeChat vs ChatGPT/Ollama

- 相似点:都支持 AI 对话。

- 不同点:

- ChatGPT:闭源 SaaS,功能强大但定制性有限,需订阅。

- Ollama:本地模型运行工具,专注于模型推理,需自行搭建 UI。

- LobeChat:开源框架,集成多种模型,提供现代化 UI 和插件。

- 选择建议:预算有限或需定制化选 LobeChat;追求极致简单选 ChatGPT;想完全本地化选 Ollama(可搭配 LobeChat)。

七、总结:为什么选择 LobeChat?

LobeChat 的最大优势在于现代化设计+强大生态。它结合了优雅的 UI、丰富的功能(多模型、插件、RAG)和开源的灵活性,适合从个人开发者到企业团队的各种需求。无论是快速搭建一个 AI 助手,还是深度定制聊天应用,LobeChat 都能提供高效的解决方案。加上活跃的社区和持续更新的功能(最近的 v1.79.7 修复了 Grok-3 调用问题),它在开源 AI 领域的前景非常光明。

快速上手建议

- 访问 LobeChat 官网(https://lobechat.com)或 GitHub 仓库,试试云端版本。

- 用 Docker 跑一个本地实例,体验多模型切换和插件功能。

- 看看官方文档(https://lobehub.com/docs)或加入 Discord 社区,学习插件开发。

- 尝试 CoT 可视化,感受 AI 推理的透明魅力!

LobeChat 目前有 58.7k+ Star,在 X 上被誉为“开源 AI 聊天框架的标杆”。 不妨去点个 Star,或者直接上手试试,相信你会爱上这个“智能生产力助手”!

(完)

参考资料:

- LobeChat 官方文档:https://lobehub.com/docs

- GitHub 仓库:https://github.com/lobehub/lobe-chat

- 社区反馈:LobeHub Discord 和 X 上的用户评价

如果想深入某个功能(比如插件开发或 RAG),或者有其他问题,随时告诉我!