AutoGen:用AI代理团队轻松搞定复杂任务的开源框架

想让AI帮你写代码、分析数据,甚至自动化整个工作流程?GitHub上的开源项目 AutoGen(https://github.com/microsoft/autogen)可能是你的最佳拍档!由微软研究院推出,AutoGen 是一个专注于多代理协作的编程框架,让AI代理像团队一样“聊天”解决问题,简单又强大。今天我们来聊聊 AutoGen 的功能、技术细节和上手体验,用轻松的方式带你了解如何用它打造智能工作流!

一、AutoGen 能干啥?功能与应用场景

AutoGen 的核心理念是:通过多个AI代理的协作,自动化完成复杂任务。它提供了一个灵活的框架,让开发者可以快速构建单代理或多代理系统,支持AI与AI、AI与人之间的无缝交互。主要功能包括:

- 多代理协作:多个AI代理可以像团队一样分工合作,比如一个写代码、一个检查错误、一个与用户沟通。

- 可定制代理:支持自定义代理角色(如助手、代码执行者),并集成大语言模型(LLM)、工具和人类输入。

- 代码执行:内置安全代码执行环境(支持Docker),能自动运行生成代码,适合编程任务。

- WebUI支持:AutoGen Studio 提供低代码界面,零编程基础也能快速搭建代理工作流。

- 跨语言与分布式:支持Python和.NET,代理可分布式部署,适合大规模场景。

- 高可观察性:内置跟踪和调试工具,支持OpenTelemetry,方便监控代理行为。

应用场景

- 自动化编程:让AI代理帮你写代码、调试、优化,比如生成数据可视化图表或爬虫脚本。

- 业务流程优化:模拟企业场景(如员工入职),由多个代理协作完成HR、技术支持等任务。

- 教育与研究:研究多代理协作机制,或用作AI教学工具,探索LLM的潜力。

- 内容生成:代理团队可以分工创作文章、设计广告,甚至开发简单的游戏。

- 交互式工具:构建智能客服、虚拟助手,或基于用户反馈动态调整的AI系统。

AutoGen 就像一个“AI团队经理”,帮你协调多个“AI员工”,既能独立干活,也能随时听你的指挥。

二、技术架构:AutoGen 的实现?

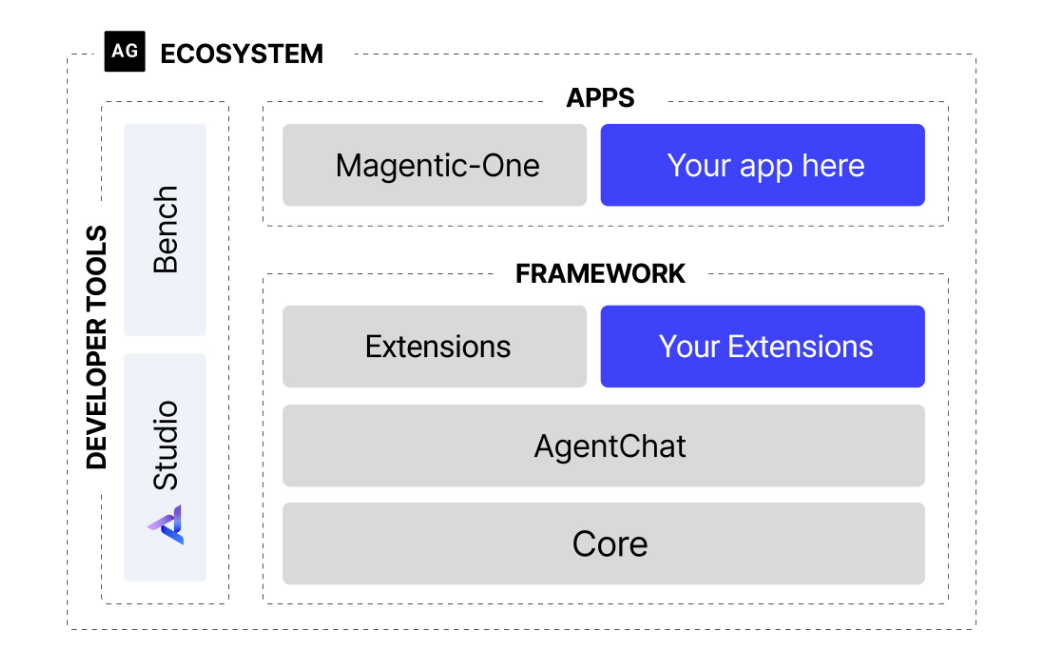

AutoGen 采用分层架构设计,分为核心层(Core API)、代理聊天层(AgentChat API)和扩展层(Extensions API),让开发者可以根据需求选择不同抽象级别。它的技术架构包括:

- 核心层(autogen-core):基于Actor模型,实现异步消息传递和事件驱动的代理交互,支持点对点消息(类似RPC)和发布-订阅模式(Pub-Sub)。

- 代理聊天层(autogen-agentchat):提供高层次API,简化多代理对话模式(如双人聊天、群聊),适合快速原型开发。

- 扩展层(autogen-ext):集成外部服务,如OpenAI、Azure代码执行器、LangChain工具等,支持社区扩展。

- 模型客户端:支持多种LLM(如GPT-4、Gemini、Llama),通过统一接口调用云端或本地模型。

- 运行时环境:支持本地、分布式和跨语言运行,代理可部署在不同设备或云端。

- WebUI(AutoGen Studio):基于Gradio或SQLModel,提供图形化配置和调试界面。

整体流程是:定义代理角色和任务 → 配置模型和工具 → 启动聊天或工作流 → 监控和调试结果。架构模块化,扩展性强,适合从简单脚本到复杂系统的各种场景。

三、核心模块的实现逻辑

为了更直观,我们拆解 AutoGen 的几个核心模块:

-

代理定义(Agent Definition)

- 逻辑:每个代理是一个独立单元,可配置LLM、工具和交互模式(如自动回复或等待人类输入)。

- 实现:通过

AssistantAgent(AI助手)和UserProxyAgent(用户代表)类实现,配置参数包括模型、系统提示(System Message)和工具集。 - 关键点:支持动态调整代理行为,比如设置最大回复轮次或终止条件(如用户输入“exit”)。

-

消息传递(Message Passing)

- 逻辑:代理通过异步消息(如文本、代码、工具调用)交流,消息格式支持类型化(Typed Messages)。

- 实现:核心层用

autogen-core的消息总线(Message Bus)实现,AgentChat层封装为简单的initiate_chat方法。 - 关键点:异步设计降低延迟,支持分布式代理间的跨语言通信(Python ↔ .NET)。

-

代码执行(Code Execution)

- 逻辑:代理生成代码后,交由安全环境(如Docker)运行,返回执行结果。

- 实现:通过

DockerCommandLineCodeExecutor,代码在隔离容器中运行,防止安全风险。用户可按需确认执行。 - 关键点:支持自定义执行环境,适合处理敏感任务,社区也在优化云端沙箱支持。

-

团队协作(Team Collaboration)

- 逻辑:多代理组成团队(如

RoundRobinGroupChat或SelectorGroupChat),按策略轮流发言或动态选择发言者。 - 实现:AgentChat层提供

GroupChatManager协调对话,核心层支持自定义协作模式。 - 关键点:支持弱模型(如Llama 13B)优化,动态调整对话策略,提升协作效率。

- 逻辑:多代理组成团队(如

-

WebUI(AutoGen Studio)

- 逻辑:提供图形化界面,封装代理配置、任务定义和结果展示,降低编程门槛。

- 实现:基于SQLModel(Pydantic + SQLAlchemy)管理后端数据,前端用Gatsby和Yarn构建,运行时通过

autogenstudio ui启动。 - 关键点:支持导出JSON配置,方便在代码中复用,但目前为原型,非生产级。

四、用到的技术栈

AutoGen 的技术栈现代化且模块化,核心依赖如下:

- 编程语言:Python 3.10+(主语言),.NET(跨语言支持)

- 核心框架:

autogen-core:异步消息和Actor模型autogen-agentchat:多代理对话APIautogen-ext:扩展模块(如OpenAI、Gemini客户端)

- 模型支持:

- OpenAI(GPT-4、4o)、Gemini、Llama(通过Ollama)

- Azure OpenAI、Hugging Face模型

- 工具与执行:

docker:代码执行隔离langchain:工具适配(可选)playwright:Web浏览(如MultimodalWebSurfer)

- 前端与UI:

- Gradio:AutoGen Studio的WebUI

- Gatsby、Yarn:前端构建

- SQLModel:后端数据管理

- 其他依赖:

openai:LLM API调用pydantic:数据验证open-telemetry: observabilityfastapi:API集成(示例)

代码结构清晰,python/ 目录包含核心实现,samples/ 提供丰富示例,dotnet/ 支持跨语言开发。

五、上手难度:小白能玩转吗?

AutoGen 的上手难度属于低到中等,对Python开发者友好,AutoGen Studio 让零基础用户也能快速入门。以下是详细分析:

安装步骤

- 环境准备:安装Python 3.10+和Git,确保有API密钥(如OpenAI)。

- 安装核心包:运行

pip install -U autogen-agentchat autogen-ext[openai]。 - 安装Studio(可选):运行

pip install -U autogenstudio,启动WebUI(autogenstudio ui --port 8081)。 - 运行示例:复制官方示例代码,设置API密钥,运行简单对话或任务。

- Docker配置(可选):安装Docker Desktop,用于安全代码执行。

可能遇到的坑

- API依赖:需要OpenAI或其他LLM的API密钥,国内用户可能需科学上网。

- 硬件要求:简单任务可在CPU运行,复杂工作流推荐GPU或云端(4GB显存起步)。

- Docker配置:Windows/macOS用户需确保Docker正常运行,Linux可能需调整权限。

- 版本迁移:从v0.2升级到v0.4需参考迁移指南(官方文档),API变化较大。

- Studio限制:WebUI为原型,复杂工作流仍需代码实现。

好消息

- WebUI友好:AutoGen Studio让配置代理像填表单,1小时内可跑通demo。

- 文档丰富:官方提供详细教程(microsoft.github.io/autogen)、示例和视频,社区(Discord、GitHub Discussions)活跃。

- 低门槛示例:官方样本覆盖从简单聊天到复杂群聊,复制粘贴即可运行。

- 硬件灵活:支持Ollama运行本地模型,降低云端依赖。

总结:有Python基础的用户,半天内能跑通简单代理任务。零基础用户用AutoGen Studio也能快速上手,但深入定制需要学习LLM和多代理概念。

六、和其他项目的对比

AutoGen 专注于多代理协作,我们对比几个类似项目,看看它的独特之处:

-

LangChain

- 优点:工具集成丰富,适合构建复杂RAG(检索增强生成)系统。

- 缺点:多代理支持较弱,协作逻辑需手动实现。

- 对比:AutoGen 更专注代理间“对话”,内置群聊和代码执行,协作效率更高。

-

LLaMA-Factory(https://github.com/hiyouga/LLaMA-Factory)

- 优点:微调100+模型,WebUI简单,显存优化好。

- 缺点:仅限模型训练,无多代理协作。

- 对比:AutoGen 侧重任务执行和代理协作,适合动态工作流,而非模型开发。

-

CrewAI

- 优点:多代理框架,任务分配直观,适合业务场景。

- 缺点:扩展性较弱,社区规模小,文档不如AutoGen完善。

- 对比:AutoGen 的跨语言支持和可观察性更强,适合研究和生产环境。

-

Semantic Kernel(微软)

-

Commercial Tools(如OpenAI Assistants API)

- 优点:开箱即用,集成简单,效果稳定。

- 缺点:不开源,定制受限,成本高。

- 对比:AutoGen 开源免费,灵活性高,支持本地模型,适合预算有限的开发者。

AutoGen 在多代理协作、开源灵活性和低代码体验上表现突出,尤其适合想快速原型或研究代理协作的开发者。