轻松玩转 Dify:从零打造你的 AI 应用利器

如果你是一个对 AI 开发感兴趣的程序员,或者正在寻找一个能快速上手、构建强大 AI 应用的开源工具,那么今天我要给你安利一个宝藏项目——Dify。这个项目简直是 AI 开发者的“瑞士军刀”,不仅功能丰富,还能让你从原型到生产级应用无缝切换。接下来,我将带你从功能、技术栈到上手难度,全方位解锁 Dify 的魅力,文章风格轻松接地气,保证你看完就想撸起袖子试一把!

一、Dify 是什么?能干啥?

Dify 是一个开源的 大语言模型(LLM)应用开发平台,它的定位是让开发者(甚至是非技术人员)都能快速构建基于 AI 的应用。简单来说,它就像一个“AI 应用工厂”,提供了一站式的开发工具链,让你从设计 AI 工作流到上线应用,都能轻松搞定。

功能亮点

Dify 的功能可以用“全面”和“实用”来形容,以下是几个核心亮点:

- AI 工作流编排:通过一个可视化的画布,你可以像搭积木一样设计 AI 的处理流程,比如对话、数据分析、自动化任务等。

- RAG 管道:支持检索增强生成(Retrieval-Augmented Generation),能从海量文档中提取信息,特别适合知识库问答、客服机器人等场景。

- 智能代理:可以定义基于大模型的智能代理,支持复杂任务分解,比如自动调用工具、联网搜索等。

- 模型管理:无缝对接数百种大模型,包括 GPT、Mistral、Llama3,以及任何兼容 OpenAI API 的模型,模型切换就像换皮肤一样简单。

- Prompt 调试:内置 Prompt IDE,帮你优化提示词,还能对比不同模型的表现,省去手动调参的痛苦。

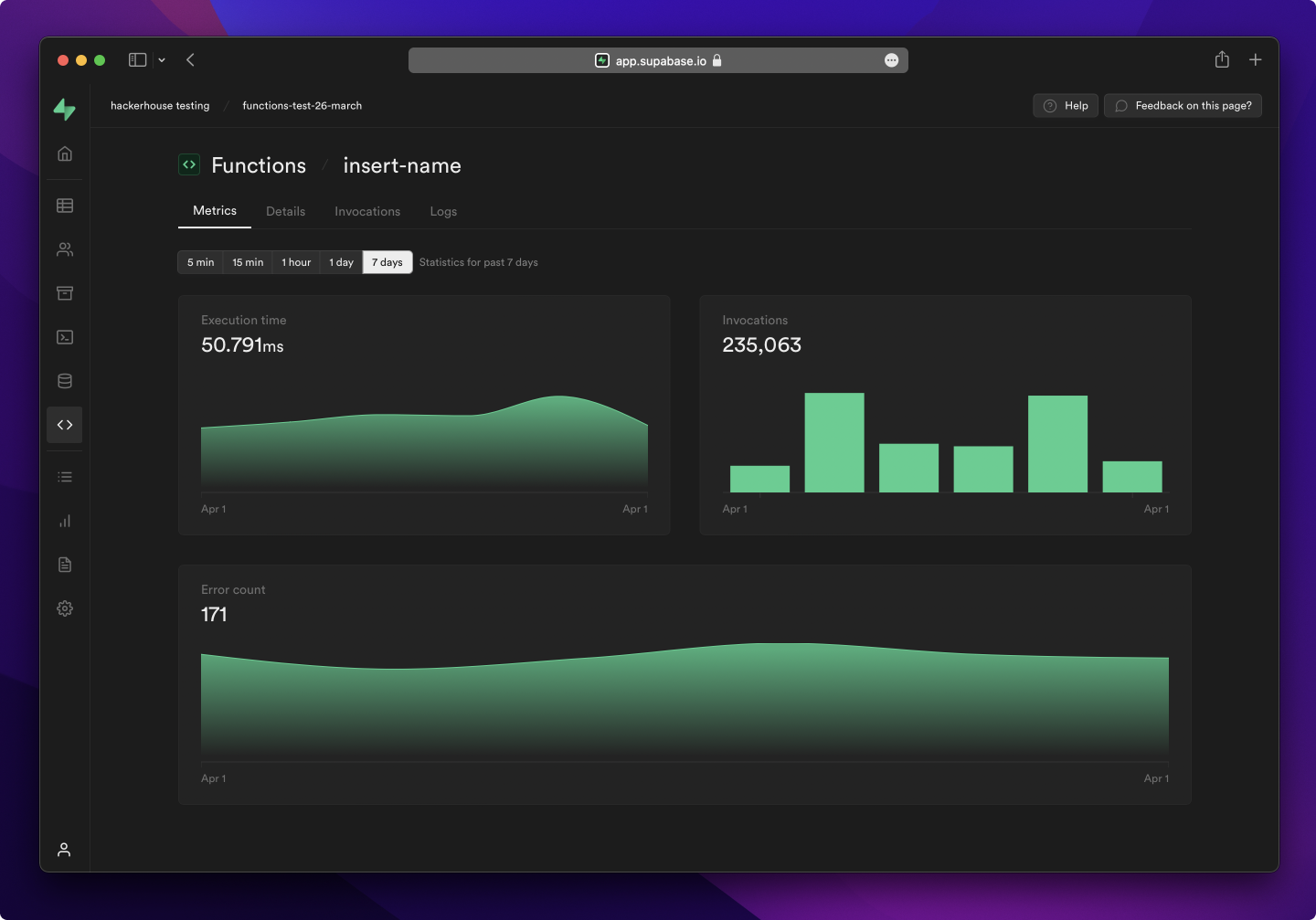

- LLMOps:提供日志监控、性能分析等功能,让你的 AI 应用运行得稳稳当当。

应用场景

Dify 的应用场景非常广泛,堪称“万金油”。比如:

- 智能客服:基于 RAG 构建企业知识库,回答客户问题又快又准。

- 内容生成:从文章写作到代码生成,Dify 能帮你批量生产高质量内容。

- 数据分析助手:结合大模型和外部工具,自动分析报表或挖掘数据洞察。

- 个人助理:打造一个专属的 AI 小助手,帮你处理日程、搜索信息,甚至生成创意点子。

一句话总结:无论你是想做商业级 AI 应用,还是个人小工具,Dify 都能给你一个快速上手的起点。

二、技术架构:Dify 怎么搭起来的?

Dify 的架构设计可以用“模块化”和“高扩展性”来形容。它的整体架构分为前端、后端和基础设施三大部分,层层解耦,方便开发者定制和扩展。

1. 总体架构

- 前端:基于 React 和 Next.js 构建,提供了直观的 Web 界面,包括工作流画布、Prompt 编辑器等。

- 后端:使用 Flask(Python)作为核心框架,负责 API 服务、模型调用、任务调度等。

- 数据库:默认使用 PostgreSQL 存储元数据,Redis 做缓存,Weaviate 或 Qdrant 作为向量数据库支持 RAG。

- 基础设施:通过 Docker Compose 一键部署,内置 Nginx 做反向代理,SSRF 代理防止安全攻击。

2. 核心模块实现逻辑

Dify 的几个核心模块设计得非常巧妙,以下是它们的实现逻辑简析:

- 工作流引擎:通过可视化画布定义节点(比如 LLM 调用、条件判断、工具调用),每个节点是一个独立的任务单元。后端用 DAG(有向无环图)管理节点依赖,动态调度任务执行。

- RAG 管道:分为数据摄取、向量化、检索三个阶段。支持从 PDF、PPT 等文档中提取文本,结合向量数据库(如 Weaviate)存储 embeddings,检索时通过语义匹配返回最相关的内容。

- 代理系统:基于 LLM 的 Function Calling 或 ReAct 框架,代理可以自主选择工具(比如 Google Search、DALL·E)并执行多步推理。工具调用通过插件系统实现,扩展性极强。

- 模型管理:通过统一的 API 层对接不同模型提供商(如 OpenAI、Hugging Face),支持动态切换和负载均衡。Prompt IDE 则通过实时对比模型输出,帮助优化提示词。

这种模块化设计让 Dify 既灵活又高效,开发者可以根据需求替换或扩展任意模块。

三、用到的技术栈:现代且接地气

Dify 的技术栈非常现代化,既有主流框架,也有专门为 AI 开发优化的工具。以下是主要技术栈一览:

- 前端:React, Next.js, Storybook(UI 组件开发), Jest(单元测试)

- 后端:Python, Flask, Celery(异步任务),Gevent(高并发)

- 数据库:PostgreSQL, Redis, Weaviate/Qdrant(向量数据库)

- 部署:Docker, Docker Compose, Kubernetes(可选高可用部署)

- 其他:Nginx(反向代理),Squid(SSRF 防护),Langfuse(LLM 调试)

这些技术栈对有一定开发经验的程序员来说并不陌生,尤其是 Python 和 Docker 的使用,降低了学习曲线。

四、上手难度:新手友好,老手高效

1. 安装与部署

Dify 的部署非常简单,官方推荐使用 Docker Compose,只需几步:

bash

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

docker compose up -d然后访问 http://localhost/install,跟着向导初始化即可。整个过程不到 10 分钟,前提是你的机器满足最低要求(2 核 CPU,4GB 内存)。

如果想本地开发,稍微复杂一点,需要配置前端和后端的开发环境,但官方文档详细,跟着走问题不大。

2. 开发与定制

对于新手,Dify 的可视化界面几乎是“零代码”的体验,你只需要拖拽节点、填写 Prompt 就能构建一个简单的 AI 应用。对于有经验的开发者,可以通过插件系统开发自定义工具,或者直接修改源码实现高级功能。

上手难度总结:

- 新手:⭐⭐(2/5),会用 Docker 和基础 Linux 命令即可。

- 有经验开发者:⭐⭐⭐(3/5),需要熟悉 Python 和前端开发,但模块化设计让定制很方便。

五、与其他项目的对比:Dify 有何不同?

Dify 经常被拿来和 LangChain、Flowise 等项目比较,下面是几点对比:

- vs LangChain:

- 相同点:都支持大模型集成和复杂工作流。

- 不同点:LangChain 更像一个工具库,偏向代码驱动,适合深度定制;Dify 是开箱即用的平台,提供可视化界面和生产级功能,省去了很多基础设施搭建 Dify 更适合快速原型开发和非技术用户。

- vs Flowise:

- 相同点:都有可视化工作流设计。

- 不同点:Flowise 更轻量,专注于简单任务;Dify 功能更全面,支持 RAG、LLMOps 等高级特性,适合企业级应用。

- vs Assistants API(OpenAI):

- 相同点:都能快速构建 AI 助手。

- 不同点:OpenAI 的方案更封闭,模型选择有限;Dify 开源且支持多模型,数据完全自控,适合隐私敏感场景。

一句话总结:Dify 在易用性和功能深度之间找到了平衡,既适合快速上手,也能满足复杂需求。

六、总结:为什么选择 Dify?

看完这些,你是不是已经有点心动了?Dify 不仅是一个功能强大的 AI 开发平台,更是一个活跃的开源社区(GitHub 上 90k+ 星!)。它的可视化设计让新手能快速上手,模块化架构又满足了老司机的定制需求。不管你是想做个智能客服、内容生成器,还是探索 AI 应用的无限可能,Dify 都能帮你事半功倍。

建议行动:

- 花 10 分钟部署一个 Dify 实例,试试官方示例工作流。

- 加入 Dify 的 Discord 社区,和全球开发者交流经验。

- 如果你有想法,不妨开发一个插件,分享到 Dify Marketplace,秀一把你的技术!

最后,欢迎在评论区分享你的 Dify 体验,或者告诉我你想用它做什么好玩的应用!让我们一起用 Dify 打造属于自己的 AI 魔法吧!✨

(参考资料:Dify 官方 GitHub 仓库、Dify 文档)