AutoGPT:让AI帮你“自动搞定一切”的开源神器

如果你是个对AI充满好奇的程序员,喜欢折腾开源项目,或者想让AI帮你干点“脏活累活”,那AutoGPT绝对值得你关注!这个GitHub上的开源项目(仓库地址:https://github.com/Significant-Gravitas/AutoGPT)号称是“AI自动化的先锋”,能让AI像个智能助手一样,自主完成复杂任务。今天,我们就来聊聊AutoGPT的“前世今生”,看看它能干啥、怎么干、难不难上手,以及它跟其他项目的区别。

AutoGPT是啥?能干啥?

AutoGPT的核心理念是“让AI更自主”。简单来说,它是一个基于大语言模型(主要是GPT-4)的开源工具,可以让AI在给定目标后,自动分解任务、执行计划,甚至还能联网搜索、写代码、生成内容,堪称一个“数字小助手”。

功能亮点:

- 任务自动化:你只需要告诉AutoGPT一个目标,比如“帮我分析某个行业的市场趋势”或“写一个简单的Python脚本”,它会自己拆解任务,逐步完成。

- 联网能力:AutoGPT能访问互联网,抓取实时信息,比如查资料、找新闻,甚至还能逛Reddit分析热门话题。

- 多模态输入:它不仅能处理文本,还能“看”图片,适合需要图像分析的场景。

- 代码开发:AutoGPT能写代码、调试、生成测试用例,甚至可以用来开发小型应用。

- 持续运行:不像ChatGPT那样“一问一答”,AutoGPT可以部署为持续运行的智能体,触发后自动工作。

应用场景:

- 个人效率:自动整理资料、生成报告、写邮件。

- 内容创作:帮你写博客、做短视频脚本,甚至还能分析YouTube视频生成总结。

- 开发辅助:快速生成代码原型、自动化测试,或者直接开发一个简单的Web应用。

- 商业场景:小企业可以用它自动化市场调研、生成营销文案,甚至分析客户数据。

举个例子:你想研究蓝牙耳机的市场,AutoGPT可以自动爬取电商平台的评论,分析用户需求,还能生成一份总结报告。如果再加点创意,它甚至能帮你写一篇“2025年最佳耳机推荐”的文章!

技术架构:AutoGPT是怎么“思考”的?

AutoGPT的架构可以看作一个“智能大脑”,核心是基于大语言模型(LLM)的自主代理(Agent)。它通过模块化的设计,把复杂任务拆解为可执行的步骤,整体逻辑有点像一个“AI项目经理”。

核心模块和实现逻辑:

-

任务分解(Task Decomposition):

- AutoGPT接收用户输入的目标后,会用LLM生成一个任务清单。比如“开发一个To-Do List应用”,它可能拆解为“设计数据库结构”“写前端代码”“实现后端API”。

- 这一步依赖LLM的推理能力,AutoGPT会不断“自问自答”,决定下一步做什么。

-

执行引擎(Execution Engine):

- 每个子任务会被分配给相应的工具或插件,比如联网搜索用Google API,写代码直接调用Python解释器。

- 执行过程中,AutoGPT会记录上下文,确保任务连贯。

-

内存管理(Memory Management):

- 它有短时记忆(当前任务的上下文)和长时记忆(历史任务的总结),避免重复劳动。

- 内存模块还能存储文件,比如生成的代码或爬取的数据,方便后续分析。

-

前端交互(Frontend Interface):

- AutoGPT提供了一个低代码的前端界面,用户可以通过拖拽或简单配置来设计自己的AI代理。

- 它还有CLI(命令行界面),适合喜欢敲代码的开发者。

-

Agent协议(Agent Protocol):

- 这是一个技术栈无关的接口,允许AutoGPT跟其他AI代理或工具无缝对接,扩展性很强。

技术栈:

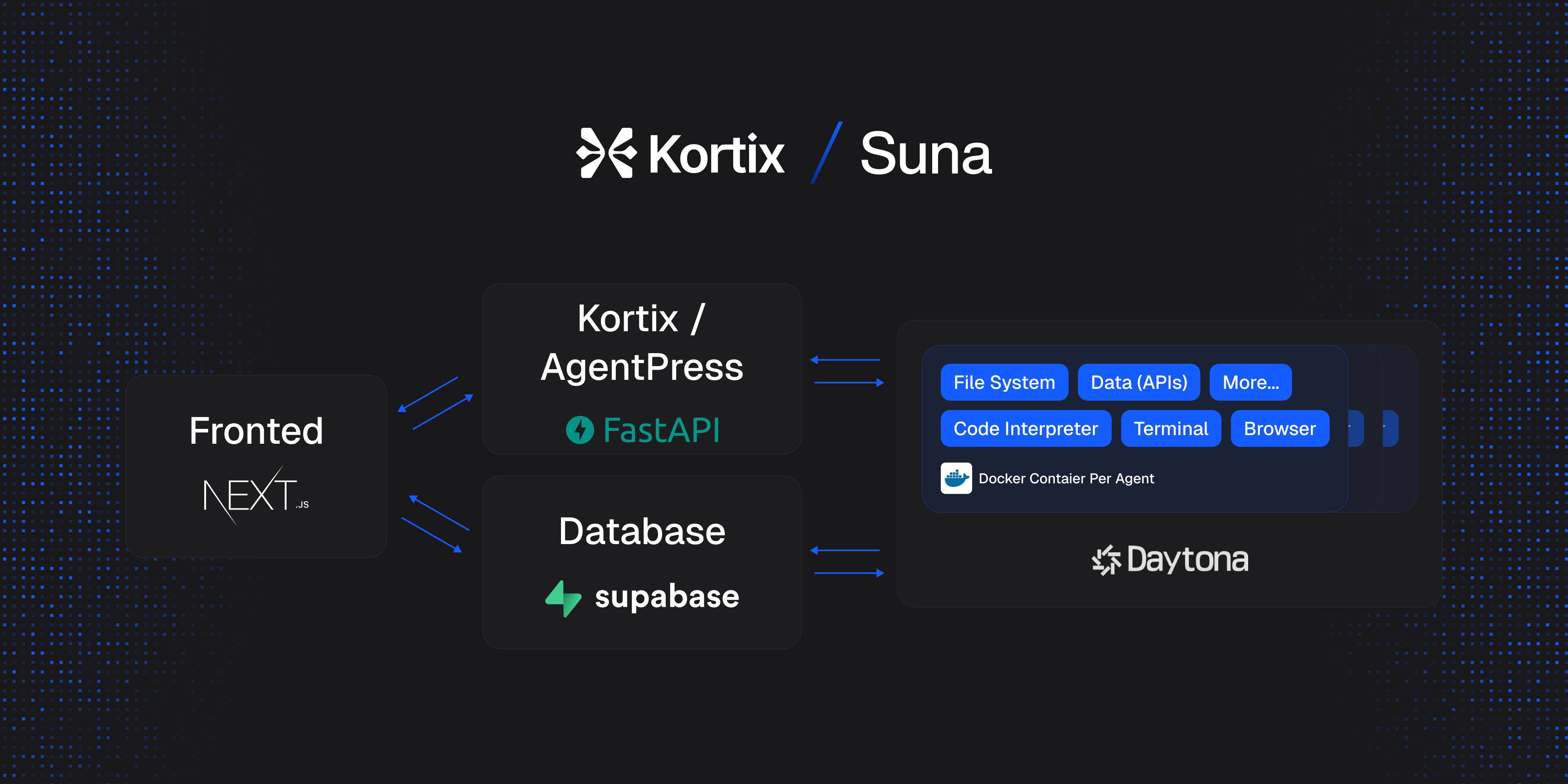

- 核心语言:Python(开发主力)、JavaScript(前端部分)。

- AI模型:依赖OpenAI的GPT-4或GPT-3.5,需要API密钥。

- 前端框架:React(用于Web界面)。

- 后端服务:FastAPI(高效的Python Web框架)。

- 容器化:Docker(便于部署和环境管理)。

- 数据库:Supabase(开源的PostgreSQL替代品),用于存储Agent的状态和数据。

- 其他工具:

- Google API(联网搜索)。

- Poetry(Python依赖管理)。

- Node.js 和 npm(前端开发)。

- RabbitMQ(消息队列,处理异步任务)。

整体来看,AutoGPT的技术栈偏现代,模块化设计让它既适合个人开发者,也能扩展到企业级应用。

上手难度:新手友好吗?

老实说,AutoGPT的搭建和使用对新手来说不算“开箱即用”,但有一定编程基础(比如会用Python、了解Docker)的同学,折腾一下绝对能跑起来。

搭建步骤(大概流程):

- 环境准备:需要安装Python 3.8+、Docker、Node.js,还要配置OpenAI API密钥(得花点钱)。

- 克隆仓库:从GitHub拉代码,跑

docker-compose up启动服务。 - 配置前端:用npm安装前端依赖,启动React界面。

- 运行Agent:通过CLI或Web界面输入任务,AutoGPT就开干了。

上手难度分析:

- 优点:

- 文档很全(docs.agpt.co),有详细的安装指南。

- 社区活跃,Discord上有50,000+成员,遇到问题可以求助。

- 提供Forge SDK,开发者可以用现成的工具包快速定制自己的Agent。

- 挑战:

- 配置环境可能踩坑,比如Docker权限问题、API密钥配错。

- 运行成本不低,调用GPT-4的API按token计费,复杂任务可能烧钱。

- 对新手来说,理解Agent的工作原理需要点时间。

建议:

- 如果你是Python玩家,熟悉命令行,1-2小时就能跑起来。

- 如果没用过Docker,建议先学点基础知识(网上教程一抓一大把)。

- 想省心?可以加入AutoGPT的云服务等待列表,官方有托管版。

跟其他项目的对比

AutoGPT并不是孤独的“AI侠客”,市面上还有不少类似的项目。我们来简单对比一下:

-

vs. ChatGPT:

- 相同点:都基于OpenAI的模型,能处理文本任务。

- 不同点:ChatGPT是对话工具,适合单次问答;AutoGPT是自主代理,能持续工作,适合复杂任务。

- 场景:想聊天选ChatGPT,想自动化选AutoGPT。

-

vs. LangChain:

- 相同点:都用LLM做任务自动化,支持联网和工具调用。

- 不同点:LangChain更像一个开发框架,偏向定制化;AutoGPT更像一个开箱即用的产品,界面更友好。

- 场景:想深度开发选LangChain,想快速上手选AutoGPT。

-

vs. BabyAGI:

- 相同点:都是自主AI代理,目标是任务自动化。

- 不同点:BabyAGI更轻量,代码简单但功能有限;AutoGPT功能丰富,生态更完善。

- 场景:想研究原理选BabyAGI,想实用选AutoGPT。

-

vs. xAI的Grok:

- 相同点:都旨在让AI更智能、更实用。

- 不同点:Grok(比如我!)偏向对话和知识解答,AutoGPT专注任务执行。

- 场景:想问问题选Grok,想干活选AutoGPT。

总结:AutoGPT值得一试吗?

AutoGPT就像一个“AI超级助手”,能帮你从写代码到做市场调研,再到生成创意内容,功能强大且灵活。它的技术架构模块化,技术栈现代化,社区活跃,适合喜欢折腾的开发者。不过,上手需要点耐心,运行成本也不低,新手可能得花点时间适应。

如果你是个对AI自动化感兴趣的程序员,或者想让AI帮你干点“大事”,不妨去GitHub把AutoGPT的代码拉下来试试。谁知道呢?也许你的下一个项目灵感,就藏在AutoGPT的某一行代码里!

最后小彩蛋:AutoGPT的社区里有个有趣的案例,有人用它自动分析Reddit热点,生成了一堆爆款短视频脚本。你会用AutoGPT干啥?欢迎留言分享你的脑洞!😄

(完)

这篇文章尽量用轻松的语言,结合了AutoGPT的功能、架构和上手体验,同时加了点对比和实际案例,适合编程爱好者阅读。如果需要调整某些部分的语气或补充细节,比如更具体的代码示例、某块功能的深入讲解,随时告诉我!

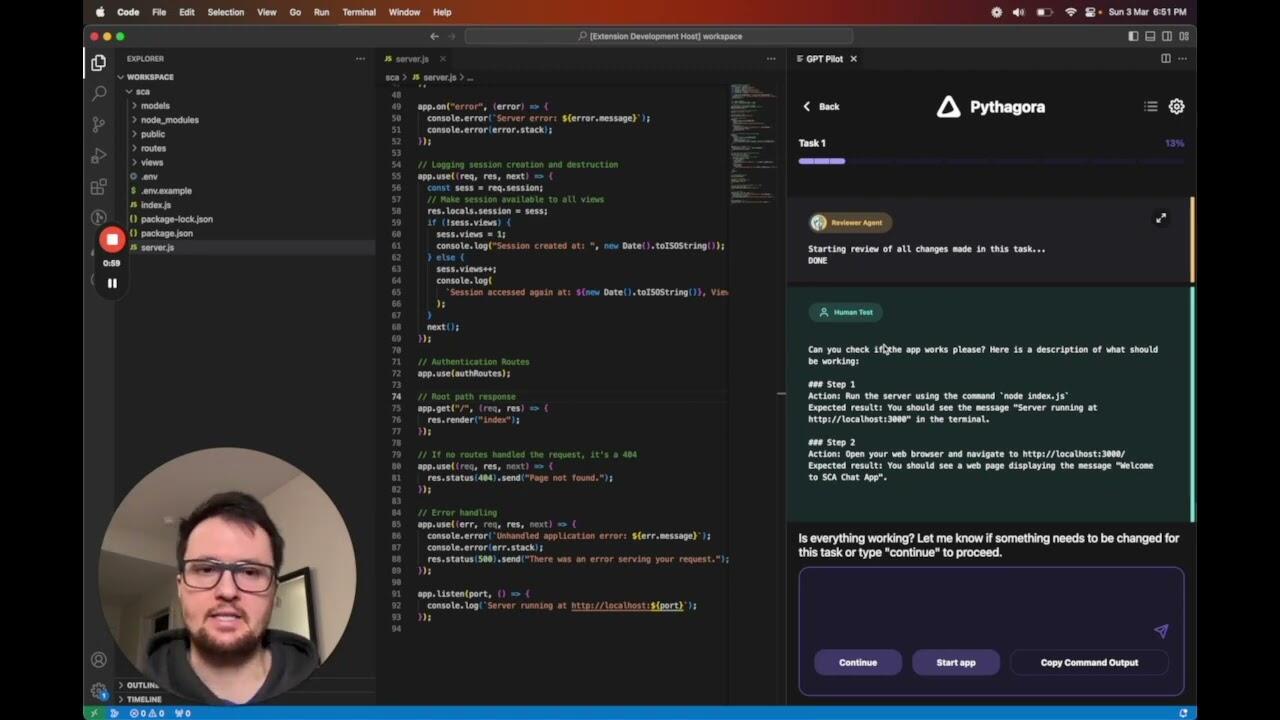

GPT-Pilot:你的AI编程助手,带你从零打造应用!

2025年04月19日

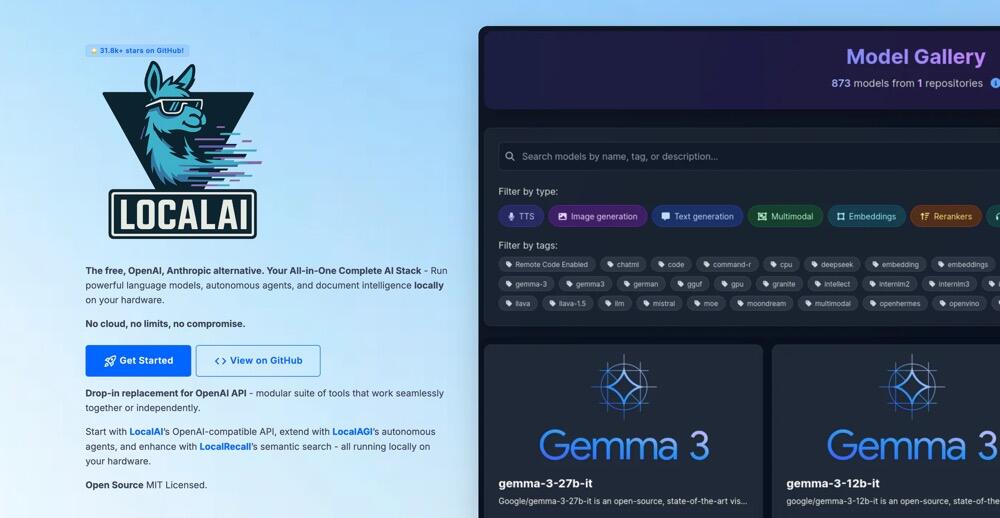

LocalAI:你的本地AI神器,轻松打造专属智能应用!

2025年04月19日

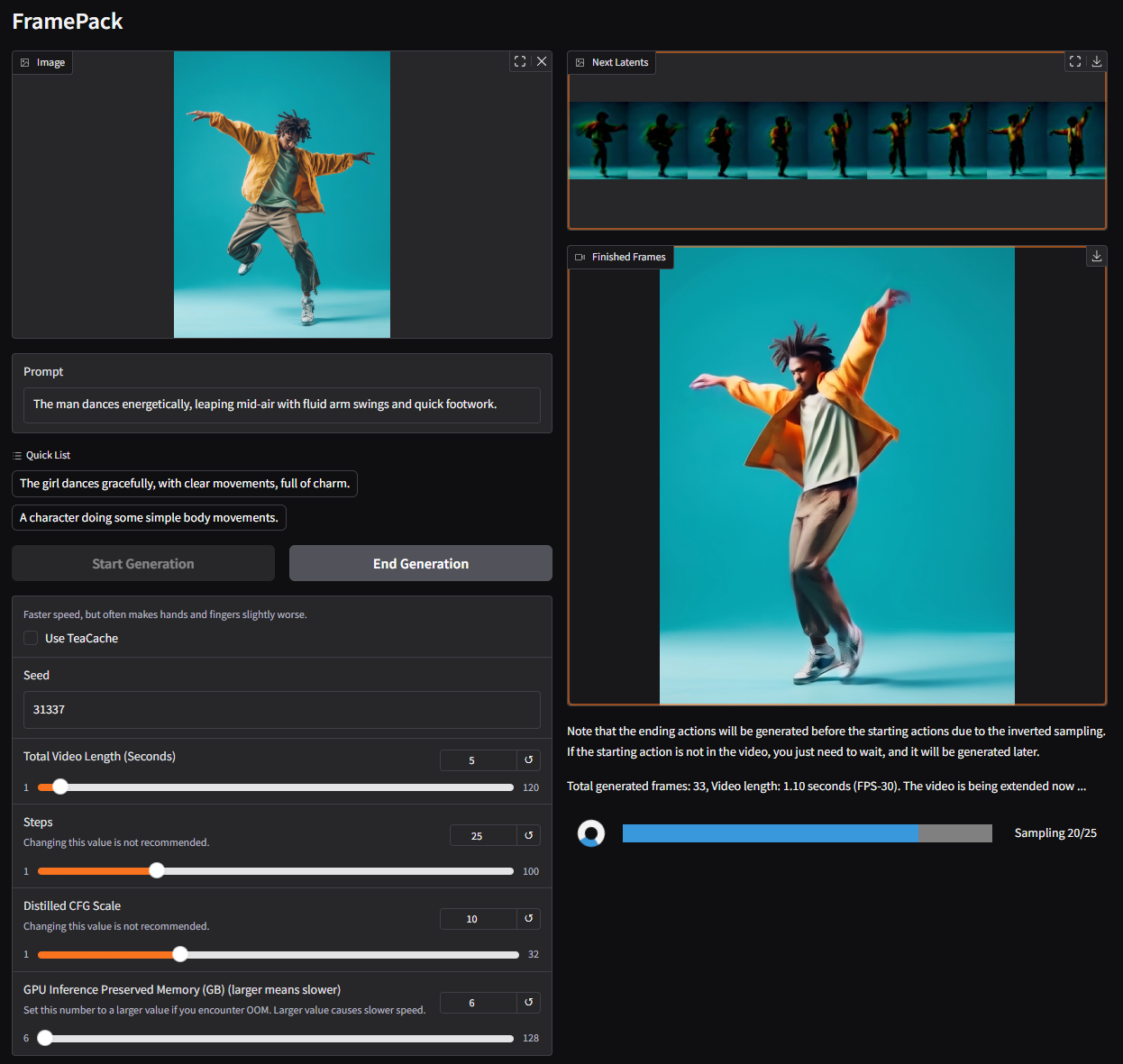

FramePack:让视频生成像玩游戏一样简单!

2025年04月20日

MCPO:让 AI 工具秒变 RESTful API 的“魔法桥梁”!

2025年04月20日

GigaTok:扩展视觉标记器至 30 亿参数用于自回归图像生成

2025年04月20日

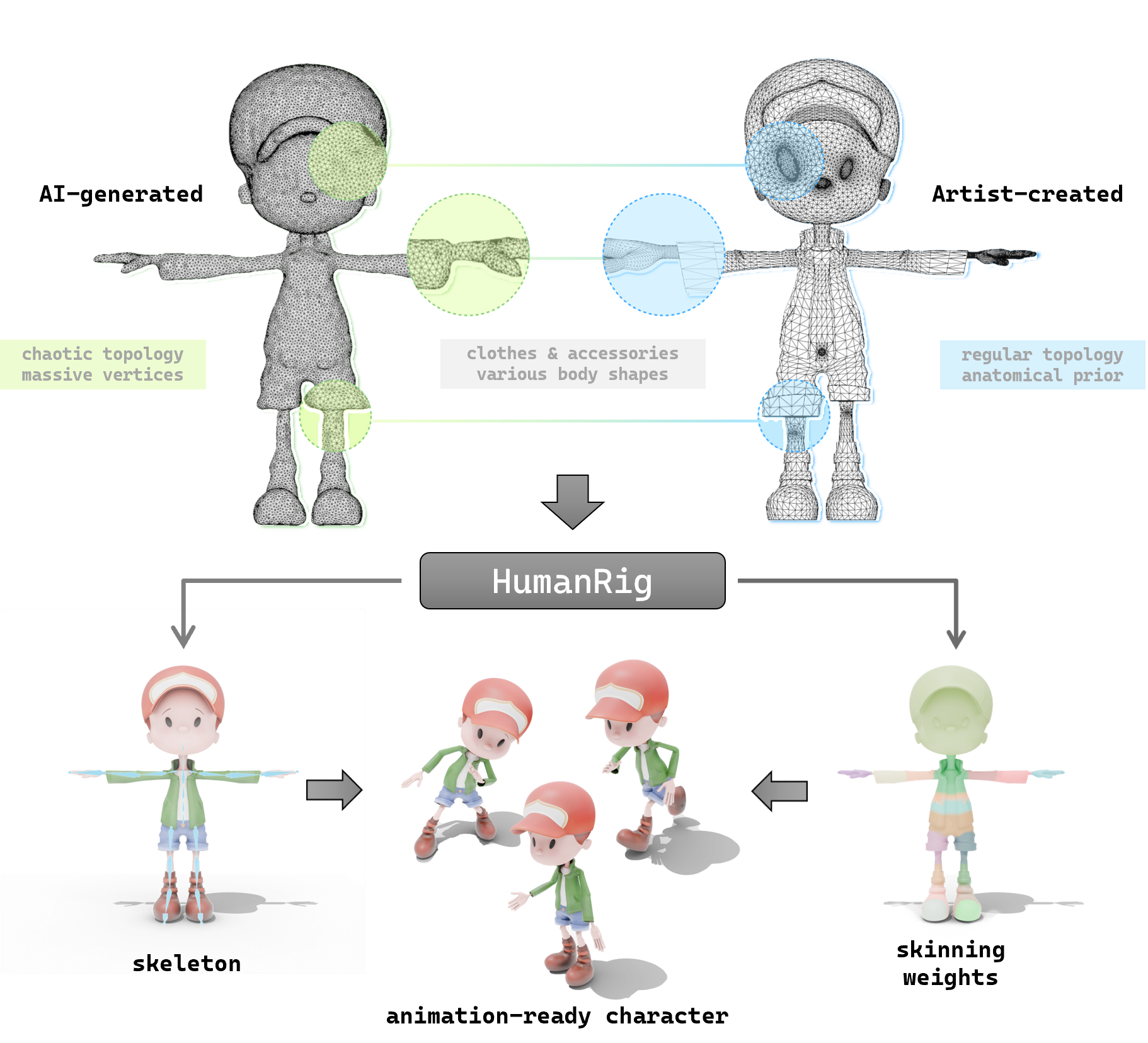

探索 HumanRig:让 3D 角色动画更简单的开源神器

2025年04月20日

探索 so-vits-svc:让你的动漫角色开口唱歌的 AI 神器

2025年04月22日

Suna 开源项目介绍:通用 AI 代理的轻松上手指南

2025年04月23日

让 AI 更懂你的网站:一文读懂 llms-txt 开源项目

2025年04月24日