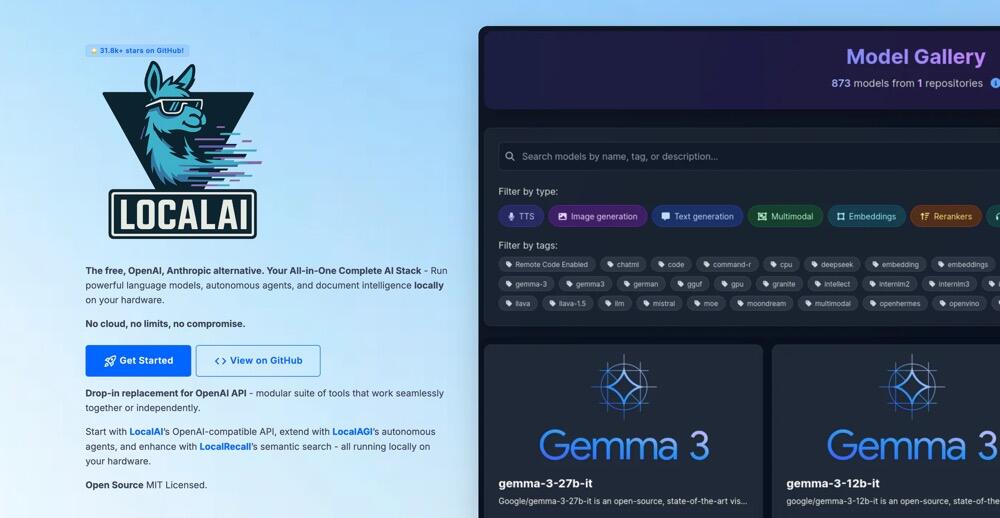

LocalAI:你的本地AI神器,轻松打造专属智能应用!

想在自己的电脑上跑一个媲美OpenAI、Claude的AI模型,还不用花钱买GPU?LocalAI 就是你的答案!这个由Ettore Di Giacinto主导的开源项目,号称“免费的OpenAI替代品”,不仅能跑大模型,还支持文本、图像、音频、视频生成,甚至能搞语音克隆!

项目功能:一个全能的本地AI工具箱

LocalAI的目标很简单:让每个人都能在消费级硬件上运行强大的AI模型,数据本地化,隐私有保障。它不仅是一个模型推理引擎,还提供了一套OpenAI兼容的API,让你可以用熟悉的开发方式打造自己的AI应用。来看看它的核心功能:

- 多模态生成,样样精通

LocalAI支持文本生成(LLM)、图像生成(Stable Diffusion)、音频生成(TTS)、语音转文字(Whisper),甚至还能进行语音克隆和视频生成。想让AI写文章、画图、配音,还是生成一个短视频?LocalAI一键搞定!

2. OpenAI API兼容,开发超方便

LocalAI提供与OpenAI API兼容的REST API,意味着你可以用现有的OpenAI客户端库无缝切换到LocalAI。比如,你可以用Python的openai库调用LocalAI的模型,完全不用改代码。

-

本地运行,隐私第一

所有数据都在你的设备上处理,不需要上传到云端,隐私安全有保障。对于企业和个人开发者来说,这点尤其重要。 -

支持多种模型和后端

LocalAI支持多种模型架构,包括llama.cpp(跑Llama模型)、transformers(Hugging Face模型)、diffusers(图像生成)、whisper.cpp(语音转文字)等。你可以跑Llama、Gemma、Phi-2,甚至Stable Diffusion,模型选择非常丰富。 -

无需GPU,消费级硬件也能玩

不需要昂贵的NVIDIA GPU,普通的CPU就能跑!当然,如果你有GPU(支持NVIDIA CUDA或AMD ROCm),性能还能再上一层楼。 -

生态扩展:LocalAGI和LocalRecall

LocalAI最近推出了LocalAGI(一个AI代理编排平台,支持无代码配置)和LocalRecall(持久化代理记忆API),让开发者可以轻松构建复杂的AI工作流,比如自动化聊天机器人、GitHub问题解答机器人等。 -

社区驱动,活跃更新

LocalAI是完全开源的(MIT许可证),社区非常活跃。2025年4月,项目已经迭代到v2.28.0,新增了WebUI优化、P2P分布式推理、FLUX-1模型支持等功能,Discord和GitHub讨论区里每天都有新点子冒出来!

技术栈:模块化设计,灵活又强大

LocalAI的技术栈非常现代化,设计上注重模块化和易用性,开发者可以根据需求自由组合。以下是它的核心技术栈:

-

核心框架:Golang(后端)、Python(部分后端模块)

LocalAI的核心是用Golang写的,性能高效且跨平台。部分后端(比如diffusers)用Python实现,方便集成Hugging Face生态。 -

模型后端:

llama.cpp:支持Llama、Gemma等GGUF格式模型,优化了CPU推理。transformers:支持Hugging Face的PyTorch模型。diffusers:用于Stable Diffusion等图像生成模型。whisper.cpp:用于语音转文字。vLLM:支持高效的LLM推理,新增了图像和视频处理能力。- 新增后端(2025年):

stablediffusion.cpp、bark.cpp(语音生成)、faster-whisper等。

-

容器化支持:Docker、Podman、Kubernetes

LocalAI提供多种容器镜像(CPU、GPU、All-in-One),支持Docker和Kubernetes部署,适合从个人开发到企业级应用。 -

WebUI:React、JavaScript

LocalAI自带一个现代化Web界面(2025年4月全新改版),支持模型管理和一键安装模型,操作简单直观。 -

其他:gRPC(模型推理通信)、FFmpeg(音视频处理)、libp2p(P2P分布式推理)。

项目还支持SYCL(用于Intel硬件加速)和NVIDIA L4T(面向Jetson设备),硬件兼容性极强。 -

模型来源:Hugging Face、Ollama、模型画廊(https://models.localai.io)

你可以直接从Hugging Face或Ollama拉取模型,也可以用LocalAI的模型画廊一键安装预配置模型,比如llama-3.2-1b-instruct或hermes-2-pro-mistral。

搭建难度

LocalAI的搭建过程对新手来说不算复杂,尤其是通过Docker部署,基本几分钟就能跑起来。以下是详细的搭建指南和可能遇到的问题:

准备工作

- 系统要求:支持Linux(推荐Ubuntu)、MacOS、Windows(建议用WSL2或Git Bash)。

- 硬件要求:普通CPU(4核8GB内存起步),GPU可选(NVIDIA/AMD支持)。

- 依赖工具:Docker(推荐)或Podman,curl(用于API测试),可选:Python、Golang(源码编译)。

搭建步骤(以Docker为例)

-

拉取容器镜像

根据你的硬件选择合适的镜像:bash# CPU镜像 docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-cpu # NVIDIA GPU镜像 docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12 # All-in-One镜像(预装模型) docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu -

访问WebUI

打开浏览器,访问http://localhost:8080,即可进入LocalAI的Web界面,浏览模型画廊或上传自定义模型。 -

运行模型

通过CLI或WebUI加载模型:bash# 从模型画廊运行Llama-3.2 local-ai run llama-3.2-1b-instruct:q4_k_m # 从Hugging Face运行Phi-2 local-ai run huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf -

测试API

用curl测试OpenAI兼容API:bashcurl http://localhost:8080/v1/chat/completions -H "Content-Type: application/json" -d '{ "model": "llama-3.2-1b-instruct:q4_k_m", "messages": [{"role": "user", "content": "Hello, how are you?"}] }'

可能遇到的坑

- Windows兼容性:Windows用户建议用Docker Desktop或WSL2,直接用PowerShell可能会遇到路径问题。

- 模型加载失败:如果模型文件格式不对(比如GGUF文件损坏),可能报错

gguf_init_from_file: invalid magic characters。检查文件完整性或重新下载。 - GPU支持问题:确保NVIDIA驱动和CUDA工具包正确安装,

.env文件中CUDA设置为true。 - 内存不足:大模型需要较多内存(推荐16GB+),可以用量化模型(如Q4_K_M)降低需求。

- 网络问题:从Hugging Face或模型画廊下载模型时,可能需要科学上网。

适合人群

- 新手开发者:如果你会基本的Linux命令或Docker操作,跟着官方文档(https://localai.io)走,1小时内就能跑起来。WebUI对小白尤其友好。

- AI爱好者:想玩Llama、Stable Diffusion但没GPU?LocalAI是最佳选择,支持本地模型推理。

- 企业开发者:需要本地化AI解决方案或开发聊天机器人、自动化工具,LocalAI的API和LocalAGI扩展非常实用。

- 开源贡献者:项目代码清晰,社区欢迎新手贡献(比如优化文档、添加模型支持)。

总体来说,搭建难度属于“简单到中等”,Docker用户几乎零门槛,源码编译或自定义模型可能需要一些调试。官方文档详细,Discord社区(https://discord.gg/uJAeKSAGDy)响应很快,遇到问题不怕没人帮!

总结

2025年的最新版本(v2.28.0)带来了WebUI优化、LocalAGI重构、P2P分布式推理等功能,未来潜力无限。

优点:

- OpenAI API兼容,开发门槛低

- 支持多模态生成,功能全面

- 无需GPU,隐私安全,社区活跃

- Docker部署简单,WebUI好用

不足:

- 大模型推理对内存要求较高

- Windows原生支持稍弱,推荐Linux

- 部分新后端(如bark.cpp)还在优化中

快去GitHub给LocalAI点个Star,跑个Docker容器试试吧!

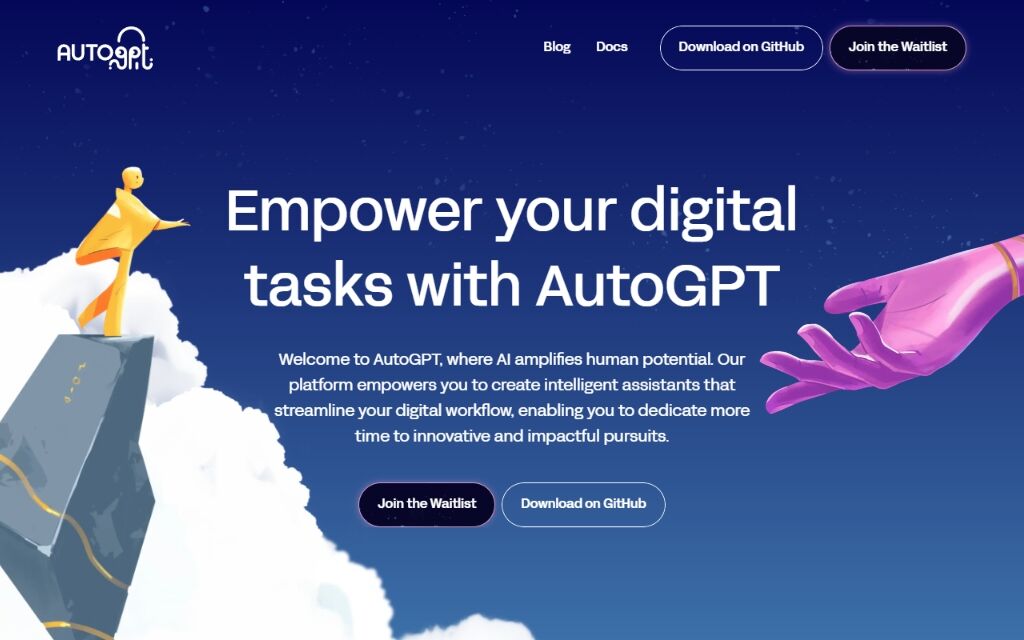

AutoGPT:让AI帮你“自动搞定一切”的开源神器

2025年04月11日

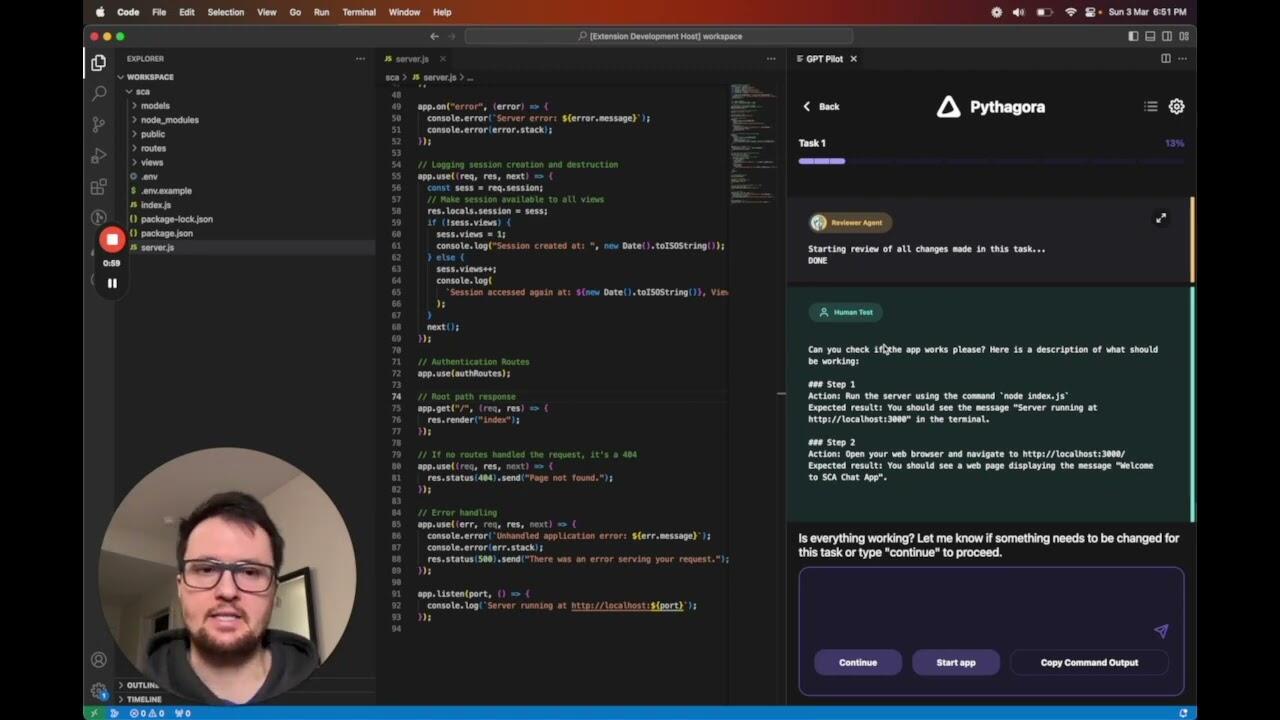

GPT-Pilot:你的AI编程助手,带你从零打造应用!

2025年04月19日

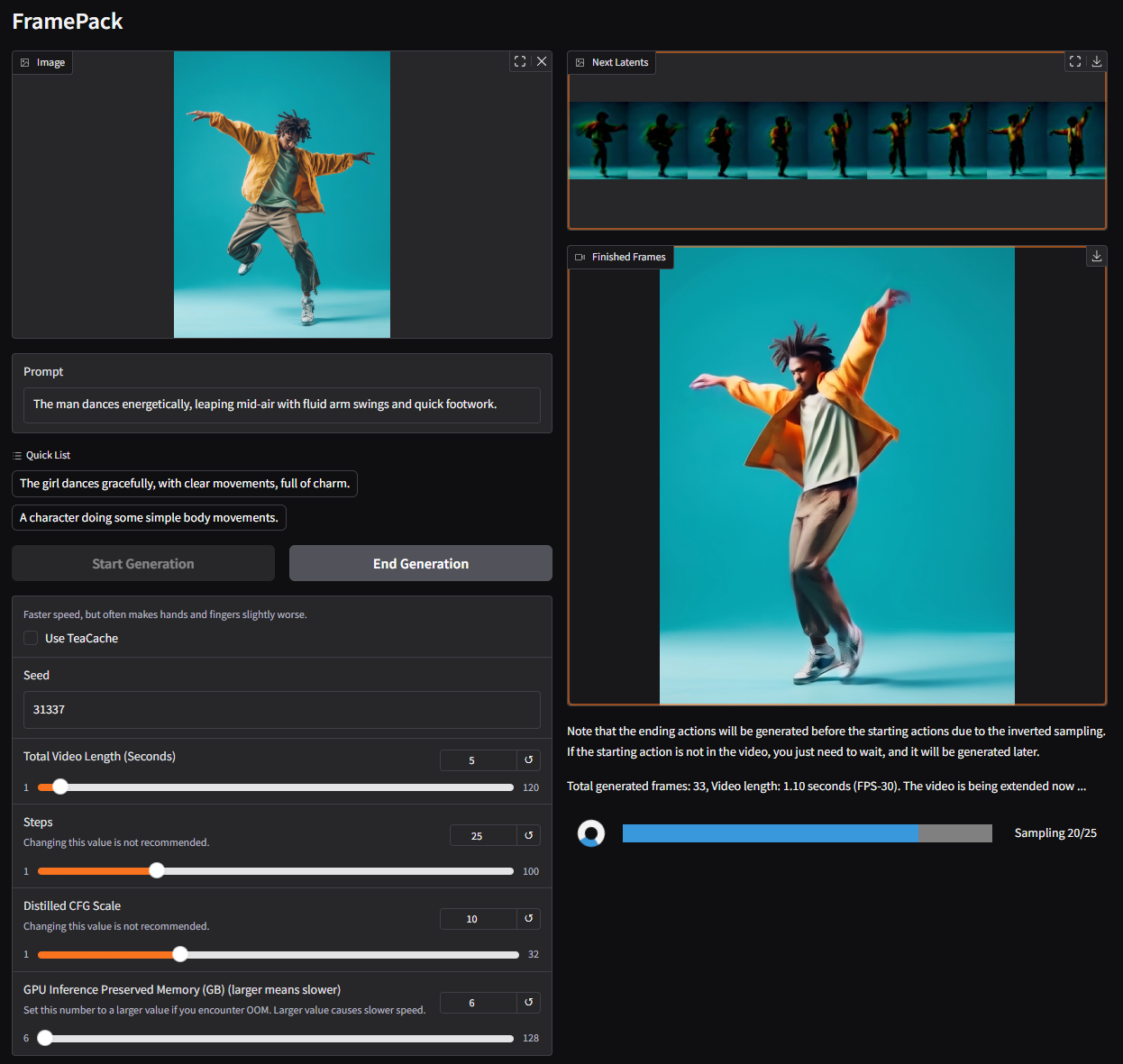

FramePack:让视频生成像玩游戏一样简单!

2025年04月20日

MCPO:让 AI 工具秒变 RESTful API 的“魔法桥梁”!

2025年04月20日

GigaTok:扩展视觉标记器至 30 亿参数用于自回归图像生成

2025年04月20日

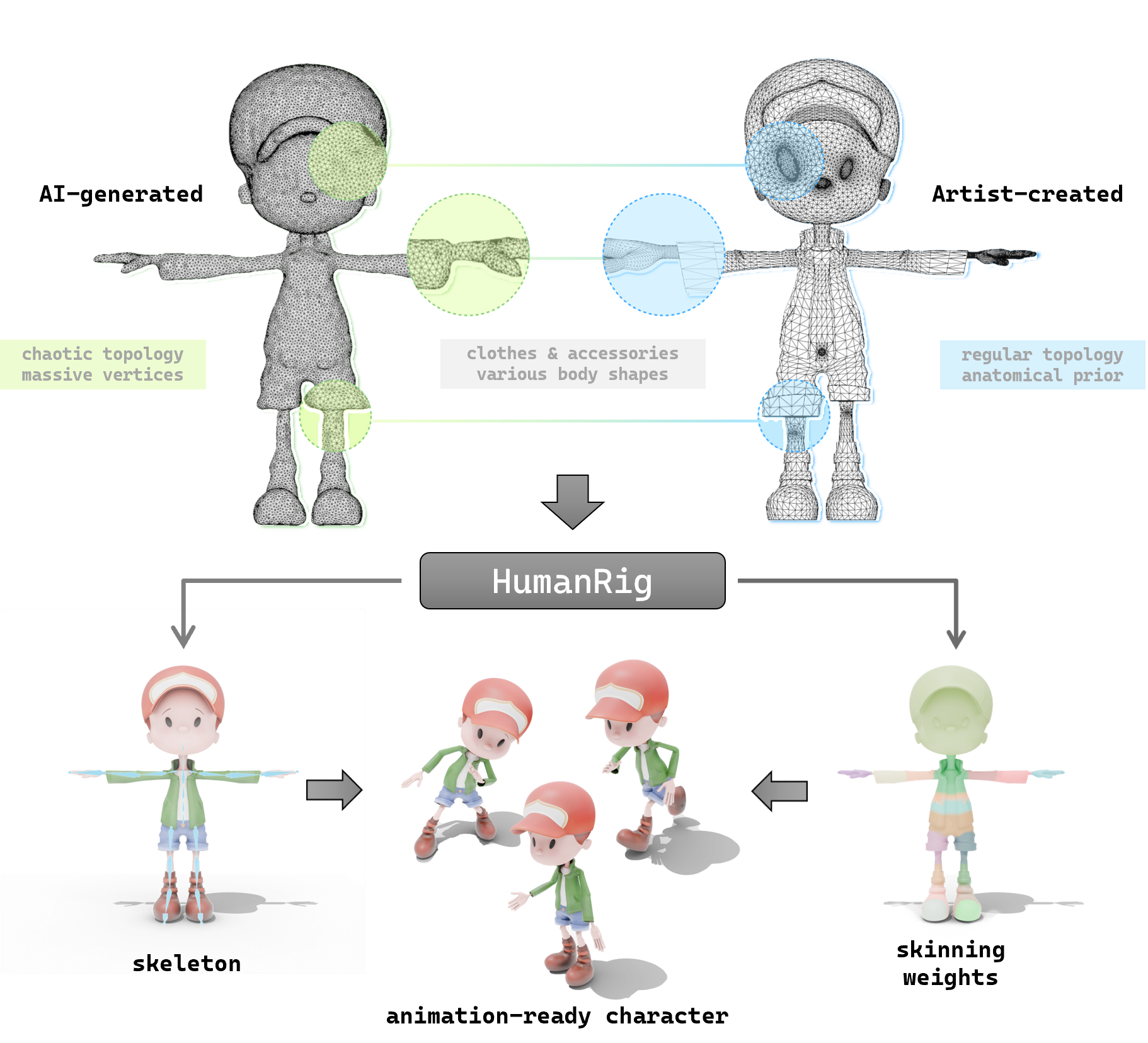

探索 HumanRig:让 3D 角色动画更简单的开源神器

2025年04月20日

PlayHT(PlayAI) —— AI语音生成神器,轻松打造逼真语音内容

2025年04月23日

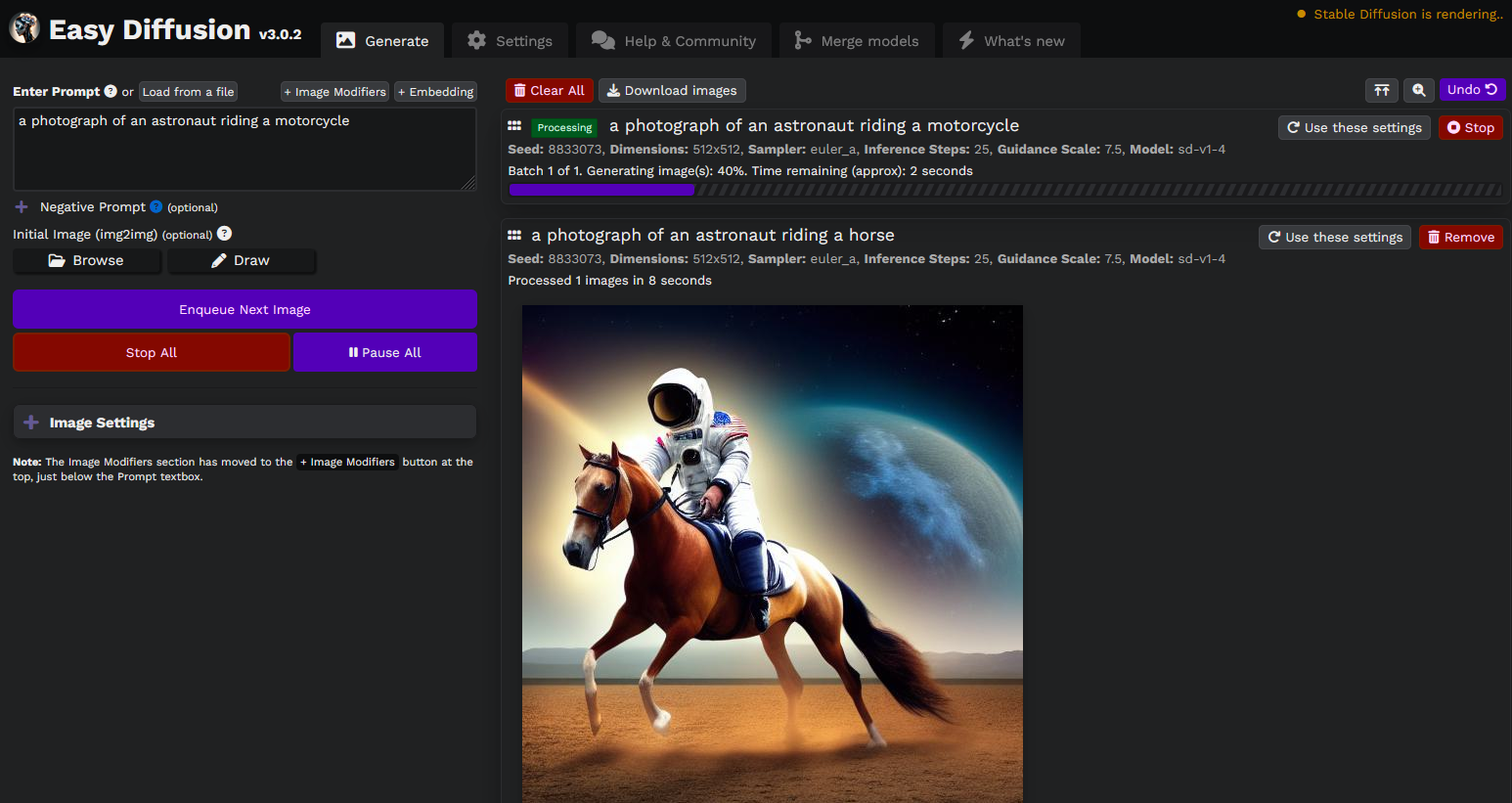

Easy Diffusion:一键生成AI艺术,零技术门槛的开源神器!

2025年04月24日

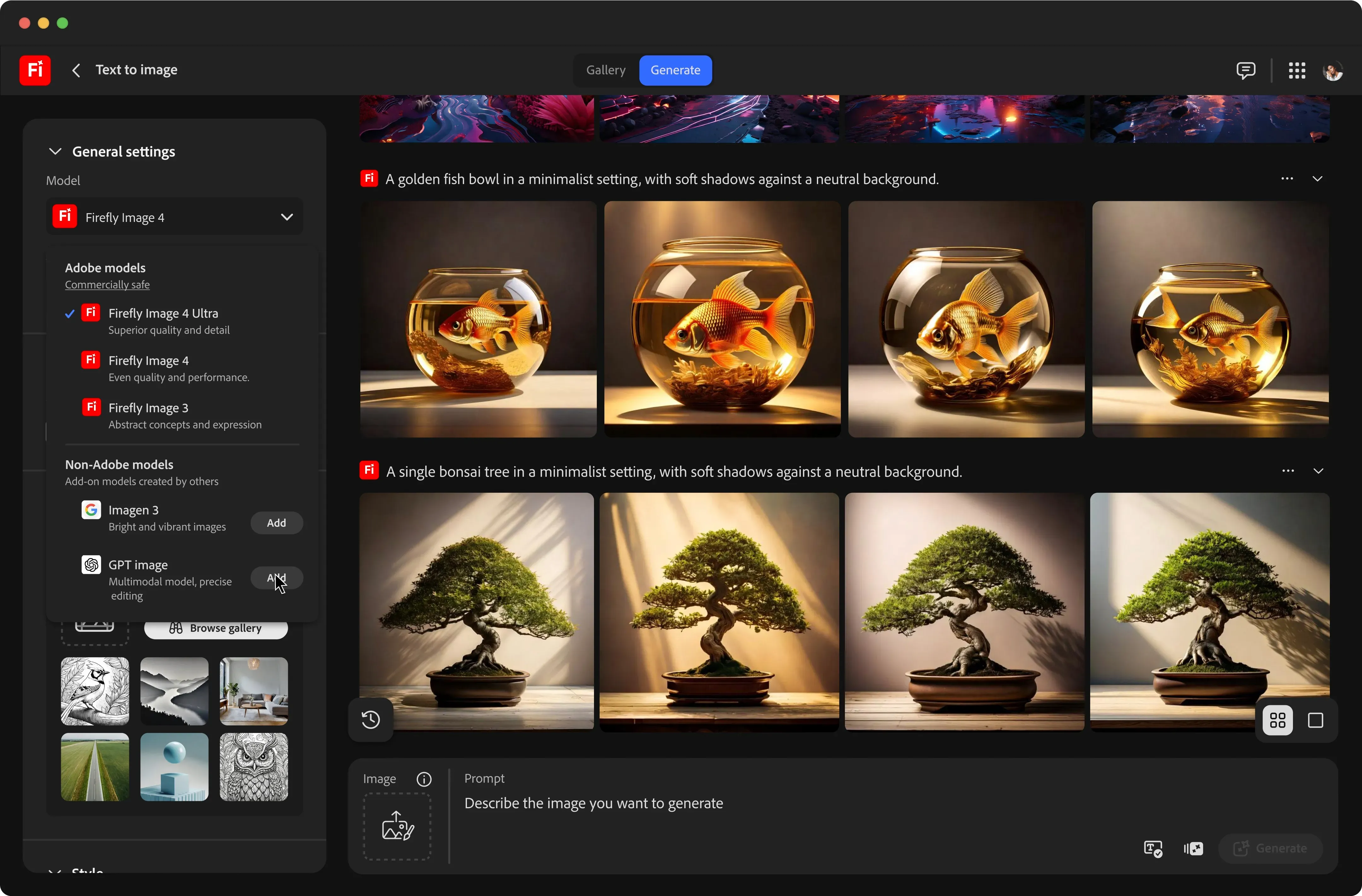

Adobe 重磅升级 Firefly:推出图像模型 4 与矢量生成模型,整合多家 AI 平台

2025年04月25日