MAGI-1:用AI生成视频的“魔法”开源项目,带你走进未来影视创作!

如果你对AI生成视频充满好奇,或者想自己动手打造一段炫酷的AI视频,那么今天要介绍的这个开源项目——MAGI-1,绝对值得你一探究竟!

这个项目来自GitHub上的SandAI-org,号称是“自回归视频生成的大规模解决方案”,不仅技术硬核,还完全开源,Apache 2.0许可证随便用!

一、MAGI-1是什么?

简单来说,MAGI-1 是一个基于AI的视频生成模型,专注于通过文本指令生成高质量视频。它的核心理念是将视频分成一个个小块(chunk),通过自回归的方式逐块生成,最终拼成一段流畅的视频。这种“分块生成”的方式不仅高效,还能保证视频的时间连贯性和细节表现。

核心功能亮点

-

文本驱动的视频生成(Image-to-Video, I2V)

你只需要输入一段文字描述,比如“一只猫在月光下跳舞”,MAGI-1就能生成一段对应的视频,画面细节和动作流畅度都相当不错。它在指令遵循和运动质量上,甚至能和一些闭源商业模型(如Kling1.6)掰掰手腕! -

分块生成,流式输出

MAGI-1把视频分成每块24帧的小段,逐块去噪生成。这种设计让它支持流式生成(streaming generation),可以一边生成一边播放,特别适合实时应用场景。 -

超强的时间一致性

得益于自回归和去噪训练,MAGI-1生成的视频在场景过渡和物体运动上非常自然。比如,你让它生成一段“汽车在高速公路上飞驰”的视频,车轮转动、背景移动都会显得很真实。 -

可控生成,细粒度调整

通过分块提示(chunk-wise prompting),你可以精确控制视频的每一部分,比如让场景平滑切换,或者延长视频时长,特别适合需要叙事感的视频创作。 -

开源模型,两种选择

MAGI-1提供了24B(240亿参数)和4.5B(45亿参数)两种模型,前者适合追求极致画质,后者更轻量,适合资源有限的设备。还有蒸馏和量化版本,推理速度更快。

应用场景

- 内容创作:为短视频平台生成创意视频,省去拍摄和剪辑的麻烦。

- 游戏开发:快速生成游戏中的动态背景或过场动画。

- 教育与宣传:根据文本生成教学视频或广告宣传片。

- 科研探索:研究AI视频生成算法的开发者可以直接用它的预训练权重和推理代码。

一句话总结:给MAGI-1一段文字指令,它就能变出高质量的视频,而且开源免费,随你折腾!

二、技术栈

MAGI-1的技术架构非常硬核,但我们可以用大白话来拆解它的核心组件,让你轻松get它的技术魅力。

1. 模型架构

-

变分自编码器(VAE)+ Transformer

MAGI-1使用变分自编码器(VAE)进行视频压缩,空间压缩8倍,时间压缩4倍,这让它在生成高分辨率视频时既快又省资源。核心的生成逻辑则依赖Transformer架构,处理长序列的视频数据游刃有余。 -

自回归去噪(Autoregressive Denoising)

视频生成的过程有点像“从模糊到清晰”。MAGI-1会先给视频块加噪声,然后逐步去噪,每块24帧整体处理,下一块在当前块去噪到一定程度时就开始生成。这种设计让生成过程更高效,还能并行处理最多四个块。 -

MagiAttention

这是一个专门为超长上下文设计的分布式注意力机制,来自SandAI的另一个开源项目(https://github.com/SandAI-org/MagiAttention)。它能处理高达400万个视频token的训练数据,确保模型在长视频生成时不崩。[](https://github.com/SandAI-org/MagiAttention)

2. 技术依赖

MAGI-1的运行环境基于Python和PyTorch,具体依赖包括:

- Python 3.10.12:项目推荐的Python版本。

- PyTorch 2.4.0:支持GPU加速,推荐搭配CUDA 12.4。

- FFmpeg 4.4:用于视频处理,比如格式转换。

- MagiAttention:需要单独安装,处理分布式注意力计算。

- 其他依赖通过

requirements.txt一键安装,省心省力。

3. 硬件要求

- GPU:官方推荐Hopper架构的GPU(如NVIDIA H100),但其他高性能GPU(如A100)也能跑。

- 内存:24B模型需要大显存(建议80GB+),4.5B模型对硬件要求低一些(16GB显存也能凑合)。

- 存储:预训练权重和代码需要几十GB空间,建议准备一块大硬盘。

4. 开源生态

MAGI-1的代码、预训练权重和推理脚本都托管在GitHub,技术报告也公开(https://static.magi.world/static/files/MAGI_1.pdf)。项目还对接了Hugging Face(https://huggingface.co/sand-ai/MAGI-1),方便模型下载和社区交流。[](https://huggingface.co/sand-ai/MAGI-1)

总结一下,MAGI-1的技术栈虽然复杂,但核心逻辑清晰:用VAE+Transformer压缩和生成视频,结合MagiAttention处理超长序列,PyTorch提供计算支持。普通开发者只要熟悉Python和深度学习基础,就能看懂它的代码。

三、搭建难度

对于想上手MAGI-1的朋友,搭建难度主要取决于你的硬件条件和编程经验。以下是详细的搭建步骤和难度分析。

搭建步骤

根据官方文档(https://github.com/SandAI-org/MAGI-1),搭建MAGI-1的步骤如下:

-

创建Conda环境

bashconda create -n magi python==3.10.12 conda activate magi这步很简单,Conda用户闭眼操作。

-

安装PyTorch和依赖

bashconda install pytorch==2.4.0 torchvision==0.19.0 torchaudio==2.4.0 pytorch-cuda=12.4 -c pytorch -c nvidia pip install -r requirements.txtPyTorch安装需要注意CUDA版本匹配,建议提前检查你的GPU驱动。

-

安装FFmpeg

bashconda install -c conda-forge ffmpeg=4.4FFmpeg是视频处理的标配,安装过程无脑。

-

安装MagiAttention

bashgit clone git@github.com:SandAI-org/MagiAttention.git cd MagiAttention git submodule update --init --recursive pip install --no-build-isolation .这步稍微麻烦点,需要单独拉取另一个仓库,但跟着命令走没啥问题。

-

运行推理脚本

MAGI-1提供了example/24B/run.sh和example/4.5B/run.sh两个脚本,修改里面的参数(比如--config_file指向模型配置文件)就能跑。脚本支持Docker运行,简化环境配置。

难度分析

-

新手(零基础):

如果你完全没接触过Python或深度学习,可能会被Conda环境、GPU配置和MagiAttention的安装整懵。建议先学点Python基础和PyTorch入门知识,再来挑战。预计上手时间:2-3周。 -

有Python经验但无AI背景:

你能轻松搞定环境配置,但理解模型推理和参数调整可能需要花点时间看文档。跟着GitHub的README走,1-2天能跑通demo。 -

AI开发者(熟悉PyTorch):

这对你来说就是小菜一碟!环境搭建1小时内搞定,跑推理和调参数最多半天。唯一可能的坑是显存不够,建议优先用4.5B模型。 -

硬件门槛:

最大的难点是硬件。24B模型对显存要求很高,家用RTX 3090(24GB)可能都跑不动,4.5B模型更亲民。如果没GPU,可以考虑云服务(比如AWS或Google Cloud),但成本不低。

小Tips

- 用Docker:官方推荐Docker部署,能避免环境冲突,强烈建议新手尝试。

- 查文档:GitHub和Hugging Face的文档很详细,遇到问题先翻README。

- 社区求助:项目在GitHub上有活跃的Issue区(https://github.com/SandAI-org/MAGI-1/issues),可以直接提问题。[](https://github.com/SandAI-org/MAGI-1/issues)

总的来说,MAGI-1的搭建难度对AI开发者来说偏低,对新手有一定挑战,但只要有基础的Python知识和一台像样的GPU,跑通demo完全不是梦!

AutoGPT:让AI帮你“自动搞定一切”的开源神器

2025年04月11日

SkyReels-A2开源革命:解锁商用级‘元素到视频’的无限创意

2025年04月10日

GPT-Pilot:你的AI编程助手,带你从零打造应用!

2025年04月19日

LocalAI:你的本地AI神器,轻松打造专属智能应用!

2025年04月19日

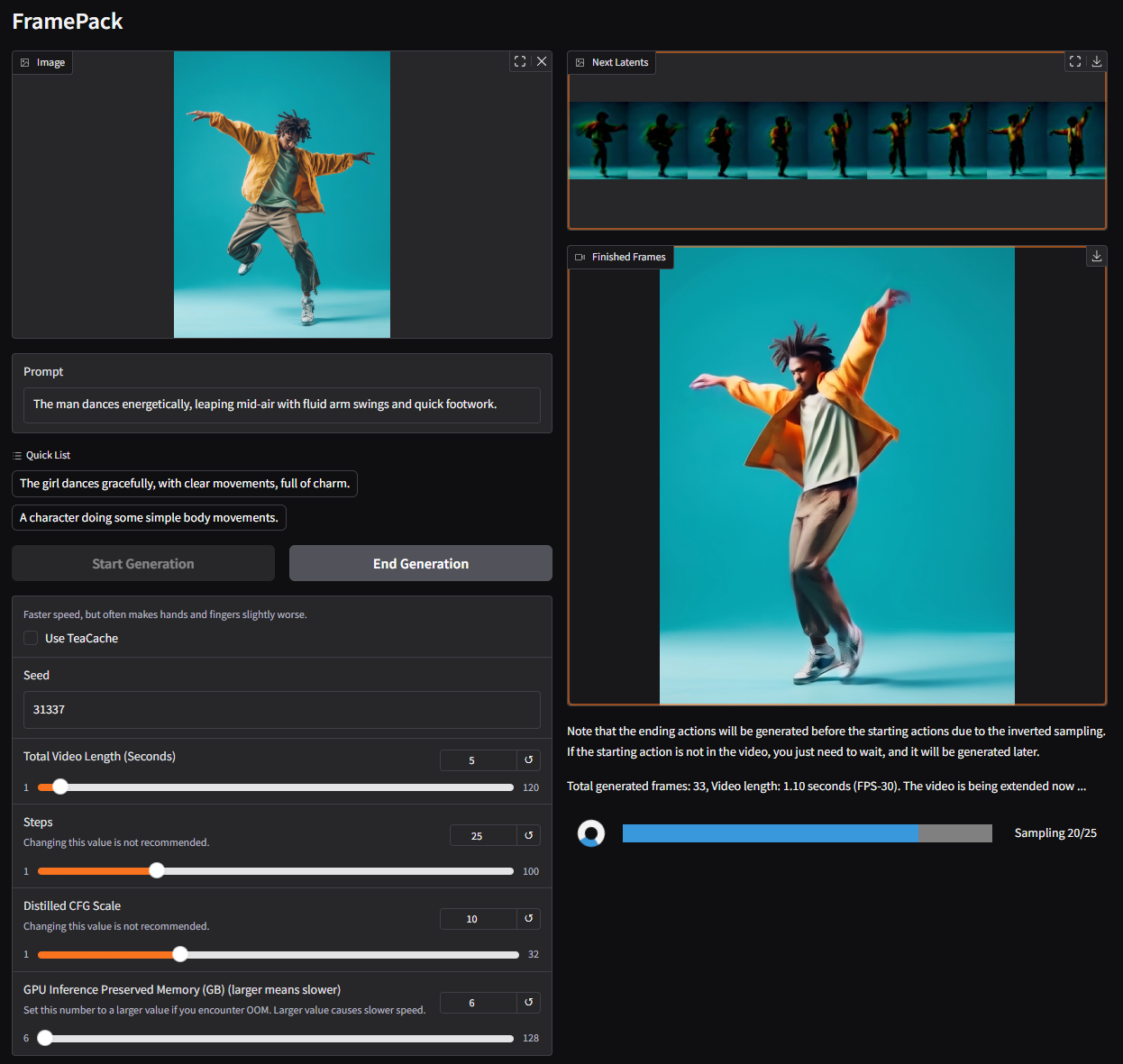

FramePack:让视频生成像玩游戏一样简单!

2025年04月20日

MCPO:让 AI 工具秒变 RESTful API 的“魔法桥梁”!

2025年04月20日

GigaTok:扩展视觉标记器至 30 亿参数用于自回归图像生成

2025年04月20日

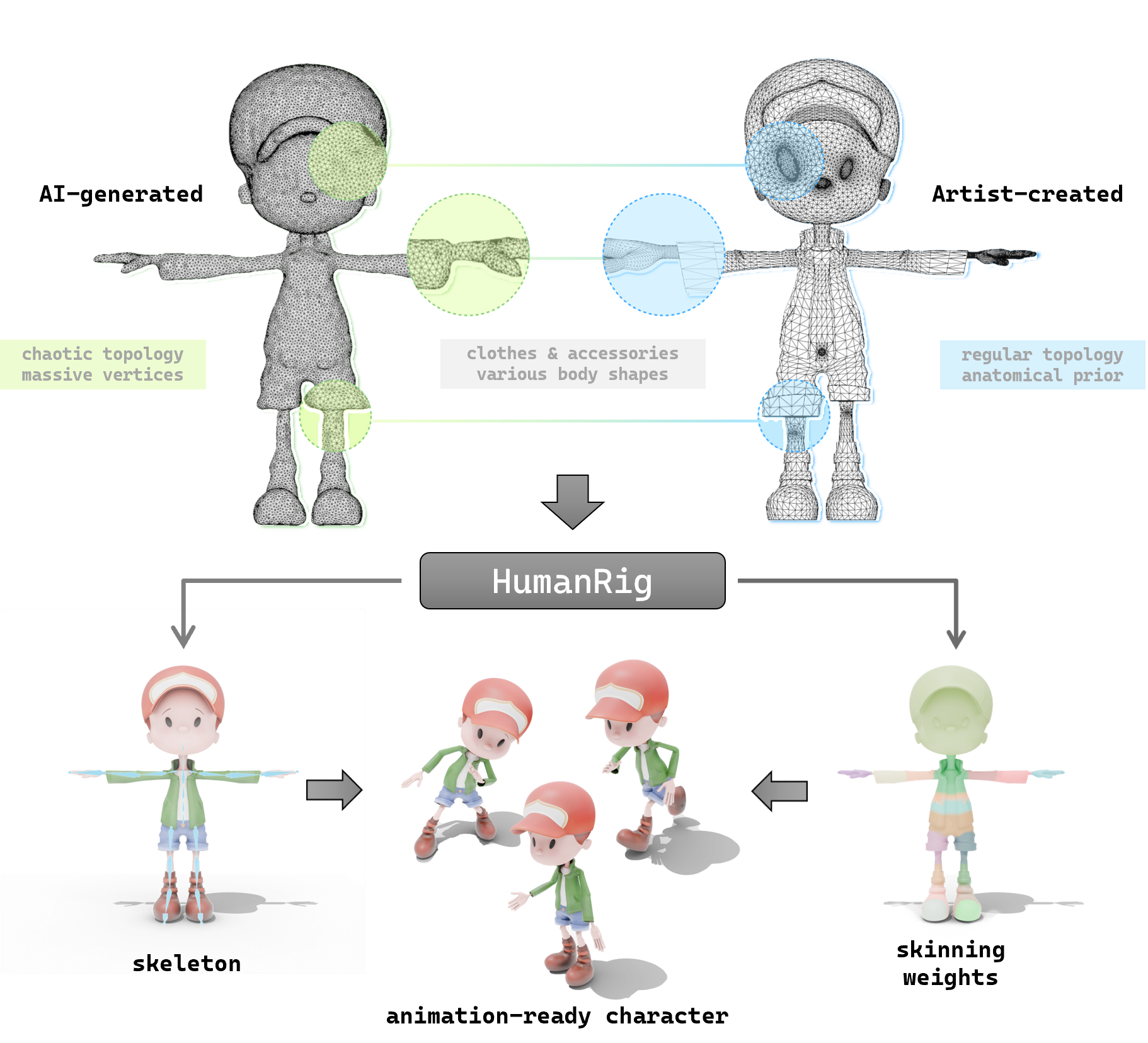

探索 HumanRig:让 3D 角色动画更简单的开源神器

2025年04月20日

探索 so-vits-svc:让你的动漫角色开口唱歌的 AI 神器

2025年04月22日