大模型的新突破:LiveCC 让“直播 AI 解说”成为现实

如果你对视频大语言模型(Video LLM)有所耳闻,可能会觉得它们听起来很高大上,但实际用起来却有点“慢半拍”——毕竟,大部分模型都是为离线视频设计的,面对实时直播流就有点“抓瞎”了。今天要介绍的 LiveCC,就是 ShowLab 在 GitHub 上开源的一个项目(仓库地址:https://github.com/showlab/livecc),专门解决视频大模型处理实时流媒体的难题。

项目功能

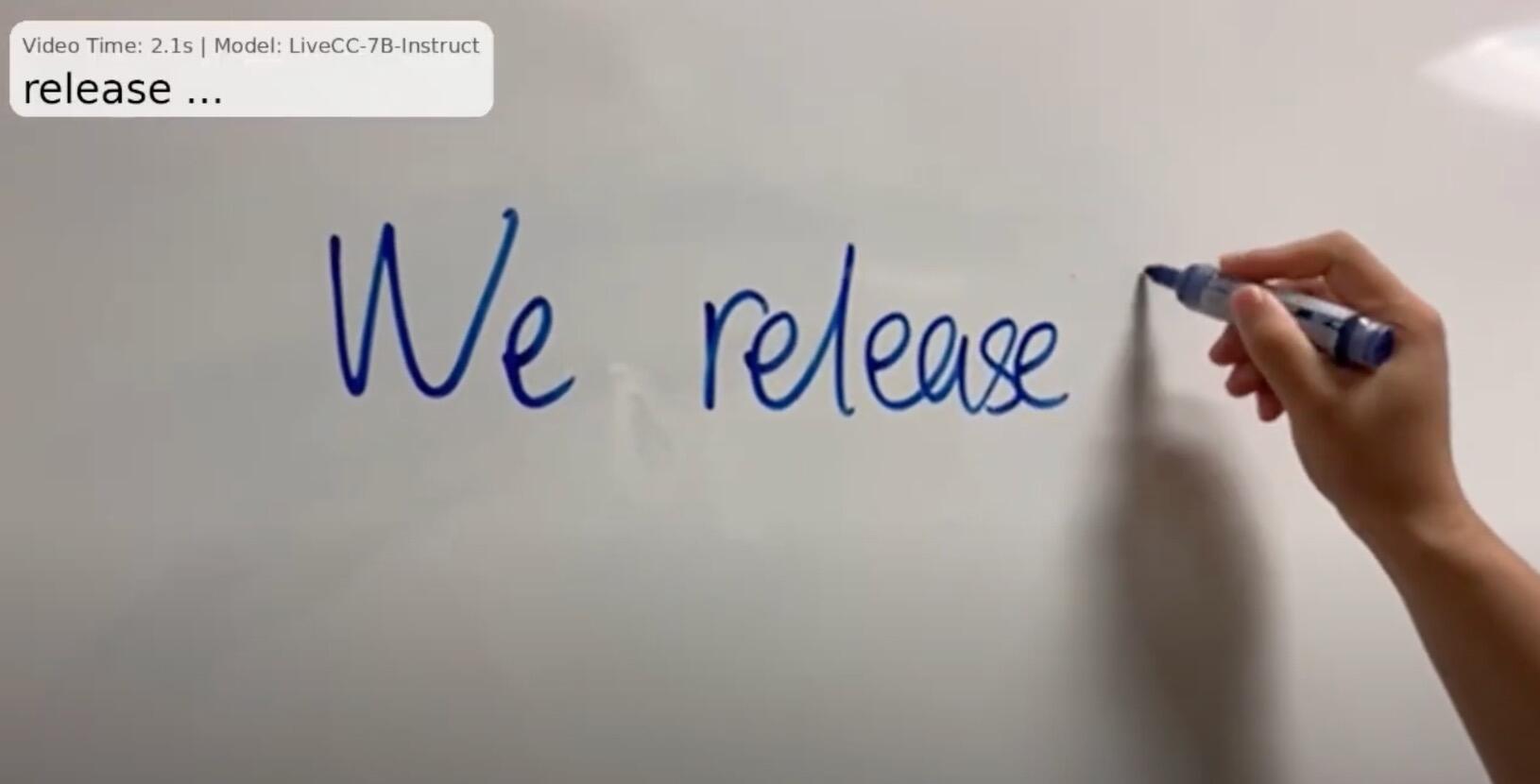

LiveCC 全名是 LiveCC: Learning Video LLM with Streaming Speech Transcription at Scale,听起来有点绕口,但核心功能可以总结为:让视频大模型能够实时处理直播视频流,并结合语音转录进行交互。简单来说,它就像给视频大模型装了个“实时翻译官”,能一边看直播一边“听”语音,随时生成对应的文本或响应。

具体功能亮点:

-

实时视频流处理:

不同于传统视频大模型需要等视频全部加载完才能分析,LiveCC 支持在线视频流处理。比如,你在看一场直播,LiveCC 能实时分析画面和语音,告诉你“主播刚提到了一款新手机”或者“画面里出现了一只猫”。 -

语音转录与多模态融合:

LiveCC 集成了语音转录功能,能把直播中的语音实时转为文本,并结合视频画面进行多模态理解。想象一下,它不仅能“看”到直播画面,还能“听”到主播在说什么,简直是全能选手! -

大规模训练优化:

项目针对直播场景设计了高效的数据处理和训练方法,能在海量数据上训练模型,保持性能的同时降低成本。这对开发者来说是个福音,毕竟谁不想用更少的算力干更多的事儿? -

开源与学术支持:

作为 CVPR 2025 的研究成果,LiveCC 提供了完整的代码和文档,方便开发者复现或二次开发。无论是想做学术研究还是商业应用,这都是个宝藏项目。

技术栈:Python 主导,AI 硬核

LiveCC 的技术栈非常现代化,核心围绕 Python 生态和深度学习框架展开。以下是主要技术点的拆解:

- 编程语言:Python(毫无疑问,AI 项目的标配语言)。

- 深度学习框架:PyTorch(灵活、易用,AI 研究者的最爱)。

- 多模态模型:项目基于视频大语言模型(Video LLM),结合了视觉和语音处理模块,具体实现可能涉及 Transformer 架构。

- 语音转录:虽然代码中没有明确提到具体语音转录库,但从文档来看,可能会用到类似 Whisper 或其他开源 ASR(自动语音识别)工具。

- 依赖管理:项目需要安装常见的 Python 库,比如 NumPy、Pandas,可能还有 FFmpeg 用于视频流处理。

- 开发环境:支持 Linux/MacOS,推荐使用 GPU 加速(NVIDIA CUDA 环境)。

总的来说,技术栈对熟悉 AI 开发的开发者来说并不陌生,但需要一定的深度学习和多模态模型基础。如果你之前玩过 PyTorch 或做过视频/语音相关的项目,上手会更快。

搭建难度:中等偏上,适合有经验的开发者

LiveCC 虽然开源,但毕竟是个学术项目,搭建和使用起来需要一定的技术背景。以下是对搭建难度的详细分析:

1. 环境配置(难度:★★★☆☆)

- 依赖安装:需要安装 Python、PyTorch 以及一些数据处理库。项目提供了 requirements.txt,pip 一键安装很方便,但可能会遇到版本兼容问题(AI 项目的经典“坑”)。

- GPU 环境:如果想跑得快,GPU 是必须的。配置 CUDA 和 cuDNN 对新手来说可能有点麻烦,建议用 Docker 容器化部署,省心省力。

- FFmpeg:视频流处理需要 FFmpeg,安装和配置不算复杂,但 Windows 用户可能需要额外折腾。

2. 数据集准备(难度:★★★★☆)

- LiveCC 的训练需要大量视频和语音数据,官方文档提到了一些预处理脚本,但数据集需要自己准备。如果你有现成的视频数据集(比如 YouTube-8M 或自建数据集),会省不少事;否则,收集和标注数据是个体力活。

- 语音转录部分的预处理可能需要额外的脚本支持,新手可能需要花时间搞清楚数据格式。

3. 模型训练与推理(难度:★★★★☆)

- 训练:LiveCC 的训练代码支持多 GPU 分布式训练,但需要较高的硬件资源(至少一张高性能 GPU,比如 A100)。训练参数配置在 YAML 文件中,调整起来不算太难,但需要理解模型的超参数含义。

- 推理:推理部分相对简单,官方提供了示例代码,可以直接用预训练模型跑 demo。不过,实时流处理的性能优化可能需要自己调试。

4. 文档与社区支持(难度:★★☆☆☆)

- 文档方面,LiveCC 提供了清晰的 README 和安装指南,学术项目的文档质量还是有保障的。

- 社区支持方面,作为 ShowLab 的项目,可以通过 GitHub Issues 或 ShowLab 的其他平台(如 Discord)寻求帮助。不过目前社区活跃度不算特别高,可能需要自己摸索。

适合人群:

- AI 开发者:熟悉 PyTorch 和多模态模型,想做视频/语音相关项目。

- 学术研究者:想复现 CVPR 2025 的论文成果,或基于 LiveCC 做扩展研究。

- 进阶爱好者:有一定 Python 和深度学习基础,愿意花时间折腾。

如果你是纯新手,建议先学点 PyTorch 和 Transformer 基础,再来挑战这个项目。

应用场景

LiveCC 的应用场景非常广泛,特别是在实时性要求高的领域。以下是一些可能的用例:

- 直播内容分析:实时监控直播内容,自动生成摘要或关键词,适合电商直播、游戏直播等场景。

- 智能客服:结合视频和语音,打造能“看”能“听”的智能客服,处理用户咨询更高效。

- 教育与培训:分析在线课程的直播内容,自动生成笔记或互动问答。

- 内容创作:为视频创作者提供实时字幕或内容推荐功能,提升创作效率。

最后,贴上仓库地址,感兴趣的同学快去 star 一波吧!

🔗 https://github.com/showlab/livecc

AutoGPT:让AI帮你“自动搞定一切”的开源神器

2025年04月11日

LLaMA-Factory:一键微调百种大模型的开源利器

2025年04月13日

LLMs-from-Scratch:从零打造ChatGPT的开源教科书

2025年04月13日

Open-Assistant:打造开源的“未来助手”,对话AI的平民革命!

2025年04月13日

GPT-Pilot:你的AI编程助手,带你从零打造应用!

2025年04月19日

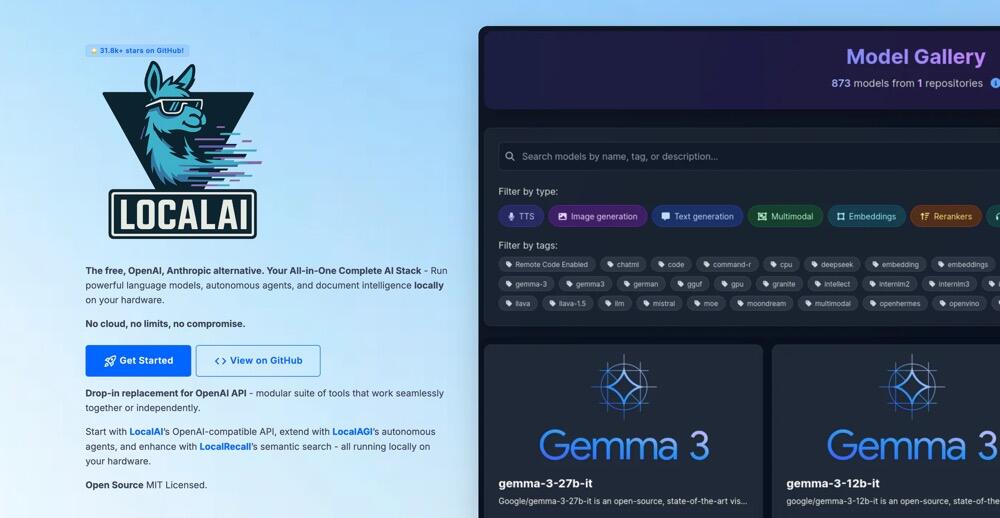

LocalAI:你的本地AI神器,轻松打造专属智能应用!

2025年04月19日

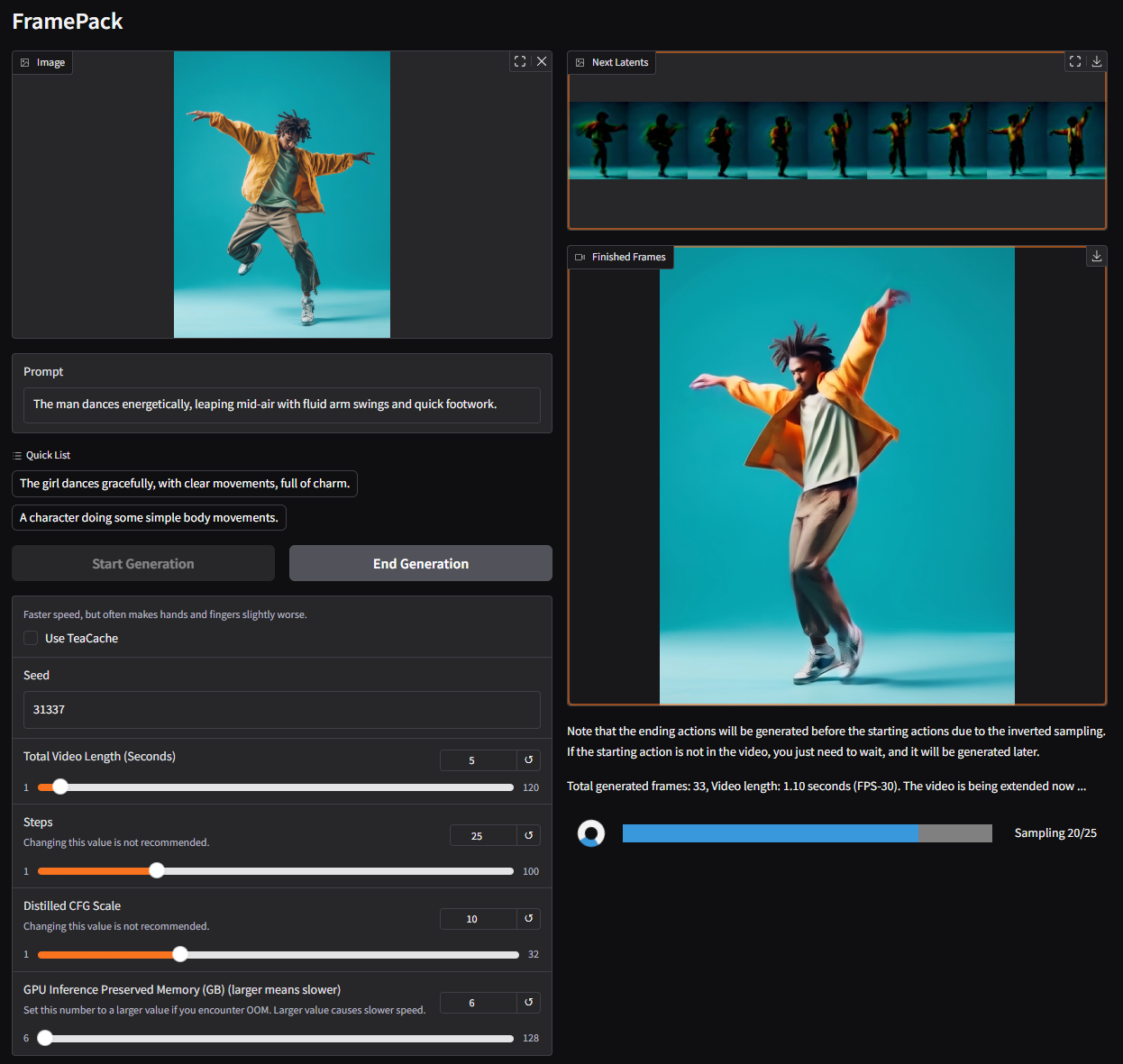

FramePack:让视频生成像玩游戏一样简单!

2025年04月20日

MCPO:让 AI 工具秒变 RESTful API 的“魔法桥梁”!

2025年04月20日

GigaTok:扩展视觉标记器至 30 亿参数用于自回归图像生成

2025年04月20日