Open-Assistant:打造开源的“未来助手”,对话AI的平民革命!

Open-Assistant:打造开源的“未来助手”,对话AI的平民革命!

如果你对AI聊天机器人充满兴趣,想体验一个完全开源、社区驱动的对话模型,或者希望亲手打造一个能写邮件、查资料甚至调用API的智能助手,那么今天要介绍的 Open-Assistant(GitHub地址)绝对值得你一探究竟!这个由 LAION-AI 发起的项目,目标是构建一个媲美ChatGPT的开源对话模型,不仅功能强大,还能跑在普通消费级硬件上。

一、Open-Assistant 是什么?能干啥?

Open-Assistant 是一个开源的聊天式AI助手,旨在让每个人都能用上强大的对话模型。它不仅能回答问题、写文章,还能理解复杂任务、调用外部API、动态检索信息,堪称“全能选手”。更重要的是,它完全开源,数据和模型都公开,强调伦理和隐私,目标是打破大厂对AI的垄断。

功能亮点

Open-Assistant 的核心功能包括:

- 多语言对话:支持35种语言,包括英语、中文、西班牙语等,能处理多语言任务,比如翻译、总结跨语言文档。

- 任务理解:能解析复杂指令,比如“帮我写一封正式邮件”或“分析这段代码的逻辑”。

- 动态信息检索:可以接入互联网或数据库,实时查找信息(还在开发中,但潜力巨大)。

- 第三方系统交互:未来能调用API,比如订票、查天气,甚至控制智能家居。

- 开源数据集:提供了 oasst1 和 oasst2 数据集,包含16.1万条人类标注的对话,覆盖多样化主题,供开发者训练自己的模型。

应用场景

Open-Assistant 的用途非常广泛:

- 个人助手:帮你写邮件、整理笔记、回答问题,像个贴身秘书。

- 教育与研究:学生可以用它总结文献,研究人员可以用数据集探索RLHF(强化学习人类反馈)技术。

- 开发者工具:想DIY一个专属聊天机器人?Open-Assistant 的代码和模型是现成的起点。

- 社区创新:开源特性让开发者可以定制模型,比如加行业知识库,打造医疗、金融领域的专属助手。

具体例子?上传一篇论文,Open-Assistant 能帮你提炼关键点;给它一段Python代码,它能指出优化建议;甚至问它“怎么用API查天气”,它会试着教你步骤。够全能吧?

注:项目已于2023年10月宣布“完成”(见GitHub issue #3720),但它的数据集和代码仍作为模板供开发者使用,oasst2 数据集在HuggingFace上广受欢迎。

二、技术架构:Open-Assistant 的“智能内核”

Open-Assistant 的架构围绕 对话模型 + RLHF + 社区数据 构建,核心是通过高质量的人类反馈数据,训练一个高效、伦理的AI助手。以下是它的架构拆解:

1. 数据收集与标注

- 众包数据:通过开源平台(open-assistant.io),全球13,000+志愿者贡献了60万+条交互、15万条消息,覆盖多样化任务和语言。

- 质量控制:每条对话都经过多轮人类审核,剔除垃圾、毒性或隐私数据,确保数据集“干净”。

- 排行机制:用户对模型回复打分(从最好到最差),生成奖励模型(Reward Model),用于后续优化。

2. 模型训练

- 基础模型:基于现有开源模型(如LLaMA、Pythia、Stable LM),通过微调(fine-tuning)适配对话任务。

- RLHF流程:用人类反馈数据进行强化学习(Reinforcement Learning from Human Feedback),让模型更懂用户意图。

- 高效设计:目标是让模型在单块高性能GPU(如RTX 3090)上运行,降低硬件门槛。

3. 前后端交互

- 前端:React + Next.js 实现的聊天界面(http://localhost:3000),用户可以直接跟模型对话并反馈(点赞/踩)。

- 后端:FastAPI + Python,处理模型推理、数据存储和API调用。

- 数据库:用PostgreSQL存对话数据,向量数据库(计划中)支持检索增强。

4. 推理与扩展

- 推理模块:支持本地推理(见

/inference文件夹),开发者可以用HuggingFace的Transformers加载模型。 - 插件系统:未来计划支持插件,让模型能调用外部工具,比如浏览器、计算器。

整个架构就像一个“社区大脑”,数据靠众人贡献,模型靠开源优化,推理靠灵活部署。

三、核心模块实现逻辑:揭秘“助手大脑”

Open-Assistant 的核心模块可以分为数据、训练和推理三部分,我们用通俗语言讲讲它们的逻辑:

1. 数据收集(Crowdsourcing)

- 逻辑:用户在open-assistant.io提交任务(prompt)或回复,系统随机展示多个回复,供用户打分。高质量回复被标记为“ready_for_export”,进入数据集。

- 实现:前端用React收集用户输入,后端用FastAPI存到PostgreSQL,审核后生成JSON格式的oasst1/oasst2数据集。

- 代码示例:数据集处理脚本(见

/notebooks/openassistant-oasst1):pythonfrom datasets import load_dataset dataset = load_dataset("OpenAssistant/oasst1") print(dataset["train"][0]) # 查看第一条对话

2. RLHF 训练

- 逻辑:先用监督微调(SFT)让模型学会对话,再用奖励模型(基于用户打分)优化,让模型偏向高质量回复。

- 实现:基于PyTorch和Transformers,训练脚本在

/model文件夹。奖励模型用排名数据(最好到最差)训练,优化KL散度。 - 代码示例:伪代码(实际脚本需参考

/model):pythonfrom transformers import AutoModelForCausalLM model = AutoModelForCausalLM.from_pretrained("pythia-12b") # 加载oasst1数据,跑SFT和RLHF

3. 推理系统

- 逻辑:用户输入prompt,模型生成回复,支持流式输出(stream)。推理模块用HuggingFace的pipeline,优化了内存管理。

- 实现:见

/inference文件夹,支持LLaMA、Pythia等模型,开发者可指定GPU或CPU运行。 - 代码示例:

python

from transformers import pipeline pipe = pipeline("text-generation", model="OpenAssistant/oasst-sft") print(pipe("Hello, how can I help you today?"))

4. 前端交互

- 逻辑:用户通过网页聊天,点赞/踩反馈被存回数据库,供后续训练。

- 实现:Next.js前端调用FastAPI后端,异步加载模型回复。

这些模块让 Open-Assistant 既能快速开发,也能持续优化,核心是“数据驱动+社区反馈”。

四、技术栈:Python 开源生态的集大成者

Open-Assistant 的技术栈对Python开发者非常友好,基本是开源AI的“标配”:

- 编程语言:Python(3.8+),JavaScript(前端)。

- 核心框架:PyTorch、HuggingFace Transformers(模型训练/推理)。

- 前端:React、Next.js、TypeScript(聊天界面)。

- 后端:FastAPI、SQLAlchemy(API和数据库交互)。

- 数据库:PostgreSQL(存对话数据)。

- 部署:Docker(一键部署全栈),支持GitHub Codespaces和VSCode devcontainer。

- 其他依赖:pandas(数据处理)、treelib(对话树管理)、celery(异步任务)、NCCL(GPU通信)。

如果你熟悉PyTorch和React,Open-Assistant 的技术栈上手几乎无缝。Docker支持也让部署变得超简单。

五、上手难度:小白能玩吗?

1. 适合人群

Open-Assistant 适合以下开发者:

- 熟悉Python,了解PyTorch或HuggingFace。

- 对LLM或RLHF有基本概念(比如知道啥是微调)。

- 想用开源数据集训练模型,或开发聊天机器人。

完全没接触过AI?可能需要先学点LLM基础(比如看HuggingFace教程),但项目文档和社区很友好,降低了不少门槛。

2. 安装与配置

最简单的部署方式是用Docker:

bash

git clone https://github.com/LAION-AI/Open-Assistant.git

cd Open-Assistant

docker compose --profile ci up --build然后访问 http://localhost:3000,就能看到聊天界面。M1 Mac用户需加参数:

bash

DB_PLATFORM=linux/x86_64 docker compose --profile ci up想跑推理?进入 /inference 文件夹:

bash

pip install -r requirements.txt

python inference.py --model pythia-12b3. 学习曲线

- 简单任务:跑官方示例(比如加载oasst1数据集)只需半天,文档很清晰。

- 进阶任务:训练模型或改前端需要理解RLHF和FastAPI,可能要几天到一周。

- 硬件要求:推理小模型(Pythia-6B)需8GB显存,LLaMA-30B需24GB显存,CPU也能跑(但慢)。

总体难度中等偏低,37.3k+ Star 和活跃的Discord社区(见 open-assistant.io)保证你不会卡太久。

六、与其他项目的对比:Open-Assistant 的独特魅力

开源对话模型不少,比如Vicuna、Alpaca、LlamaIndex,那 Open-Assistant 有啥特别?我们来对比:

| 框架/项目 | 优点 | 缺点 | 适合场景 |

|---|---|---|---|

| Open-Assistant | 完全开源,数据集伦理干净,RLHF流程透明,支持多语言,社区活跃 | 项目已“完成”,后续开发有限,大模型推理需高性能GPU | 研究、DIY聊天机器人、数据集开发 |

| Vicuna | 性能接近ChatGPT,13B模型效果好,推理效率高 | 数据集来源不清(含ShareGPT),商业用途受限 | 个人项目、快速部署 |

| Alpaca | 简单易用,适合微调实验,学术友好 | 数据集较小,模型能力有限,官方支持减少 | 学术研究、入门级AI开发 |

| LlamaIndex | 专注RAG,文档检索强,易集成 | 非对话模型,功能单一,需额外模型支持对话 | 知识库、检索增强应用 |

Open-Assistant 的优势:

- 伦理数据集:oasst1/oasst2 数据集100%人类贡献,无版权争议,适合商业和研究。

- 透明流程:RLHF pipeline全公开,开发者能学到完整训练逻辑。

- 多语言支持:35种语言覆盖,适合全球开发者。

- 社区驱动:37k+ Star,Discord和GitHub讨论热烈,文档丰富。

不足:项目已结束活跃开发(2023年10月),新功能靠社区接手;大模型推理对硬件要求较高。

七、总结

Open-Assistant 就像一个“开源的AI实验室”,用透明的RLHF流程、干净的数据集和灵活的代码,降低了对话AI的开发门槛。它的技术架构清晰,模块化设计让开发者能快速上手;技术栈贴合Python生态,学习成本低;社区支持和详细文档(见 /docs)让新手也能玩转。

虽然项目已“完成”,但它的遗产——oasst2数据集和训练模板——依然是研究者和开发者的宝藏。如果你想训练一个多语言聊天模型,或者探索RLHF的奥秘,Open-Assistant 是绝佳起点。去GitHub点个Star,跑跑示例代码,未来助手的蓝图或许就从你手中开始!

参考资料:

- Open-Assistant 官方 GitHub 仓库:https://github.com/LAION-AI/Open-Assistant

- oasst2 数据集:https://huggingface.co/datasets/OpenAssistant/oasst2

- LAION-AI 官网:https://laion.ai

- 社区讨论:https://open-assistant.io 和 Discord 频道

AutoGPT:让AI帮你“自动搞定一切”的开源神器

2025年04月11日

LLaMA-Factory:一键微调百种大模型的开源利器

2025年04月13日

LLMs-from-Scratch:从零打造ChatGPT的开源教科书

2025年04月13日

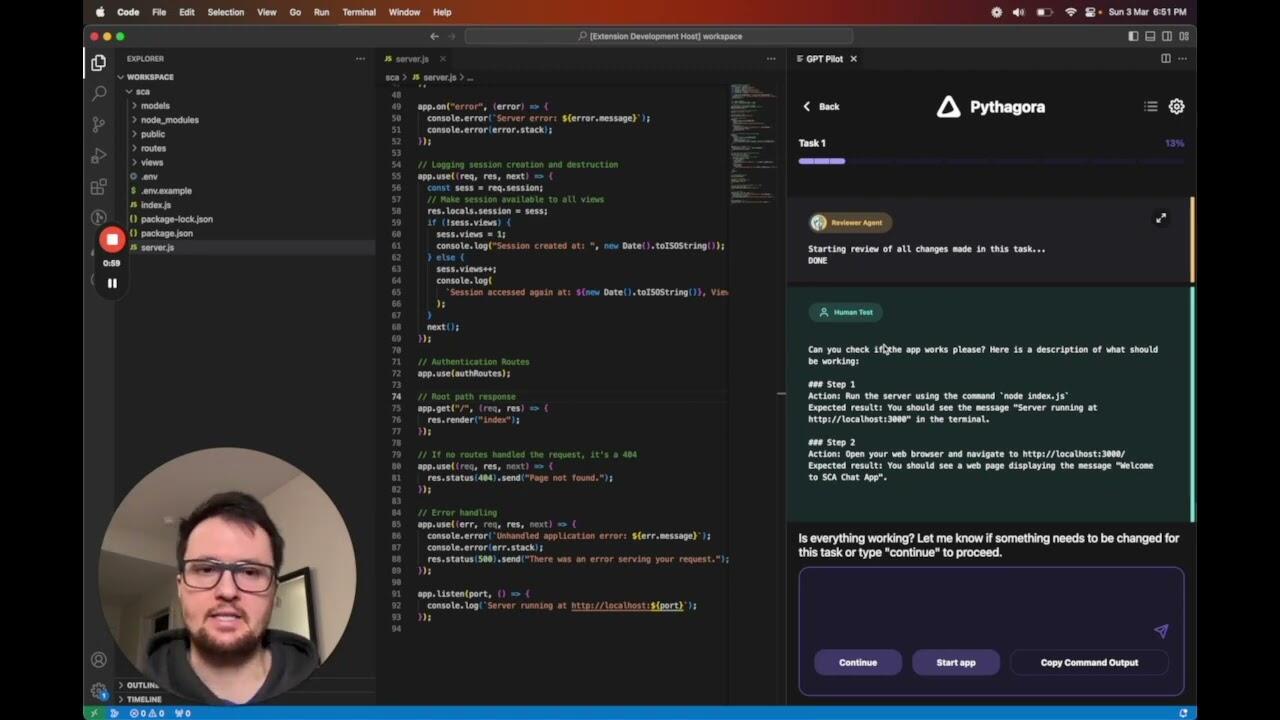

GPT-Pilot:你的AI编程助手,带你从零打造应用!

2025年04月19日

LocalAI:你的本地AI神器,轻松打造专属智能应用!

2025年04月19日

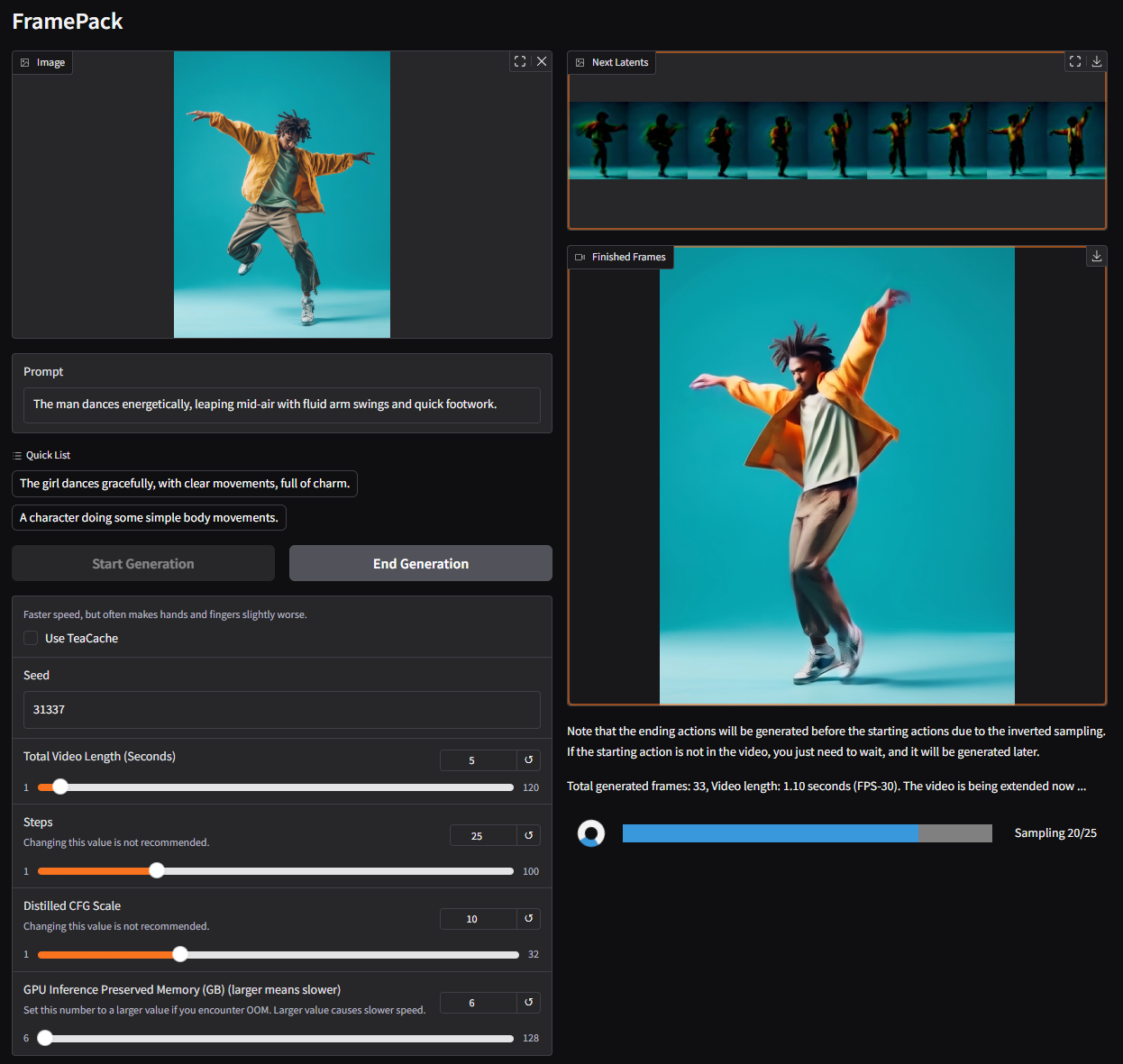

FramePack:让视频生成像玩游戏一样简单!

2025年04月20日

MCPO:让 AI 工具秒变 RESTful API 的“魔法桥梁”!

2025年04月20日

GigaTok:扩展视觉标记器至 30 亿参数用于自回归图像生成

2025年04月20日

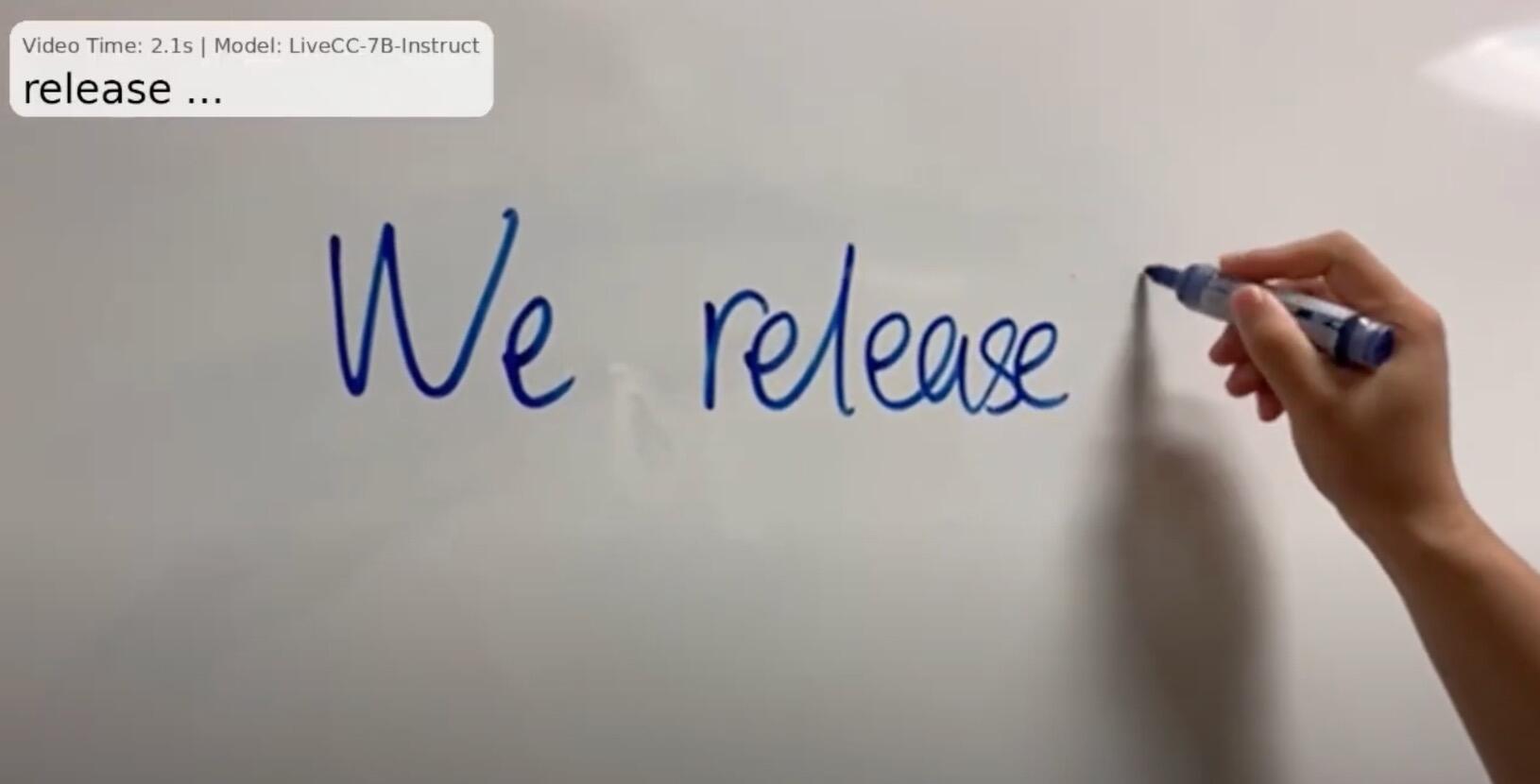

大模型的新突破:LiveCC 让“直播 AI 解说”成为现实

2025年04月25日