AigcPanel:一站式开源AI数字人系统,带你轻松玩转视频与语音合成

AigcPanel:一站式AI数字人系统,带你轻松玩转视频与语音合成

如果你曾梦想过打造一个能“开口说话”的数字人,或者想让视频中的人物“听你指挥”,那今天要介绍的这个开源项目——AigcPanel,绝对值得你一探究竟!它的 GitHub 仓库地址是 https://github.com/modstart-lib/aigcpanel,一个简单易用、功能强大的 AI 数字人系统,号称“小白也能上手”。下面,我将从功能、技术栈、核心实现、搭建难度以及与其他项目的对比等方面,带你全面了解这个项目,文章风格轻松,适合有一定编程基础但刚接触这个项目的朋友。

一、AigcPanel 能做什么?功能与应用场景

AigcPanel 是一个一站式 AI 数字人系统,核心目标是让用户轻松创建虚拟数字人,支持视频合成、语音合成和语音克隆三大功能。简单来说,它能让你的数字人“动起来、说出来”,还能模仿特定声音,简直是内容创作者、开发者甚至普通爱好者的“梦幻工具”。

主要功能

- 视频数字人合成:

- 支持将音频与视频画面结合,实现“对口型”效果(lip-sync),让数字人说话时嘴型与声音完美同步。

- 适用场景:短视频制作、虚拟主播、广告宣传视频等。

- 语音合成(TTS):

- 将文本转化为自然语音,支持多种音色和参数调整(如语速、音调)。

- 适用场景:有声书生成、客服语音、游戏角色配音等。

- 语音克隆:

- 通过少量音频样本,模仿特定人物的声音,生成高度相似的语音。

- 适用场景:个性化语音定制、影视后期配音、虚拟偶像声音设计等。

- 模型管理:

- 提供一键导入和启动 AI 模型,简化本地模型管理,支持多模型切换和日志查看。

- 适用场景:AI 开发者测试模型、快速部署数字人相关功能。

应用场景

- 内容创作:UP 主、短视频创作者可以用它快速生成虚拟主播视频,省去真人出镜的麻烦。

- 教育与培训:制作虚拟讲师,为课程配上逼真的语音和画面。

- 游戏与娱乐:为游戏角色生成个性化语音,或创建虚拟偶像。

- 商业应用:企业可用于广告、客服机器人或品牌代言人的数字人定制。

一句话总结:AigcPanel 就像一个“数字人制作工厂”,从画面到声音一手包办,适合想快速上手 AI 内容生成的开发者或创作者。

二、技术架构:AigcPanel 是如何搭建的?

AigcPanel 的技术架构可以看作一个“前端展示 + 后端模型管理 + AI 算法支持”的组合。它的设计理念是模块化、可扩展,方便用户快速接入和定制。

整体架构

- 前端界面:

- 基于 Vue.js 构建,提供直观的操作界面,用户可以通过 Web 界面上传音频、视频,调整模型参数,查看生成结果。

- 界面风格简洁,交互友好,适合新手。

- 后端服务:

- 使用 TypeScript 和 Node.js 搭建,负责处理模型调用、文件管理、端口分配等逻辑。

- 通过标准输入输出(stdin/stdout)与 AI 模型交互,降低了模型接入的复杂度。

- AI 模型层:

- 集成了多种开源 AI 模型,如 Wav2Lip(用于唇部同步)、CosyVoice(语音合成)、MuseTalk(视频生成)。

- 支持本地模型管理,用户可以导入自己的模型(如 config.json 和相关文件)。

- 运行环境:

- 依赖 Python 环境(打包为

_aienv目录)运行 AI 模型。 - 支持 Windows、Linux 和 macOS,兼容 x86 和 arm64 架构。

- 依赖 Python 环境(打包为

核心模块实现逻辑

AigcPanel 的核心在于模型管理和任务处理,以下是几个关键模块的实现逻辑:

- 模型导入与启动:

-

用户通过上传

config.json文件导入模型,配置文件包含模型名称、版本、支持功能(如videoGen、soundTTS)、运行参数等。 -

后端通过 Node.js 的

server.js解析配置文件,动态分配端口,启动 Python 脚本(如run.py)运行模型。 -

模型运行后,通过标准输入输出传递参数和结果,例如:

pythonimport json, base64 config = json.loads(open(sys.argv[1], 'r').read()) def printResult(key, value): print(f'AigcPanelRunResult[{config['id']}][' + base64.b64encode(json.dumps({key: value}).encode()).decode()+']') printResult('url', '/path/to/result.wav') # 输出语音合成结果 -

这种设计让模型与系统的耦合度低,易于扩展。

-

- 视频与语音合成:

- 视频合成依赖 Wav2Lip 等模型,输入音频和视频后,模型分析音频波形,调整视频中人物的唇部动作。

- 语音合成和克隆则通过 CosyVoice 等模型,将文本或音频样本转化为目标语音。

- 输出结果(如

.wav或.mp4文件)通过 URL 返回前端展示。

- 日志与错误处理:

- 系统记录模型运行日志,支持异常捕获和工单提交,便于调试。

- 优化了非英文路径检测、版本号对比等细节,提升稳定性。

三、使用的技术栈

AigcPanel 的技术栈非常现代化,既适合前端开发者,也对 AI 算法工程师友好。以下是主要技术:

- 前端:

- Vue.js:构建交互式用户界面。

- TypeScript:增强代码可维护性,配置文件如

tsconfig.json表明项目使用 ESNext 标准。

- 后端:

- Node.js:处理模型调用和文件管理。

- TypeScript:后端代码同样使用 TS,提升开发效率。

- AI 模型:

- Python:运行核心 AI 模型,依赖打包的 Python 环境。

- Wav2Lip:实现唇部同步。

- CosyVoice:支持语音合成与克隆。

- MuseTalk:增强视频生成能力。

- 构建与部署:

- Electron:支持跨平台桌面应用(配置文件如

.npmrc和entitlements.mac.plist表明对 macOS 的优化)。 - GitHub Actions:自动化打包和发布(如 v0.3.0 版本支持 macOS 视频合成)。

- Electron:支持跨平台桌面应用(配置文件如

- 其他依赖:

- FFmpeg:处理音视频文件(AUR 包中有相关依赖)。

- GTK3:可能用于 Linux 平台的界面渲染。

四、上手难度:小白真的能玩转吗?

AigcPanel 的宣传口号是“小白也能用”,但实际难度如何?我们从环境搭建和使用体验两个方面来看:

环境搭建

- 步骤:

- 克隆仓库:

git clone https://github.com/modstart-lib/aigcpanel.git。 - 安装 Node.js 和 Python 环境。

- 配置 Python 虚拟环境(

_aienv),安装依赖(如 Wav2Lip、CosyVoice)。 - 运行

npm install安装前端依赖,启动项目。 - 导入模型(config.json),通过界面操作。

- 克隆仓库:

- 难点:

- Python 环境配置:需要手动打包

_aienv,对 Python 依赖管理不熟悉的用户可能遇到版本冲突。 - 模型下载:Wav2Lip 等模型文件较大,需自行下载并配置路径。

- 硬件要求:支持 CUDA 加速,但无 GPU 的设备可能运行较慢。

- Python 环境配置:需要手动打包

- 建议:

- 参考官方文档或社区教程,优先使用支持 CUDA 的设备。

- Linux 用户可参考 AUR 包(

aigcpanel-git)简化安装。

使用体验

- 界面友好:Vue 打造的 Web 界面直观,上传文件、调整参数一目了然。

- 学习曲线:熟悉 JSON 配置和基本 Python 脚本的用户,1-2 小时即可上手;完全新手可能需要 1 天学习环境搭建。

- 社区支持:GitHub 上有 1.8k+ 星,活跃度较高,issue 区和 release 说明(如 v0.3.0)提供了不少帮助。

总结:对有 Node.js 或 Python 基础的开发者,上手难度中等偏低;对纯小白,建议花半天时间学习环境配置,之后操作就很顺手了。

五、与其他项目的对比

AigcPanel 并不是唯一的数字人系统,我们来看看它与类似项目的优劣对比:

- Wav2Lip(独立项目)

- 功能:专注于唇部同步,功能单一但效果出色。

- 技术栈:纯 Python,依赖 PyTorch。

- 上手难度:较高,需要手动配置模型和脚本。

- 与 AigcPanel 对比:AigcPanel 集成了 Wav2Lip 并提供 UI 和模型管理,适合不想折腾代码的用户。

- Stable Diffusion WebUI

- 功能:偏向图像生成,支持部分视频生成,但语音功能较弱。

- 技术栈:Python + Gradio 界面。

- 上手难度:中等,模型配置复杂。

- 与 AigcPanel 对比:AigcPanel 更专注于数字人生成,音视频结合更完整,界面更友好。

- SadTalker

- 功能:专注于音频驱动的头像动画,视频生成能力强。

- 技术栈:Python + PyTorch。

- 上手难度:较高,需手动运行脚本。

- 与 AigcPanel 对比:AigcPanel 功能更全面(语音 + 视频),上手更简单。

AigcPanel 的优势:

- 一站式体验,集成了多种模型,省去单独配置的麻烦。

- 跨平台支持(Windows/Linux/macOS),社区活跃。

- 提供 Web 界面,降低使用门槛。

不足:

- 对硬件要求较高(GPU 加速更佳)。

- 模型生态不如 Stable Diffusion 丰富。

六、总结:为什么选择 AigcPanel?

AigcPanel 是一个“上手快、功能全”的开源 AI 数字人系统,无论是想快速生成虚拟主播视频,还是为游戏角色定制语音,它都能胜任。它的技术栈现代化(Vue + Node.js + Python),核心模块设计灵活,适合开发者二次开发。虽然环境搭建对小白略有挑战,但官方文档和社区支持能帮你快速入门。

如果你是内容创作者、AI 爱好者或开发者,不妨试试 AigcPanel!克隆仓库,跑起来一个数字人项目,说不定你的下一个爆款视频就诞生于此!😄

参考资料:

AutoGPT:让AI帮你“自动搞定一切”的开源神器

2025年04月11日

GPT-Pilot:你的AI编程助手,带你从零打造应用!

2025年04月19日

LocalAI:你的本地AI神器,轻松打造专属智能应用!

2025年04月19日

FramePack:让视频生成像玩游戏一样简单!

2025年04月20日

MCPO:让 AI 工具秒变 RESTful API 的“魔法桥梁”!

2025年04月20日

GigaTok:扩展视觉标记器至 30 亿参数用于自回归图像生成

2025年04月20日

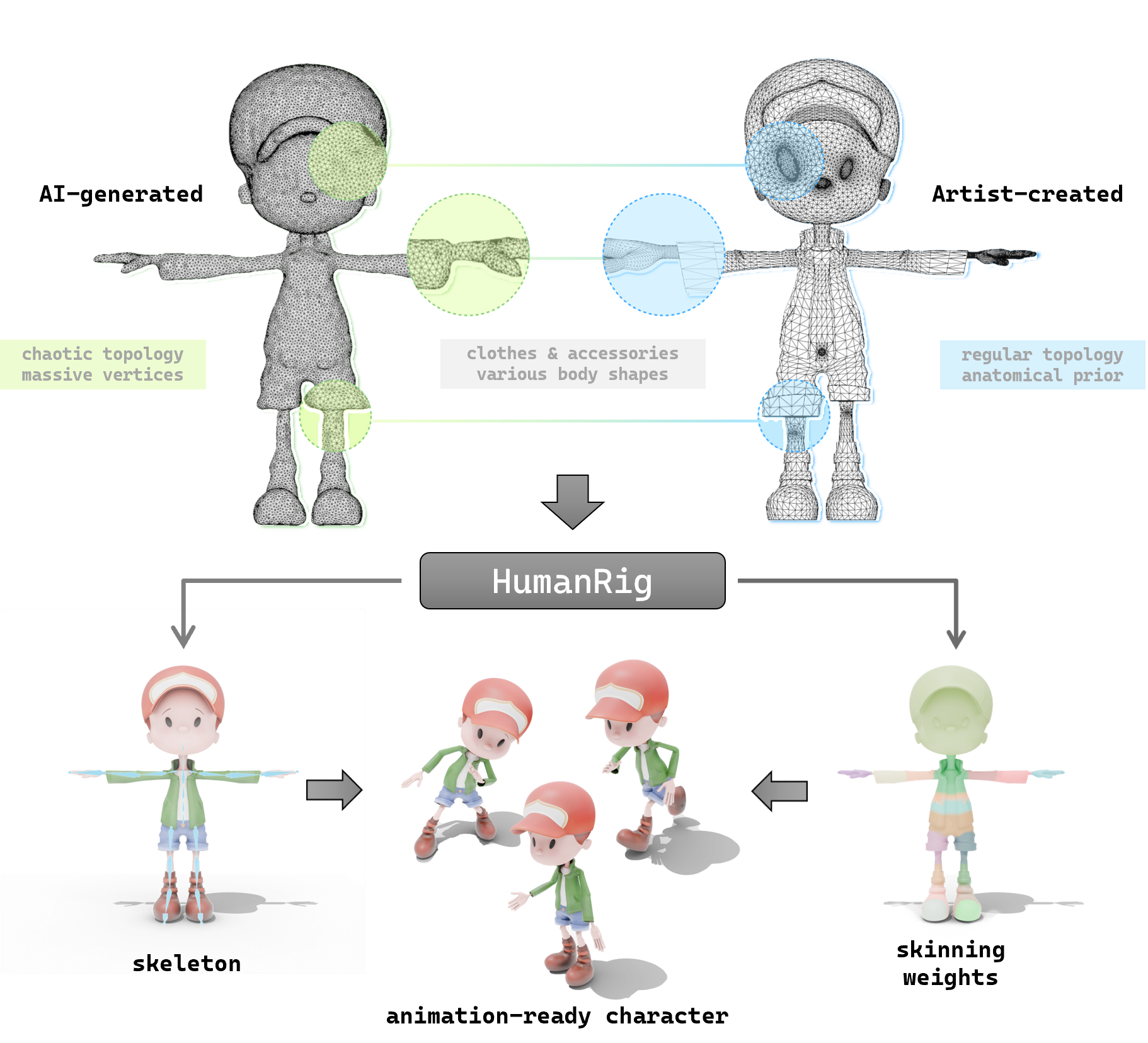

探索 HumanRig:让 3D 角色动画更简单的开源神器

2025年04月20日

探索 so-vits-svc:让你的动漫角色开口唱歌的 AI 神器

2025年04月22日

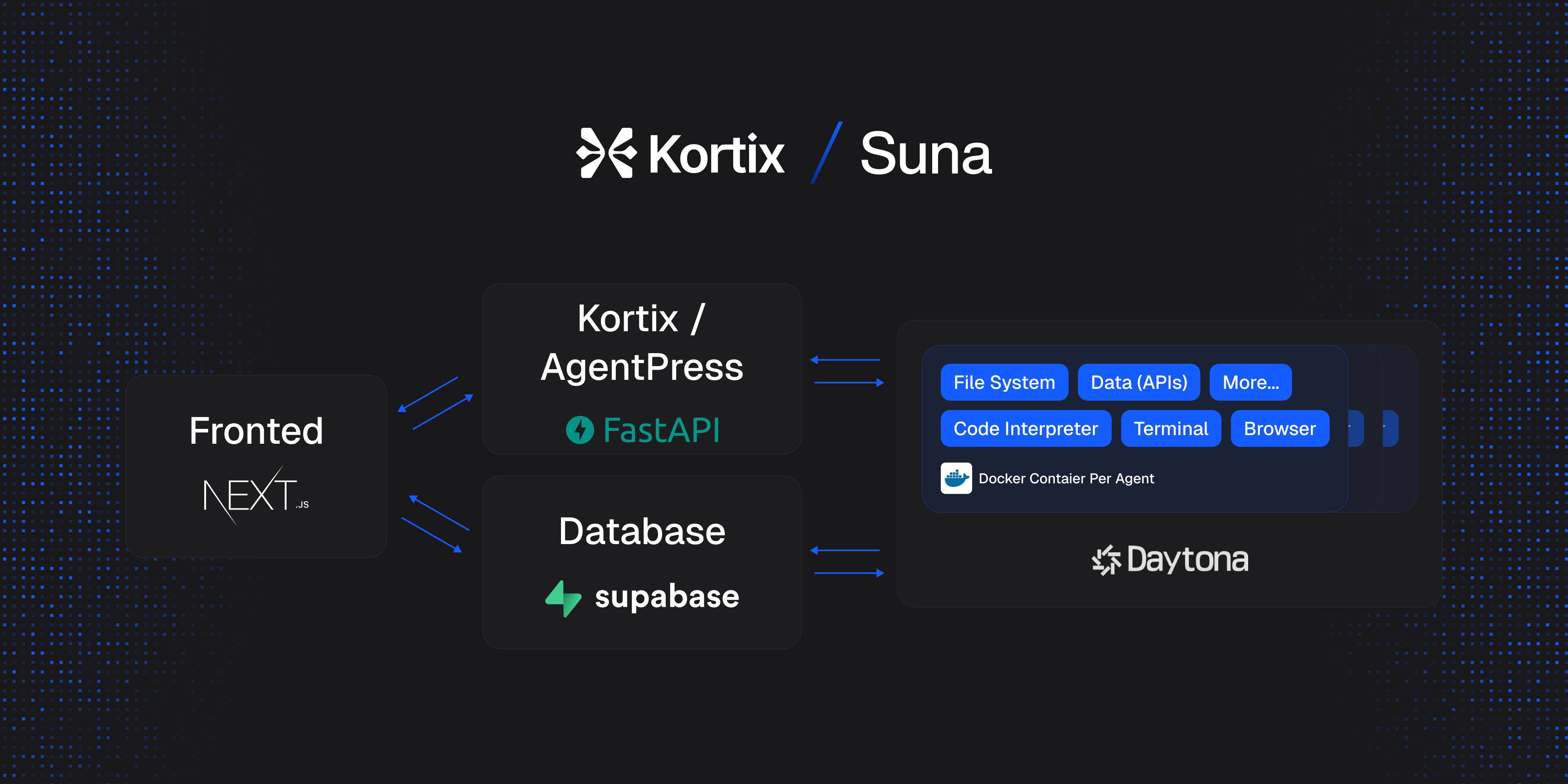

Suna 开源项目介绍:通用 AI 代理的轻松上手指南

2025年04月23日

让 AI 更懂你的网站:一文读懂 llms-txt 开源项目

2025年04月24日