Deep-Live-Cam:仅凭一张照片,即可体验实时换脸与视频深度伪造的乐趣

1. 引言:踏入 Deep-Live-Cam 的实时换脸世界

想象一下,仅需一张照片,你就能在视频通话中变成任何人,或者将自己的脸庞融入经典电影的场景之中。Deep-Live-Cam 正是这样一款令人兴奋的开源项目,它通过先进的人工智能技术,让实时换脸和一键式视频深度伪造变得触手可及 。这个项目在 GitHub 上引起了广泛关注,其核心魅力在于操作的简便性以及所能实现的惊艳效果。

本文旨在为那些具备一定编程基础,但尚未接触过 Deep-Live-Cam 的朋友们提供一份详尽而易懂的入门指南。我们将一起探索 Deep-Live-Cam 的功能特点、技术架构、核心实现逻辑、所使用的技术栈,并评估其上手难度。通过本文,你将能够对 Deep-Live-Cam 有一个全面的了解,并掌握开始体验这项有趣技术的必要知识。项目的核心亮点在于其宣称的“仅凭一张照片”即可完成实时换脸和视频深度伪造,这与其他需要大量训练数据的深度伪造方法形成了鲜明对比,暗示着用户可以更轻松地入门并快速体验到成果 。

2. 功能潜力:Deep-Live-Cam 的特性与应用场景探索

Deep-Live-Cam 的核心功能在于其能够实时地将一张源脸替换到目标视频或实时摄像头画面中的人脸上,并且声称只需点击一下即可完成视频的深度伪造 。这种实时性和易用性为各种有趣的应用场景打开了大门。

2.1 核心功能亮点

- 实时换脸: Deep-Live-Cam 最引人注目的特性就是其能够进行实时的面部替换,这意味着用户可以在视频通话、直播等场景中即时看到换脸效果 。

- 一键式视频深度伪造: 除了实时换脸,该项目还支持通过简单的操作,将源脸替换到目标视频中,生成深度伪造视频 。

- 口部遮罩 (Mouth Mask): 为了提升换脸的真实感,Deep-Live-Cam 提供了保留原始视频中人物嘴部的选项,从而确保更自然的唇部动作,避免换脸视频中常见的“恐怖谷”效应 。这个细节上的处理体现了开发者对输出质量的重视。

- 面部映射 (Face Mapping): 该项目还支持在同一视频帧中将不同的源脸映射到多个目标人物的脸上 。这项功能极大地拓展了其应用范围,例如,可以在一段多人视频中,将每个人的脸都替换成不同的预设人脸,创造出极具娱乐性的效果。

- “你的电影,你的脸”: Deep-Live-Cam 允许用户实时观看电影,并将自己或任何选定的人脸叠加到电影主角的脸上 。这提供了一种全新的互动娱乐方式,让用户以前所未有的方式沉浸在电影的世界中。

- 直播表演 (Live Show): 该项目的功能也适用于直播场景,表演者可以利用实时换脸技术创造出独特的视觉效果,增强节目的趣味性和吸引力 。

- 表情包制作 (Memes): Deep-Live-Cam 也可以用于制作各种有趣的表情包,用户可以将自己的脸或者其他人的脸融入到热门表情包的模板中,快速生成引人注目的内容 。

- Omegle 互动: 项目的 README 文件中提到了在 Omegle 这样的在线视频聊天平台上的应用,用户可以使用 Deep-Live-Cam 提供的实时换脸功能给陌生人带来惊喜 。虽然这种应用可能涉及一些伦理问题,但也侧面反映了该项目实时换脸功能的实用性。

为了更直观地了解 Deep-Live-Cam 的强大功能,建议读者可以查看项目 README 文件中提供的演示 GIF 动画 。通过动态的画面展示,用户可以更快速地理解该软件的实际效果。这些功能共同使得 Deep-Live-Cam 成为一个在娱乐、内容创作乃至某些特定专业领域都具有潜力的工具。

3. 技术解析:Deep-Live-Cam 的幕后功臣

要理解 Deep-Live-Cam 的工作原理,我们需要对其背后的技术栈进行一番探究。

3.1 主要编程语言

Deep-Live-Cam 的主要编程语言是 Python,这从 GitHub 仓库的语言统计信息中可以清晰地看到,Python 代码占比高达 99.9% 。选择 Python 作为主要开发语言,一方面是因为 Python 在数据科学和人工智能领域拥有丰富的库和框架,另一方面也降低了项目的开发门槛,方便更多开发者参与贡献。

3.2 核心库与框架

- PyTorch: 从项目的

requirements.txt文件中可以看到torch依赖 ,这表明 Deep-Live-Cam 很可能使用了 PyTorch 这个流行的深度学习框架。PyTorch 提供了强大的张量计算和神经网络构建功能,是训练和运行深度学习模型的关键工具。 - ONNX (Open Neural Network Exchange): 文件中也包含了

onnx依赖以及名为inswapper_128_fp16.onnx的模型文件 。ONNX 是一种开放格式,用于表示深度学习模型,它的使用意味着 Deep-Live-Cam 具备模型可移植性和高效推理的能力,可以在不同的硬件和软件平台上运行。 - InsightFace:

requirements.txt中列出了insightface这个依赖 ,并且项目的 Credits 部分也提到了deepinsight的insightface项目 。InsightFace 是一个专注于人脸识别和分析的开源库,Deep-Live-Cam 很可能利用它来实现人脸检测和特征提取,这是进行面部替换的基础步骤。需要注意的是,项目的 Credits 中明确指出 InsightFace 模型仅限于非商业研究用途 。 - GFPGAN (Generative Facial Prior-Guided GAN): 项目仓库中包含名为

GFPGANv1.4.pth的模型文件,并且在安装说明中也提到了需要下载 GFPGAN 模型 。GFPGAN 是一种先进的人脸修复算法,能够提升生成的人脸图像的质量和真实感。Deep-Live-Cam 使用 GFPGAN 很可能是为了优化换脸后的面部细节,减少伪影,使其看起来更加自然。 - OpenCV (cv2):

requirements.txt中包含了opencv-python这个依赖 。OpenCV 是一个广泛使用的计算机视觉库,提供了丰富的图像和视频处理功能。Deep-Live-Cam 可能会使用 OpenCV 来处理视频帧、读取图像以及进行一些基本的图像操作。 - FFmpeg: 在项目的安装说明中,FFmpeg 被列为必备的工具之一 。FFmpeg 是一套强大的多媒体处理工具,可以用于录制、转换和流式传输音频及视频。Deep-Live-Cam 使用 FFmpeg 很可能是为了处理视频文件的输入和输出,包括读取视频帧、编码生成新的视频文件等。

3.3 高级架构推测

基于以上技术栈的分析,我们可以对 Deep-Live-Cam 的工作流程进行一个大致的推测:

- 输入: 系统接收来自图像、视频文件或实时摄像头的输入数据。

- 人脸检测: 使用 InsightFace 等库对输入数据中的人脸进行检测和定位 。

- 人脸替换: 利用深度学习模型(很可能基于 Credits 中提及的

s0md3v/roop项目 )将检测到的目标人脸替换为用户提供的源脸。ONNX 可能在此过程中发挥作用,确保模型的跨平台运行和高效推理。 - 人脸增强: 应用 GFPGAN 模型对替换后的人脸进行优化和修复,提升其视觉质量和真实感 。

- 输出: 生成包含替换后人脸的图像或视频,或者将实时换脸效果显示在摄像头画面中。

预训练的 AI 模型(如 GFPGANv1.4 和 inswapper_128_fp16.onnx)被存储在项目仓库的 models 目录下 。这些模型是实现人脸替换和增强功能的核心组件。

4. 动手实践:Deep-Live-Cam 的安装过程与难度评估

Deep-Live-Cam 提供了两种主要的安装方式:预构建版本和手动安装。这两种方式分别面向不同技术水平的用户 。

4.1 简易之路:预构建版本 (Windows)

对于 Windows 用户,尤其是那些不熟悉命令行操作或不希望手动安装各种依赖项的用户,Deep-Live-Cam 提供了一个预构建的版本 。这个版本特别针对配备独立 NVIDIA 或 AMD 显卡的用户,号称是开始体验 Deep-Live-Cam 最快速的方式,无需手动安装或下载任何额外的组件 。值得注意的是,预构建版本的功能可能会比开源版本提前 60 天发布,这意味着用户可以更早地体验到一些新特性 。对于非技术用户或者只是想快速体验一下 Deep-Live-Cam 功能的用户来说,预构建版本无疑是一个非常友好的选择。

4.2 自主探索:手动安装 (全平台)

对于希望更深入了解 Deep-Live-Cam 的技术细节或者在非 Windows 平台上运行的用户,可以选择手动安装的方式。但项目 README 文件明确警告,手动安装需要一定的技术基础,并不适合初学者,建议新手优先考虑预构建版本 。

4.2.1 准备工作:平台环境配置

手动安装的第一步是配置必要的平台环境 。这包括:

- Python: 强烈推荐使用 Python 3.10 版本。多个用户反馈表明,更新的版本(如 3.12)可能会导致兼容性问题 。

- pip: Python 的包管理工具,用于安装项目所需的各种依赖库。建议保持 pip 为最新版本。

- git: 版本控制系统,用于从 GitHub 克隆 Deep-Live-Cam 的代码仓库。

- ffmpeg: 用于处理视频和音频文件的工具。Windows 用户可能还需要安装(https://visualstudio.microsoft.com/visual-cpp-build-tools/) 。FFmpeg 的安装可以参考其官方网站 https://www.ffmpeg.org/download.html 或相关的教程视频 。

- macOS 用户: 可能还需要安装或升级

python-tk包,可以使用命令brew install python-tk@3.10。

4.2.2 克隆代码仓库

在配置好基础环境后,需要使用 git clone https://github.com/hacksider/Deep-Live-Cam.git 命令将 Deep-Live-Cam 的代码仓库克隆到本地 。

4.2.3 下载模型文件

接下来,需要从 Hugging Face 下载预训练的模型文件 GFPGANv1.4 (https://huggingface.co/hacksider/deep-live-cam/resolve/main/GFPGANv1.4.pth) 和 inswapper_128_fp16.onnx (https://huggingface.co/hacksider/deep-live-cam/resolve/main/inswapper_128_fp16.onnx),并将它们放置到克隆下来的 Deep-Live-Cam 目录下的 models 文件夹中 。

4.2.4 安装依赖项

强烈建议使用虚拟环境 (venv) 来安装项目的依赖项,以避免与其他 Python 项目的包产生冲突 。创建和激活虚拟环境的步骤如下:

- 在命令行中导航到克隆下来的

Deep-Live-Cam目录。 - 创建虚拟环境:在 Windows 上运行

python -m venv venv,在 Linux 或 macOS 上运行python3 -m venv venv. - 激活虚拟环境:在 Windows 上运行

venv\Scripts\activate,在 Linux 或 macOS 上运行source venv/bin/activate. 激活后,命令行提示符前会显示(venv)。 - 安装依赖项:在激活的虚拟环境中运行

pip install -r requirements.txt命令 。这个命令会自动安装requirements.txt文件中列出的所有必要的 Python 包,例如torch、torchvision、onnx、insightface和opencv-python等 。

如果在安装过程中遇到问题,可以尝试重新激活甚至重新创建虚拟环境 。

4.2.5 在 CPU 上运行

如果没有可用的 GPU,可以使用命令 python run.py 在 CPU 上运行 Deep-Live-Cam 。需要注意的是,首次运行时会下载额外的模型文件(约 300MB),并且在 CPU 上运行速度会比较慢 。

4.2.6 GPU 加速 (可选)

如果你的计算机配备了 NVIDIA、AMD (通过 DirectML)、Apple Silicon 或 Intel 的 GPU,可以按照 README 文件中的说明进行配置,以获得更快的处理速度 。

表 1:GPU 加速选项和特定安装命令

| GPU 厂商/平台 | 主要依赖 & 安装命令 | 运行命令 |

|---|---|---|

| Nvidia (CUDA) | CUDA Toolkit 11.8.0 (下载链接), pip uninstall onnxruntime onnxruntime-gpu, pip install onnxruntime-gpu==1.16.3 |

python run.py --execution-provider cuda |

| Apple Silicon (CoreML) | Python 3.10, pip uninstall onnxruntime onnxruntime-silicon, pip install onnxruntime-silicon==1.13.1 |

python3.10 run.py --execution-provider coreml |

| Windows (DirectML) | pip uninstall onnxruntime onnxruntime-directml, pip install onnxruntime-directml==1.15.0 (或 1.15.1) |

python run.py --execution-provider directml |

| Intel (OpenVINO) | pip uninstall onnxruntime onnxruntime-openvino, pip install onnxruntime-openvino==1.15.0 |

python run.py --execution-provider openvino |

表 2:手动安装系统需求

| 需求 | 详细信息/链接 |

|---|---|

| Python | 3.10 (强烈推荐) |

| pip | 最新版本 |

| git | 最新稳定版本 |

| ffmpeg | 下载链接 |

| Visual Studio 2022 Runtimes | Windows 用户需要,下载链接 |

4.2.7 安装难度评估

综合来看,Deep-Live-Cam 的手动安装过程对于不熟悉 Python 环境、包管理和命令行操作的用户来说,具有一定的挑战性。需要仔细按照步骤操作,并注意不同平台和 GPU 类型的特定要求。然而,预构建版本的出现极大地降低了 Windows 用户的入门门槛。

5. 初试锋芒:Deep-Live-Cam 的基本使用方法

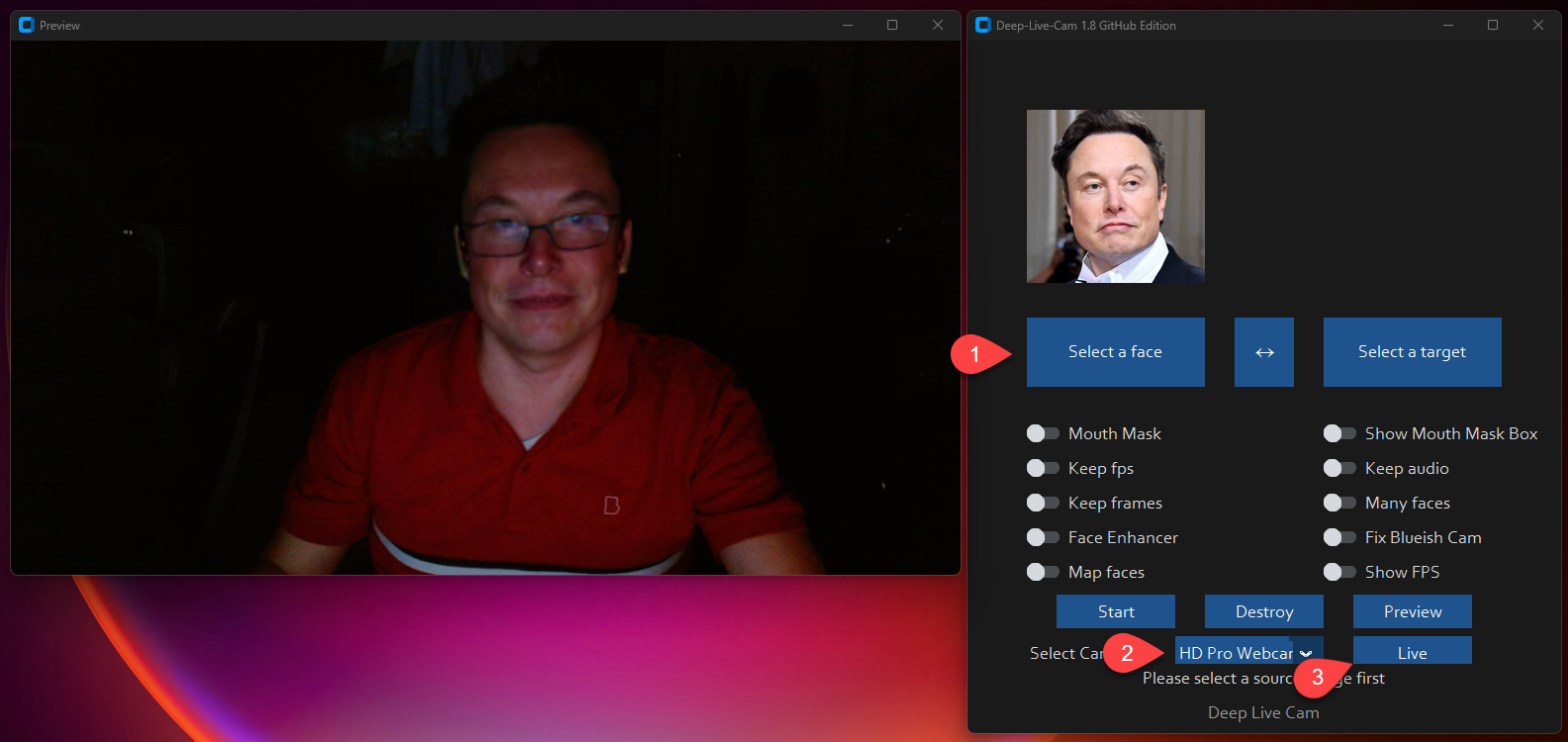

成功安装 Deep-Live-Cam 后,就可以开始体验其强大的功能了。主要有两种使用模式:图像/视频模式和摄像头模式 。

5.1 图像/视频模式

- 在命令行中导航到

Deep-Live-Cam目录,并确保虚拟环境已激活。 - 运行命令

python run.py. - 在弹出的图形界面中,选择一个包含清晰人脸的图像作为源脸(Source Face Image),然后选择需要进行换脸的目标图像或视频(Target Image/Video)。

- 点击“Start”按钮,开始处理 。

- 处理完成后,输出的图像或视频会保存在一个以目标视频文件名命名的文件夹中 。

5.2 摄像头模式

- 同样,在命令行中导航到

Deep-Live-Cam目录,并确保虚拟环境已激活。 - 运行命令

python run.py. - 在弹出的图形界面中,选择一个包含清晰人脸的图像作为源脸 。

- 点击“Live”按钮,启动实时换脸功能 。

- 等待片刻(可能需要 10-30 秒)预览画面出现,这期间模型正在加载 。

- 要将此功能应用于视频通话或直播,需要使用 OBS Studio (下载链接) 等屏幕捕获工具,将 Deep-Live-Cam 的预览窗口设置为虚拟摄像头源 。

- 如果需要更换实时换脸所使用的源脸,只需选择一个新的图像即可 。

总的来说,在成功完成安装后,Deep-Live-Cam 的使用流程还是比较直观的:选择一张脸,选择一个目标(图像/视频)或激活摄像头,然后点击开始 。

6. 初步印象与对比

一旦克服了可能具有挑战性的安装过程,Deep-Live-Cam 在使用上显得相对友好,正如其“三击”即可实现实时深度伪造的宣传语以及各种演示视频所展示的那样 。然而,Deep-Live-Cam 的性能很大程度上取决于用户的硬件配置。正如用户体验所反映的,强烈建议使用具有强大计算能力的独立显卡进行 GPU 加速,以获得流畅的实时处理体验,而在 CPU 上运行则可能会非常缓慢 。

市面上存在其他一些深度伪造工具,例如 FaceFun、BestFaceSwap.ai 和 DeepFacer 。根据 Deep-Live-Cam 的 README 文件和我们目前的研究,该项目似乎更侧重于实时摄像头集成以及仅使用单张输入图像的简易性。这种对易用性和实时应用的强调,可能是 Deep-Live-Cam 相对于其他可能需要更多训练数据或提供不同功能的工具的主要区别。当然,要进行更深入的比较,还需要对这些替代项目进行更详细的分析,包括它们各自的特性和技术要求。Deep-Live-Cam 专注于实时性能和单张图像输入,使其在众多深度伪造解决方案中独树一帜。

7. 重要提示:道德使用与责任

Deep-Live-Cam 的 README 文件中明确强调了道德使用的问题,并提出了严格的使用声明 。所有用户在使用该软件时都应认真阅读并遵守以下重要的道德准则:

- 获取同意: 如果使用真实人物的面部进行深度伪造,必须事先获得其明确的同意 。

- 明确标注: 在线分享任何使用 Deep-Live-Cam 生成的深度伪造内容时,务必清晰地标注其为“深度伪造”,以避免造成误导 。

- 合法合规: 使用该软件时,必须遵守所有相关的法律法规和道德准则 。

- 内容限制: Deep-Live-Cam 内置了内容检查机制,以防止处理不当的媒体内容,例如裸露、暴力或敏感材料 。

- 用户责任: 开发者明确声明不对最终用户的使用行为负责。用户必须确保其使用该软件的方式符合道德标准和法律要求 。

- 法律约束: 项目开发者保留在法律要求下关闭项目或在输出内容中添加水印的权利 。

用户一旦使用 Deep-Live-Cam,即表示同意以上所有条款和条件 。鉴于深度伪造技术的强大能力及其潜在的社会影响,以负责任和合乎道德的方式使用这类工具至关重要,以防止其被滥用并造成不必要的伤害。

8. 总结:你的实时面部操控之旅由此开启

总而言之,Deep-Live-Cam 是一款功能强大的开源工具,它将实时换脸和视频深度伪造技术带到了普通用户的面前。Windows 用户可以通过预构建版本快速体验其魅力,而对于具备一定技术基础的用户,手动安装则能带来更深入的探索。尽管安装过程可能存在一些挑战,但一旦成功配置,Deep-Live-Cam 的使用还是相对简单的。

如果你对人工智能驱动的媒体操控技术充满好奇,并具备一定的编程基础,不妨尝试一下 Deep-Live-Cam。特别是对于 Windows 用户,预构建版本提供了一个便捷的入门途径。最后,再次强调以负责任和合乎道德的方式使用这项技术的重要性。

如果你有兴趣更深入地了解 Deep-Live-Cam 项目,可以访问其 GitHub 仓库 (https://github.com/hacksider/Deep-Live-Cam),获取最新的信息、详细的文档以及参与项目贡献的指南。

AutoGPT:让AI帮你“自动搞定一切”的开源神器

2025年04月11日

GPT-Pilot:你的AI编程助手,带你从零打造应用!

2025年04月19日

LocalAI:你的本地AI神器,轻松打造专属智能应用!

2025年04月19日

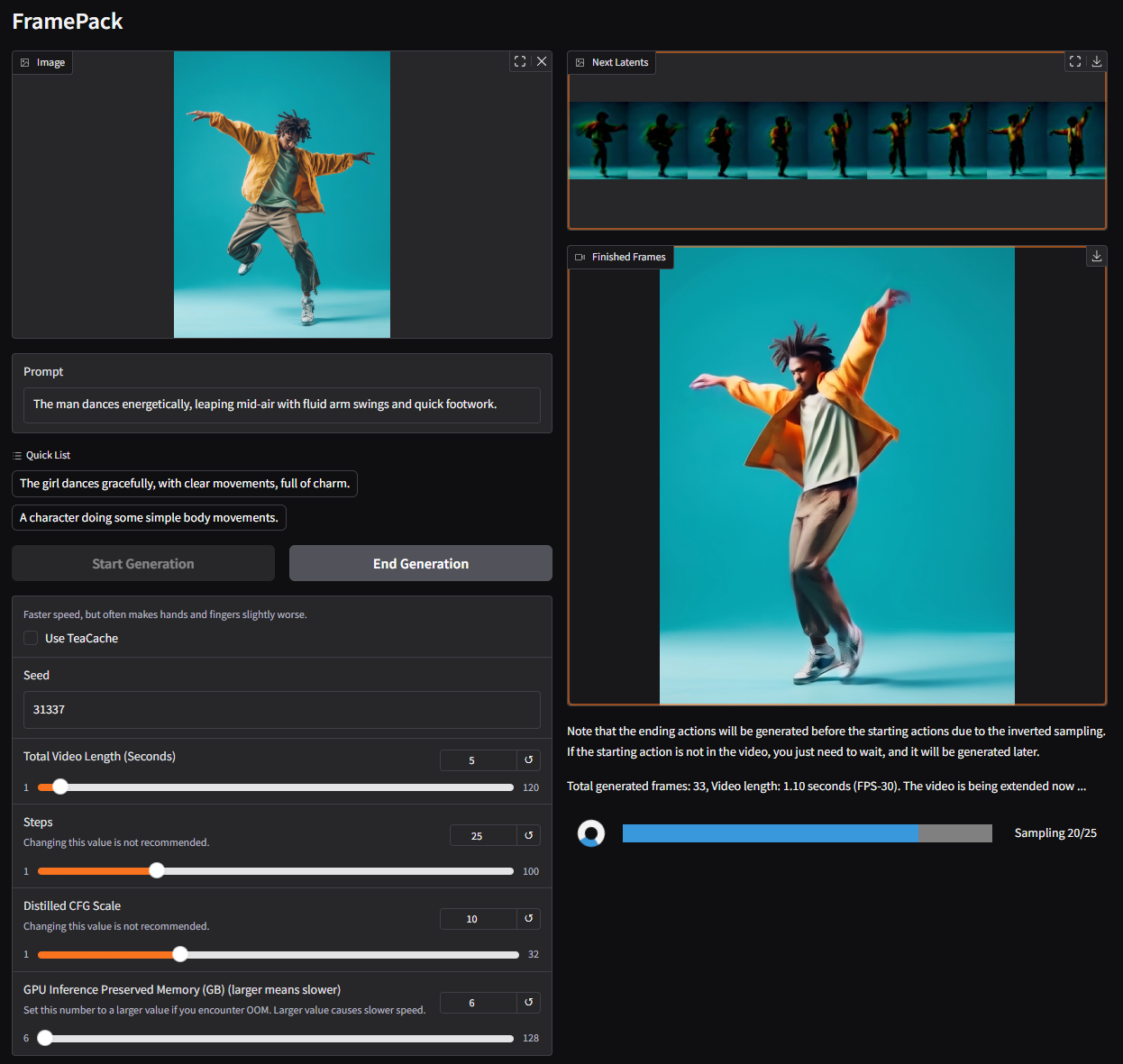

FramePack:让视频生成像玩游戏一样简单!

2025年04月20日

MCPO:让 AI 工具秒变 RESTful API 的“魔法桥梁”!

2025年04月20日

GigaTok:扩展视觉标记器至 30 亿参数用于自回归图像生成

2025年04月20日

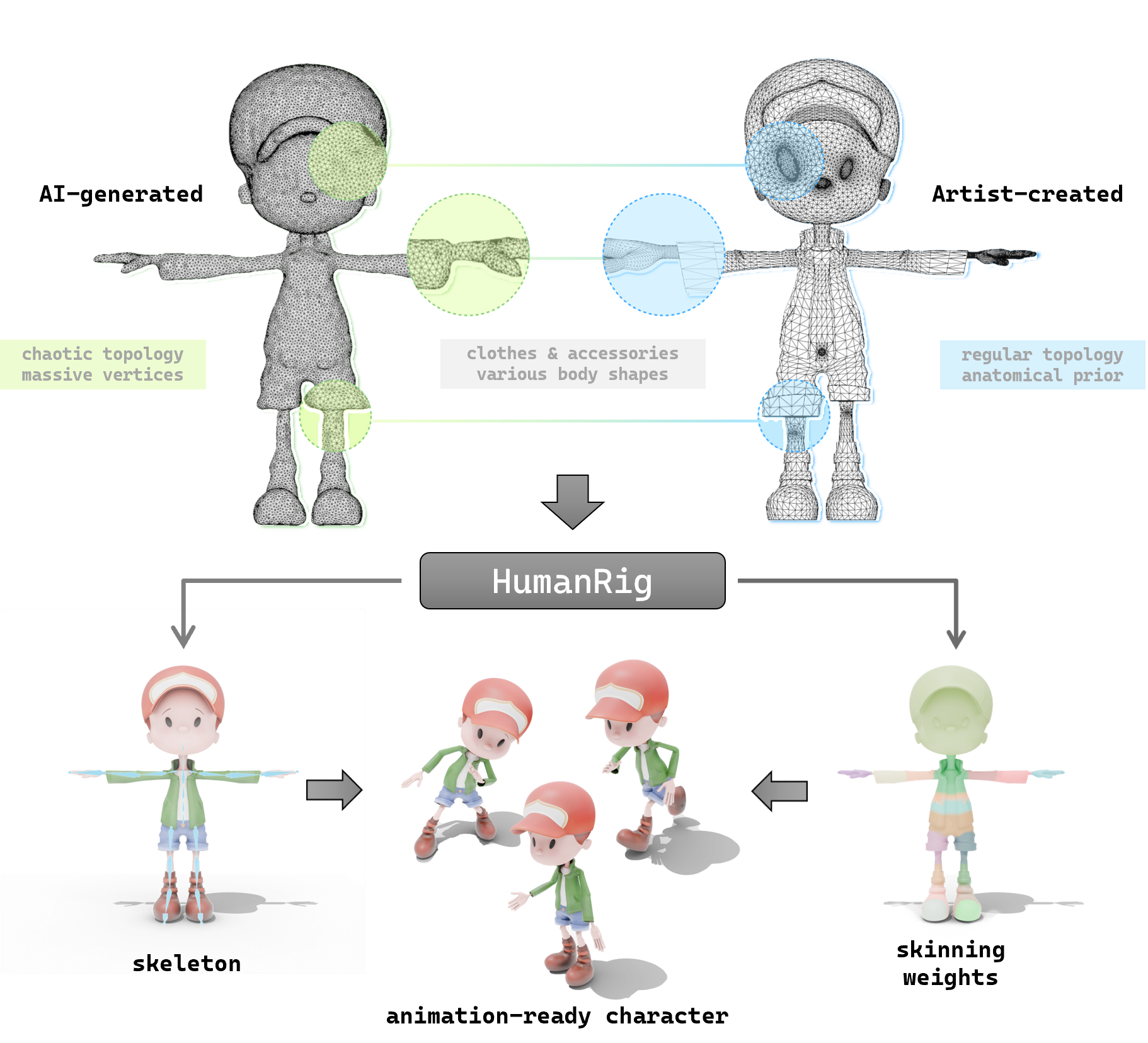

探索 HumanRig:让 3D 角色动画更简单的开源神器

2025年04月20日

探索 so-vits-svc:让你的动漫角色开口唱歌的 AI 神器

2025年04月22日

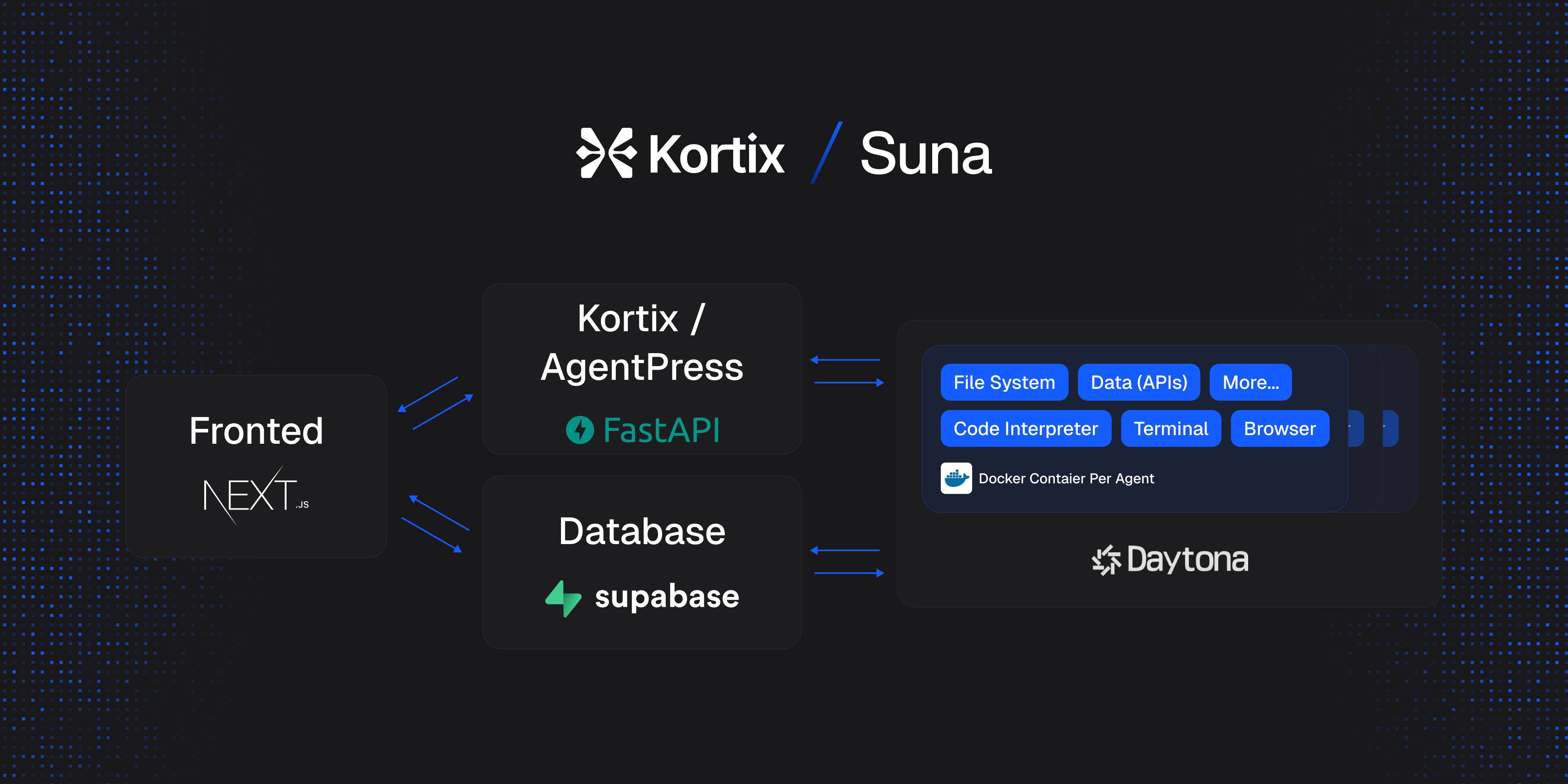

Suna 开源项目介绍:通用 AI 代理的轻松上手指南

2025年04月23日

让 AI 更懂你的网站:一文读懂 llms-txt 开源项目

2025年04月24日