走进 Google Research 开源项目:AI 研究的宝藏仓库

如果你对人工智能(AI)、机器学习(ML)或者前沿科技感兴趣,Google Research 的 GitHub 仓库(https://github.com/google-research/google-research)绝对是一个值得一游的“宝藏”!这个仓库汇聚了 Google 研究团队的众多开源项目,从图像处理到自然语言处理(NLP),从强化学习到生成式 AI,堪称 AI 领域的“全家桶”。今天,我们就来轻松聊聊这个项目的功能、技术架构、核心逻辑、技术栈、上手难度,以及它跟其他类似项目的对比,带你快速上手!

一、项目功能和应用场景:从学术到实用,应有尽有

Google Research 的 GitHub 仓库就像一个巨大的 AI 工具箱,里面装满了各种前沿研究成果的代码和数据集。它的主要功能是通过开源代码和论文的实现,让开发者、研究人员甚至是好奇的初学者能够复现 Google 的研究成果,或者基于这些代码开发自己的项目。

主要功能

- 算法实现:包括 Vision Transformer(ViT)、BERT、T5 等知名模型的官方代码实现,涵盖图像分类、文本生成、语音处理等多个领域。

- 数据集:提供大量高质量数据集,比如 HierText(文本检测)、SCIN(皮肤病图像)等,方便研究人员训练和验证模型。

- 工具库:像 rliable(强化学习评估工具)、SKAI(灾害评估工具)这样的实用工具,能直接用于实际场景。

- 实验复现:几乎每个子项目都配有详细的论文和代码,方便你复现 Google 的实验结果,站在巨人的肩膀上搞研究。

应用场景

- 学术研究:如果你是学生或研究人员,这里是学习最新 AI 算法、复现论文结果的绝佳起点。

- 企业开发:想给你的产品加点 AI 黑科技?可以用这里的代码快速搭建图像识别、文本分析等功能。

- 个人项目:对 AI 感兴趣的开发者可以基于这些代码搞点有趣的小项目,比如训练一个专属的聊天机器人。

二、技术架构:模块化设计,灵活扩展

Google Research 仓库的架构非常模块化,每个子项目都像一个独立的“乐高积木”,可以单独使用,也可以组合起来搭建更复杂的系统。整体来看,仓库的组织方式清晰,按研究方向和功能划分,比如 vision_transformer、language、federated 等子目录。

核心模块

- 模型实现:以 Vision Transformer(ViT)为例,核心模块包括:

- 数据预处理:处理图像输入,转换为适合模型的格式。

- 模型架构:实现 Transformer 的编码器结构,包含多头自注意力(Multi-Head Attention)和前馈网络(Feed-Forward Network)。

- 训练流程:包括优化器(AdamW)、学习率调度和损失函数(交叉熵)的配置。

- 评估模块:提供准确率、F1 分数等指标,方便验证模型效果。

- 工具模块:比如 rliable 提供统计分析工具,帮助评估强化学习算法的稳定性。

- 数据集模块:像 MISeD(会议对话数据集)提供数据加载和预处理的脚本,简化数据管道。

实现逻辑

以 ViT 为例,核心逻辑是把图像切成小块(Patch),通过线性映射转为向量,再丢进 Transformer 模型处理。这种“图像当文本处理”的思路非常巧妙,极大地提升了模型对大规模数据的适应性。代码里通常会把这些步骤拆成独立函数,比如 patch_embedding()、attention(),逻辑清晰,方便修改和调试。

三、技术栈:Python 主导,生态丰富

Google Research 的技术栈以 Python 为核心,搭配一系列主流 AI 框架和工具,堪称“现代化开发标配”。以下是主要技术栈:

- 编程语言:Python(主要),部分项目用 C++(性能优化)、R(统计分析)。

- AI 框架:

- TensorFlow:Google 自家的深度学习框架,适合大规模分布式训练。

- PyTorch:社区最爱的框架,灵活性强,适合快速原型开发。

- JAX:新兴的框架,擅长高性能数值计算,ViT 等项目用得较多。

- 数据处理:

- NumPy/Pandas:数据清洗和矩阵运算。

- OpenCV/PIL:图像处理。

- 环境管理:

- Virtualenv/Conda:隔离项目依赖。

- Docker:部分项目提供容器化部署。

- 其他工具:

- Git:版本管理。

- Colab:部分项目提供 Google Colab 笔记本,直接在云端跑代码。

- Apache 2.0 许可证:代码和数据集开放使用,方便商用和学术。

四、上手难度:中等偏高,适合有基础的玩家

虽然 Google Research 的代码写得比较规范,文档也算齐全,但上手难度还是有点“门槛”。主要原因在于:

- 背景知识:需要了解基本的机器学习概念,比如神经网络、梯度下降、Transformer 等。如果完全零基础,可能会觉得代码里的数学公式有点晕。

- 环境配置:安装 TensorFlow、PyTorch、JAX 等框架不算难,但配置 GPU 环境(比如 CUDA)可能需要折腾一番。

- 代码复杂度:像 ViT 这样的项目,代码量不算小,函数调用关系复杂,阅读需要点耐心。

- 硬件要求:跑大模型需要 GPU(NVIDIA 显卡最佳),没有的话可以用 CPU 或云端 Colab,但速度会慢不少。

适合人群

- 有 Python 基础:熟悉 Python 和 NumPy,能看懂基本的数据处理和模型代码。

- 了解 ML 基础:知道什么是训练集、测试集、损失函数,能看懂简单的论文。

- 愿意折腾:不怕调试环境、改参数,喜欢动手实践。

降低难度的方法

- 从简单的子项目入手,比如

rliable,代码量少,逻辑简单。 - 用 Google Colab 跑代码,省去本地配置的麻烦。

- 看项目的 README 和相关论文,先搞清楚代码的输入输出,再动手改。

总体来说,只要有半年到一年的编程经验(Python + 一点 ML),花点时间啃文档,基本都能跑通代码。

五、与其他项目的对比:独特又互补

Google Research 的仓库在 AI 开源社区里算得上“明星项目”,但也有不少类似的项目,比如 Meta AI 的 FAIR、DeepMind 的仓库、Hugging Face 的 Transformers 等。以下是简单的对比:

| 项目 | 优势 | 不足 | 适合场景 |

|---|---|---|---|

| Google Research | 覆盖面广,学术+实用结合,官方实现权威 | 子项目多,略显杂乱,部分文档不够详细 | 想复现论文或找灵感的学术/开发者 |

| Meta AI FAIR | 聚焦 PyTorch,代码风格统一,社区活跃 | 项目偏学术,实用性稍弱 | PyTorch 爱好者,偏研究 |

| DeepMind | 强化学习和前沿理论强,代码质量高 | 项目较少,更新慢 | 强化学习和理论研究 |

| Hugging Face Transformers | NLP 领域一哥,模型即插即用,文档友好 | 偏 NLP,图像等领域覆盖少 | 想快速部署 NLP 模型的开发者 |

总结:Google Research 的优势是“全能”,几乎啥领域都有涉猎,适合想“一站式”学习 AI 的玩家。如果你是 NLP 专精,Hugging Face 可能更直接;如果是强化学习,DeepMind 更专注。但 Google Research 的代码和数据集的权威性(毕竟是论文原作者写的)是其他项目没法比的。

六、总结:AI 世界的“瑞士军刀”

总的来说,Google Research 的 GitHub 仓库就像一把 AI 领域的“瑞士军刀”,功能强大、用途广泛。无论你是想复现一篇顶会论文、给公司项目加点 AI 料,还是单纯对前沿科技好奇,这个仓库都能给你惊喜。它的技术栈现代化(Python + TensorFlow/PyTorch/JAX),模块化设计方便扩展,上手难度适中(有基础就能玩),而且跟其他项目比,它更像一个“全能选手”。

当然,初学者可能会被代码量和数学公式吓一跳,但只要从简单的子项目入手,跟着 README 一步步来,很快就能跑出成果。推荐你克隆一份仓库,挑个感兴趣的项目(比如 ViT 或 rliable),在 Colab 里跑跑看,说不定下一个 AI 大作就是你搞出来的!

最后,如果你对某个子项目有疑问,或者想聊聊 AI 的新鲜事,欢迎留言交流!😄

AutoGPT:让AI帮你“自动搞定一切”的开源神器

2025年04月11日

GPT-Pilot:你的AI编程助手,带你从零打造应用!

2025年04月19日

LocalAI:你的本地AI神器,轻松打造专属智能应用!

2025年04月19日

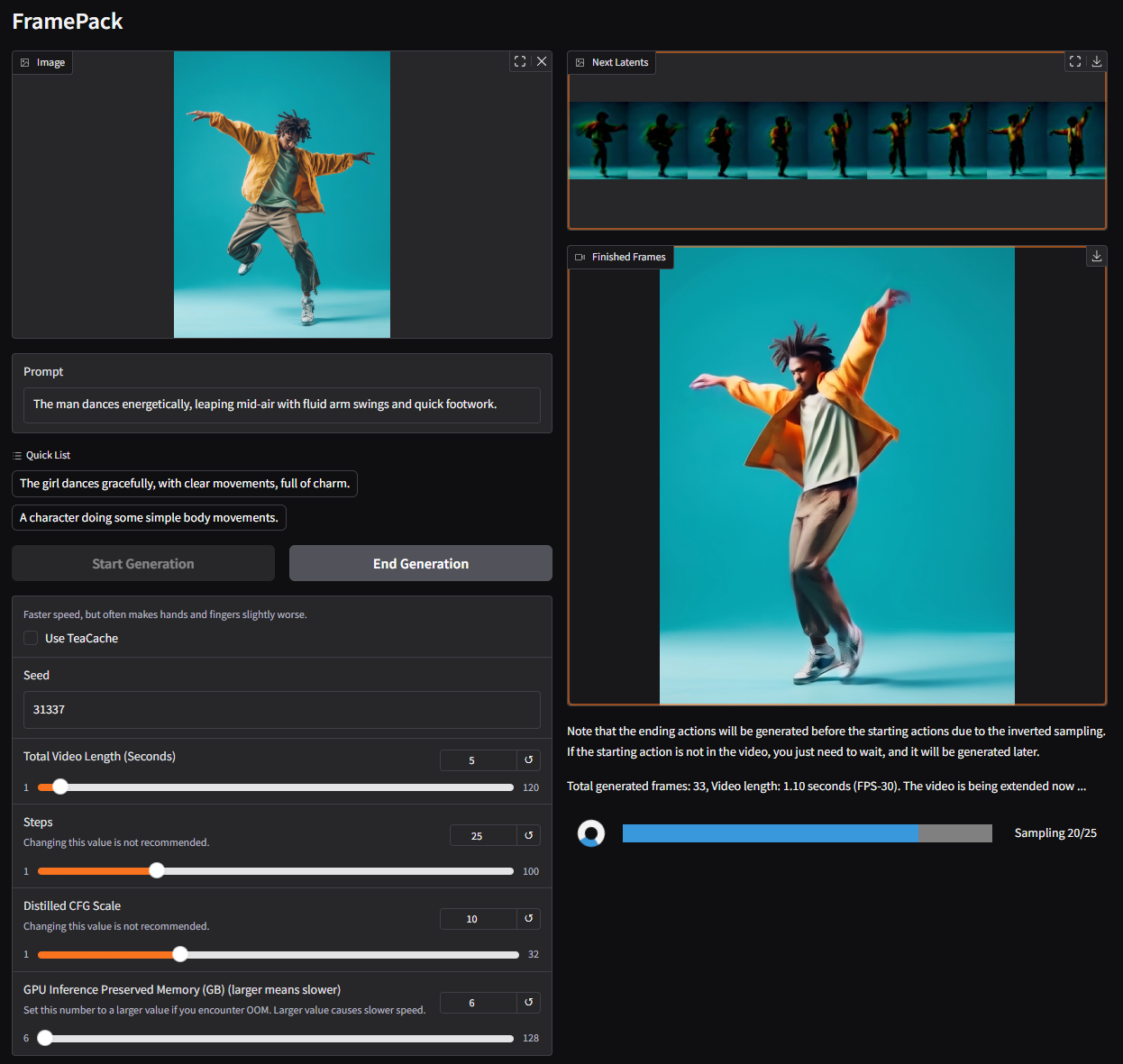

FramePack:让视频生成像玩游戏一样简单!

2025年04月20日

MCPO:让 AI 工具秒变 RESTful API 的“魔法桥梁”!

2025年04月20日

GigaTok:扩展视觉标记器至 30 亿参数用于自回归图像生成

2025年04月20日

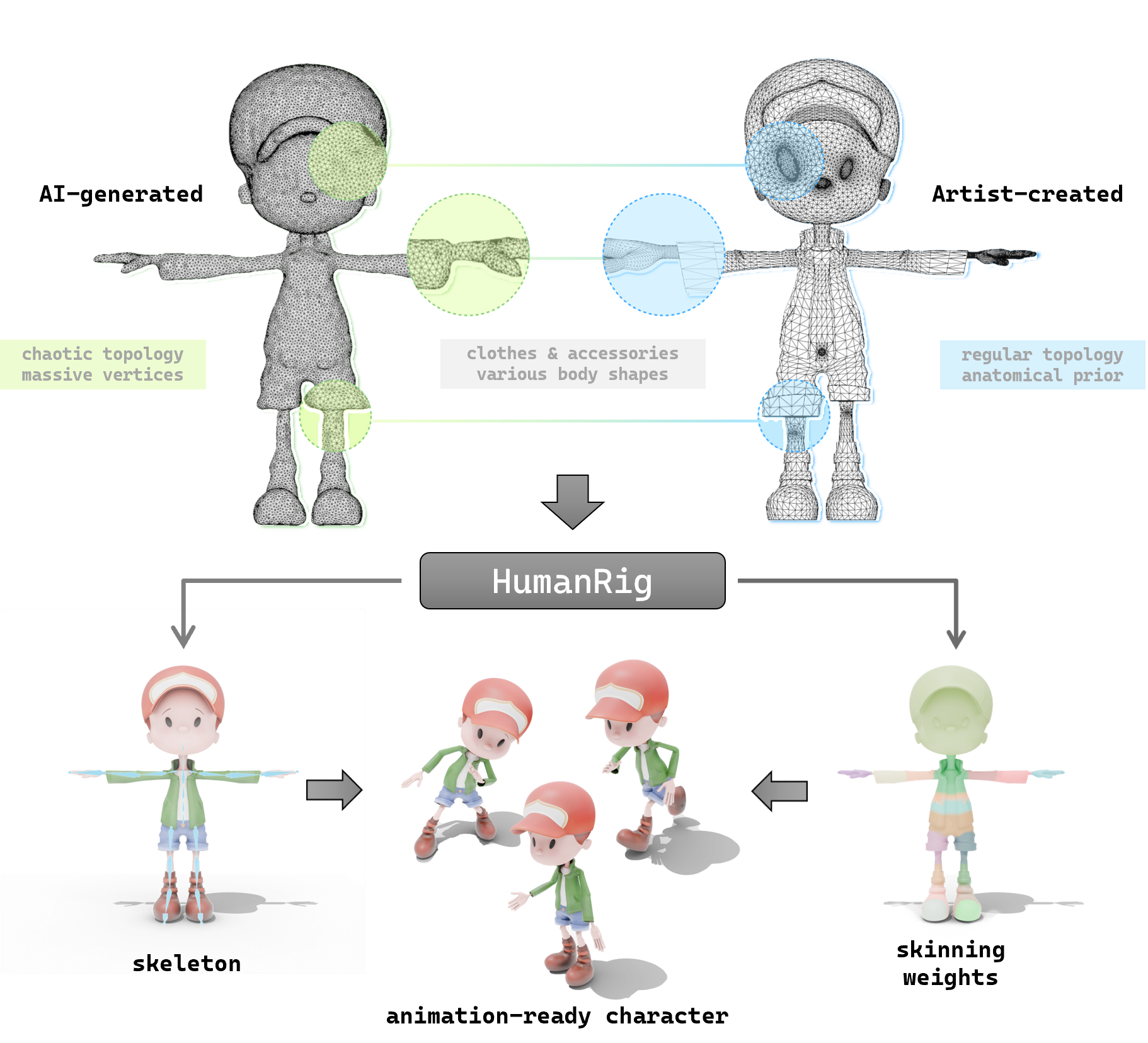

探索 HumanRig:让 3D 角色动画更简单的开源神器

2025年04月20日

探索 so-vits-svc:让你的动漫角色开口唱歌的 AI 神器

2025年04月22日

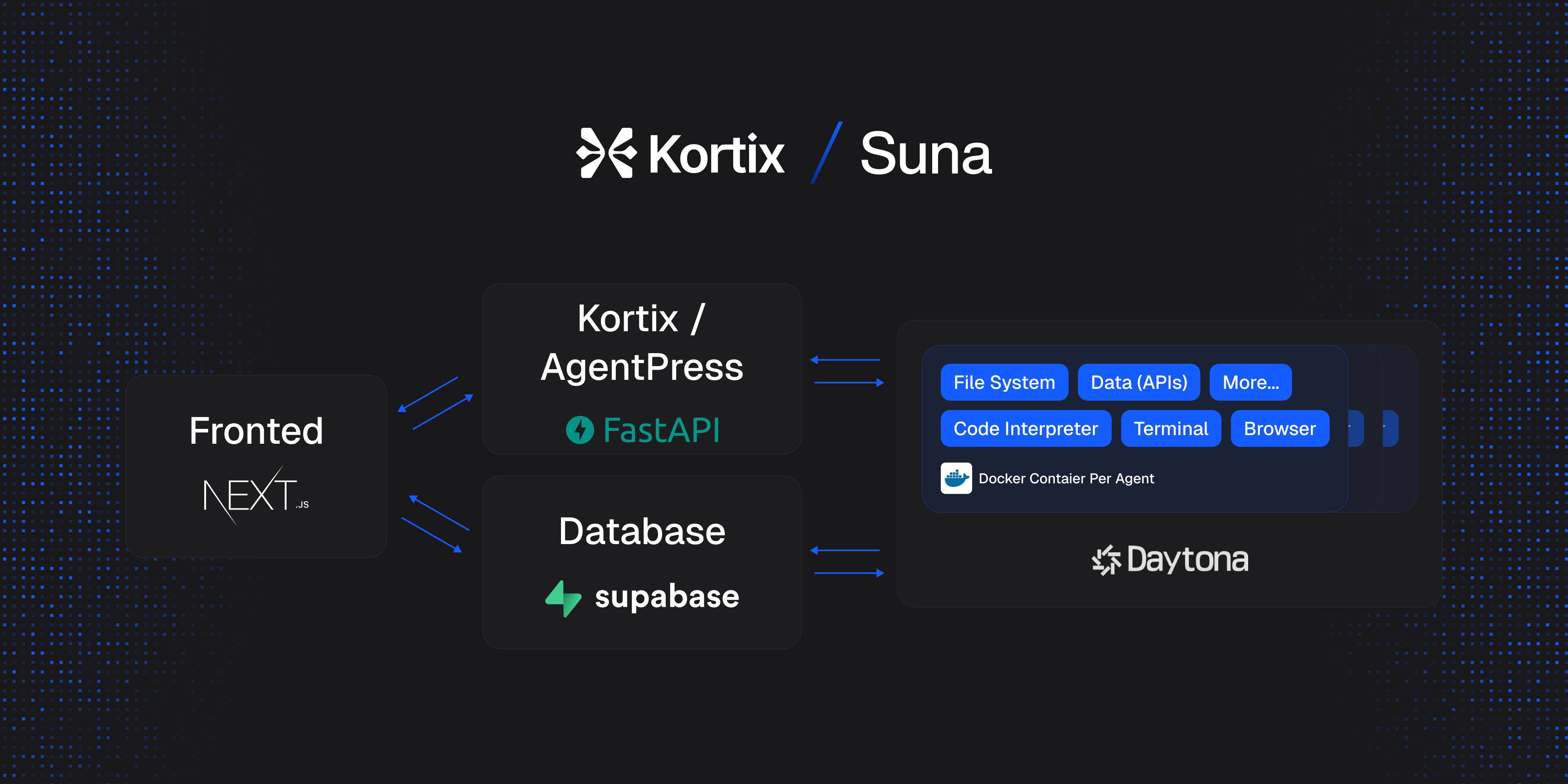

Suna 开源项目介绍:通用 AI 代理的轻松上手指南

2025年04月23日

让 AI 更懂你的网站:一文读懂 llms-txt 开源项目

2025年04月24日